Обновил: Сергей Ломакин

«Панда», «Пингвин», «Колибри» — широкой аудитории прекрасно известны только самые крупные обновления алгоритмов Гугл. А меж тем, их гораздо больше: в 2010 году Google внес около 516 изменений в свои алгоритмы, в 2016 — 1653, в 2018 году — 3234. Динамика нарастающая…

Поисковые системы значительно «поумнели» и обмануть их методами, актуальными на заре становления рунета, уже не получится. Давайте посмотрим, какие SEO методы ушли в прошлое, а какие все еще актуальны и их можно использовать для поискового продвижения.

Обмен ссылками — не работает

Обмен ссылками — практика, при которой два сайта соглашаются ссылаться друг на друга, чтобы улучшить свой условный рейтинг в Google и Яндекс. Около пяти лет назад обмен ссылками хорошо работал. Процветали ссылочные биржи и другие подобные сервисы. В 2023 году этот прием больше не работает как прежде.

Google заявила: обмен ссылками не может считаться законным способом формирования ссылочного профиля качественного сайта. Фактически, Google может даже наказывать сайты, участвующие в таких схемах.

Почему это не одобряют поисковые системы:

- Обмен ссылками часто осуществляется неестественным и манипулятивным способом. Характерный маркер — не совпадающая тематика у двух сайтов;

- Вебмастеры, которые практикуют массовый обмен ссылками, часто забывают о самом главном — о качестве контента;

- Для продвижения используются ссылочные помойки, но никакого эффекта на условный рейтинг в результатах поиска такие доноры вообще не оказывают.

Также не приветствуются:

- спам ключевыми словами в анкорах;

- замена символов;

- нечитаемый размер шрифта;

- странное расположение URL на странице.

Если вы практикуете что-то из этого списка, то ждите пессимизацию домена.

Анкоры на внутренних и внешних URL с ключевыми словами имеют право на жизнь, но главное — не допускать переспама и соблюдать принцип строгой релевантности. Позиции вы таким способ не улучшите, но это может помочь внутренней оптимизации. В случае использования внешних ссылок следите за качеством «донора» (об этом читайте ниже).

Александр Белов, ведущий аналитик TexTerra: «Основная проблема даже не в том, что обмен ссылками не работает, а в том, что найти качественный хаб или авторитет, и при этом иметь заинтересованность друг в друге — крайне сложно. Ссылки должны иметь переходы, чтобы переносить свой вес как следует, поэтому размещать «абы где» не хочется. Однако, иногда приходят достаточно неплохие предложения разным клиентам, и мы можем пойти на такое»

Полезные и бесполезные ссылки. Как получить именно полезную ссылку

Для начала краткий ликбез по ссылкам:

- Полезные ссылки — это ссылки, которые располагаются на качественных, трастовых сайтах (донор должен быть авторитетным, обладать высоким ИКС и PageRank). Еще одно обязательное условие полезной ссылки — тематическая релевантность акцептору и уникальность в пределах сайта.

- Плохие ссылки — это URL, имеющие нерелевантные и заспамленные анкоры. О плохом качестве ссылки скажут низкие метрики Domain Authority и Page Authority. Если ссылка расположена на сайте, который зарегистрирован на бирже ссылок или сам донор представляет из себя ссылочную свалку, то алгоритмы Google обязательно учтут такие сигналы.

- Внешняя ссылка — это ссылка, которая расположена на другом сайте и ведет на страницы вашего сайта.

- Ссылка может быть неработающей, если на запрос робот получил HTTP-статус отличный от 2XX или 3XX.

- Ссылка считается удаленной, если робот не обнаружил ее при очередном обходе сайта-источника или страница с ней была временно недоступна.

- Если администратор сайта установил или снял ссылку, изменения отразятся в Яндекс.Вебмастере после переиндексации роботом.

На что обращать внимание:

Сосредоточьтесь на качестве ссылки, а не на количестве. Неестественные, некачественные, скрытые или ненужные ссылки — нужно удалять, например, у Google для этого есть инструмент Disavow Tool. Пять ссылок с качественных, высокотрастовых доменов гораздо лучше, чем 150 URL с «ссылочных помоек».

Обязательно учитывайте направление акцептора: донор с тематикой о продуктах питания и акцептор о спортивной обуви — плохое сочетание для линкбилдинга.

Обязательно проверяйте количество страниц в индексе у донора. Часто на биржах попадаются спам-площадки и мошенники: количество страниц у них в индексе минимальное или вообще отсутствует. Google довольно быстро увидит неестественные ссылки и не будет учитывать в ссылочном профиле продвигаемого сайта (как фактор ранжирования).

Как усилить ссылки с тематических доноров

Любой качественный сайт постепенно сам обрастает качественной ссылочной массой. Но при одном условии — если сайт предоставляет по-настоящему полезный контент, улучшающий пользовательский опыт. Со временем другие сайты сами начнут ссылаться на такой ресурс. Кстати, по наблюдению многих вебмастеров и SEO-специалистов, ссылки в естественном пользовательском контенте (например, в секции комментариев) дают больший эффект, чем просто ссылка в контенте страницы. Лучше, чтобы ссылки переводили на самые важные страницы домена-акцептора, которые приносят трафик, отличаются высокими поведенческими факторами.

Посты с ссылками в социальных сетях также могут влиять на ссылочную массу продвигаемого сайта — если распространяемый контент завирусится, на него начнут ссылаться крупные авторитетные домены.

Итого, на что обратить внимание:

- Page Rank / ИКС, тематику и посещаемость сайта.

- Релевантность домена, релевантность темы сайта.

- Надежностость домена. Можно проверить TF, PR, ИКС и другие показатели домена (Moz, DE).

- Места размещения — ссылки располагаются в тексте естественно. Без спама.

- Разнообразие анкорного текста — сочетание информационной семантики с минимум коммерческой.

- Тематическую релевантность страницы реципиента и донора.

- Разнообразие — естественный ссылочный профиль включает в себя URL с сайтов разного типа: каталоги, информационные сайты, соцсети, коммерческие сайты.

Как и где проверить ссылки

Большинство сервисов — не российские и, к сожалению, с введением санкций пользоваться многими из них стало затруднительно. Поэтому мы разбили рекомендуемые ресурсы на две группы: доступны в РФ без ограничений; необходим VPN. Выбирайте, что для вас приемлемо на данный момент.

1 группа: доступны в РФ в 2023 году без ограничений

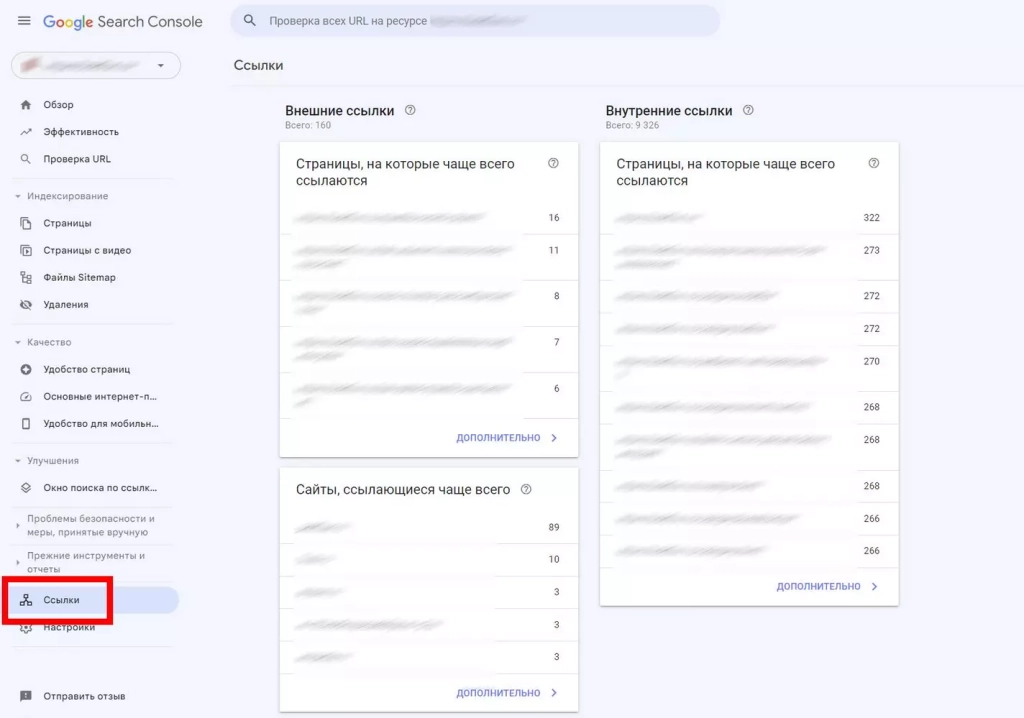

Google Search Console — старые-добрые инструменты вебмастера от Google. В них есть весьма подробные отчеты и о ссылках вашего сайта (ссылки других сайтов оценить не удастся): вы можете просматривать обратные ссылки, сравнивать с конкурентами и выявлять проблемы.

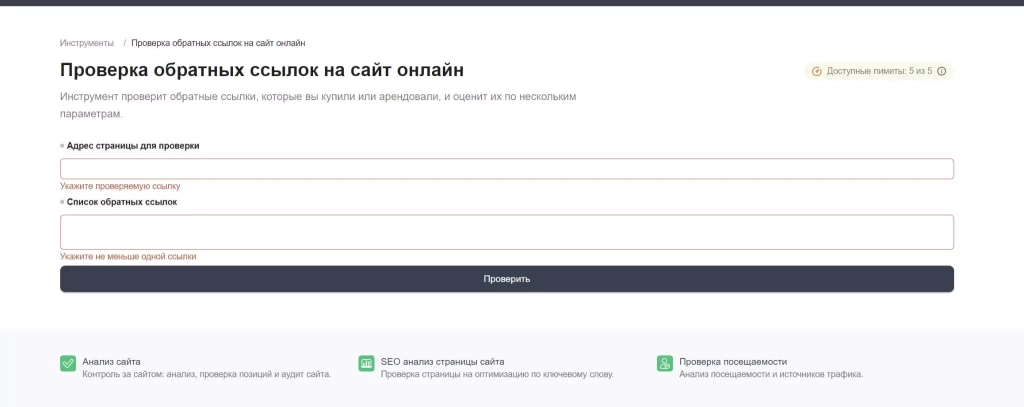

Яндекс.Вебмастер — есть отдельные отчеты по ссылкам. Проверять можно только свой сайт, соответственно.

PR-CY — инструмент для исследования входящих и исходящих ссылок. Можно проверять как свои, так и чужие сайты. Вы увидите данные о количестве внешних и внутренних линков на странице, наличии атрибута nofollow и URL-адресах ссылок с текстовым контекстом. PR-CY позволяет анализировать ссылки на домашней странице или на любом другом внутреннем разделе сайта.

2 группа: инструменты работающие в РФ только с VPN

Перед переходом на сайт придется включите VPN (еще одно условие — ГЕО серверов VPN должен быть не Казахстан).

Majestic — собственные метрики сервиса (поток доверия, поток цитирований) позволят проверить ссылочный профиль любого сайта). Можно отслеживать изменения с течением времени.

SEMrush — интегрированная аналитика ссылок любого сайта. Удобно изучать авторитет домена.

Moz Open Site Explorer — бесплатная панель инструментов, есть сопутствующие данные по ссылкам.

Как видим, сервисов для проверки ссылок очень много. Однозначно, стоит обратить особое внимание на

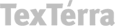

Ahrefs — один из лучших. Это мощный инструмент для анализа ссылочной массы любого сайта. Вы можете проанализировать профиль домена, проверить его рейтинг, анкоры и многое другое. Очень удобно для анализа ссылок доменов-конкурентов.

На этом ресурсе также есть много других инструментов для поискового продвижения, включая сервисы для проверки ссылочного профиля и обратных ссылок.

Ahrefs позволяет анализировать ссылки по пяти параметрам:

- Ahrefs Rank (AR) — внутренняя метрика Ahrefs для обозначения качества ссылки;

- URL Rating (UR) — рейтинг URL показывает потенциал ссылочного профиля страницы (чем больше число, тем сильнее ссылочный профиль страницы);

- Domain Rating (DR) — рейтинг показывает потенциал ссылочного профиля домена (он строится с учетом бэклинков других сайтов, и, по сути, — это просто менее детализированная версия Ahrefs Rank (AR));

- суммарное количество бэклинков;

- суммарное количество ссылающихся сайтов.

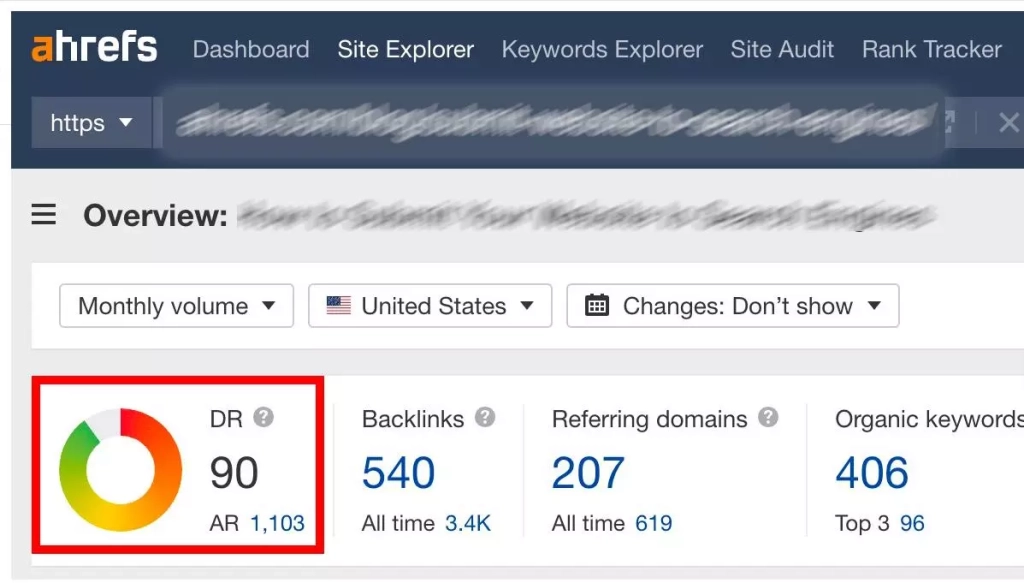

- Если вы не хотите разбираться в инструментариях и собственных метриках Ahrefs, то вот вам хорошая альтернатива. Этот инструмент проверки внешних ссылок — Pr-Cy.

Он позволяет быстро проанализировать ссылочный профиль любого домена, включая конкурентные сайты. Здесь нет перегруженности функциями — только проверка ссылок.

Инструмент проверки внешних ссылок Pr-Cy позволит контролировать их платное размещение, оценивать СМ и органический прирост URL. А еще с его помощью удобно просматривать удаленные или закрытые URL.

Вводим домен и URL, на которых присутствуют внешние ссылки, на ваш сайт. Нажимаем кнопку «Проверить»:

Зеленым цветом выделяются существующие ссылки, красным — несуществующие и закрытые атрибутом nofollow.

Посмотреть изменения ссылочного профиля собственного сайта можно в «Яндекс.Вебмастере»:

Получить список самых часто ссылающихся доменов позволяет Google Search Console.

При этом следует отметить удобство отслеживания страниц и доменов, которые ссылались на ваш сайт чаще других (см. отчет по внешним ссылкам). Также здесь можно получить список анкоров у ссылок (отчет по самым распространенным текста ссылок).

Как видите, ресурсов много, так что выбирать есть из чего.

Какой использовать анкор для ссылки

Текст анкора должен соответствовать содержанию страницы, на которую ссылается URL. Для анкора это очень важно, ведь такой текст помогает поисковым системам понять контекст ссылки, ее релевантность.

Ключевые слова в анкорах нужно использовать очень аккуратно. Не злоупотребляйте ими, так как поисковые системы могут расценить это как спам.

Сделайте анкор максимально коротким и лаконичным. Длинный текст может быть труден для чтения, кроме того слишком большая длина — маркер спама.

Старайтесь использовать уникальный текст для каждого анкора. Так Google и Яндекс будут видеть, что каждая URL ведет на с разным содержанием.

Какой текст использовать для анкора. Примеры

Избегайте использования анкоров с неестественными текстами (наподобие «нажмите здесь»). Она не предоставляет никакой полезной информации (как людям, так и поисковым системам).

Лучший текст анкора — описательный. То есть тот, который сообщает пользователям, что они могут найти на странице, на которую перейдут.

Ниже несколько примеров пар хороших и плохих анкоров:

- Хорошо: «Узнайте больше о SEO» / Плохо: «Нажмите здесь».

- Хорошо: «Закажите крем со скидкой» / Плохо: «Нажмите здесь, чтобы заказать».

- Хорошо: «Прочитать полную версию поста в блоге» / Плохо: «Нажмите здесь, чтобы прочитать наш пост в блоге про SEO».

Анкор внутри сайта должен быть уникальным. Максимальная длина — 4 слова. Отметим, что прямые вхождения лучше разбавлять и делать их более реалистичными, особенно это касается коммерческих типов анкоров. Поисковый спам в анкорах недопустим — фраза должна быть естественной, то есть околоссылочный текст должен быть полезным.

Лайфхаки по крауду

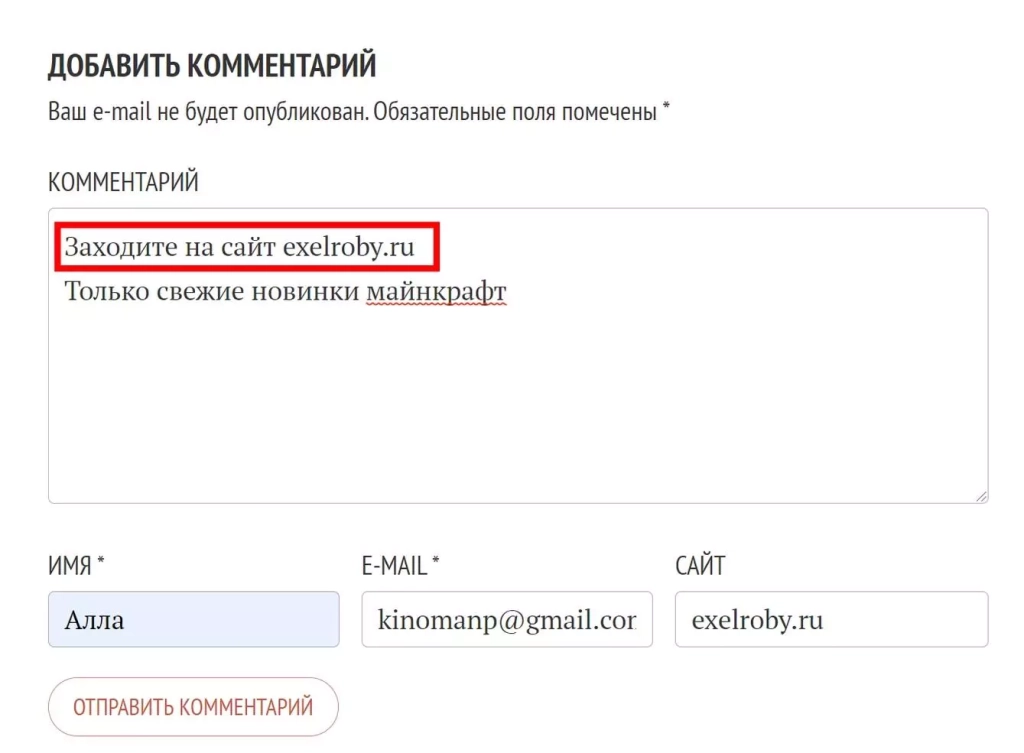

Крауд-ссылка — это ссылка, органично вписанная в текст отзыва или комментария, которая ведет на сайт продвигаемой компании. Но на практике все совсем не так: крауд в реальности часто становится синонимом стратегии линкбилдинга, которая предполагает получение ссылок с большого количества некачественных доноров.

Обычно крауд-ссылки получают размещая посты с URL на форумах, комментируя блоги или отправляя статьи в каталоги.

Какие площадки использовать:

Используйте различные сайты! Не размещайте посты с ссылкой только на одном или двух форумах. Не надо спамить комментарии информационных сайтов, например, тематических блогов без разрешения владельца. Такие ссылки все равно не пройдут проверку. Еще раз — сосредоточьтесь на качестве, а не на количестве. Лучше иметь несколько высококачественных ссылок, чем большое количество некачественных.

Убедитесь, что крауд-ссылки полностью или хотя бы частично соответствуют тематике продвигаемого сайта, имеют хорошую репутацию.

С какой частотой и в каком количестве:

Не переусердствуйте. Крауд-ссылки могут быть мощным инструментом, но важно использовать их в меру. Если вы создадите слишком много краудфандинговых ссылок слишком быстро, это может серьезно повредить SEO. Если вы заметили, что видимость сайта в поиске начала снижаться или упала посещаемость — это может быть как раз потому, что вы переусердствовали с крауд-ссылками.

Кстати, есть специальные сервисы для создания крауд-ссылок: российский SAPE и зарубежные Ahrefs, SEMrush и Majestic.

И не бойтесь передавать создание крауд-ссылок на аутсорсинг. Если у вас нет времени или ресурсов для покупки таких URL — пользуйтесь исполнителями с фриланс-бирж, платформами Rookee, Sape, Linkum.

Как скоро будет результат:

Будьте терпеливы. Создание краудфандинговых связей требует времени и усилий. Не ожидайте увидеть результаты в одночасье. Просто продолжайте наращивать ссылочную массу, платно, без скачков. И в конечном итоге вы увидите, что сайт станет получать больше трафика.

А теперь — мои наработки по крауд-ссылкам, которыми я занимаюсь около трех лет:

- абсолютно все арендные ссылки — в утиль;

- делайте посевы в Telegram и внутри социальных сетей;

- усиливайте самые перспективные страницы. Если говорить цифрами, то это страницы в диапазоне с 6-7 по 20 место (условно);

- разнообразьте ссылочную массу;

- создавайте стабильные потоки новых URL с качественных доноров.

Что запомнить: крауд-ссылки могут быть эффективным способом улучшения ссылочного профиля, но важно использовать их в умеренных количествах и уделять больше внимания качеству доноров, чем их количеству.

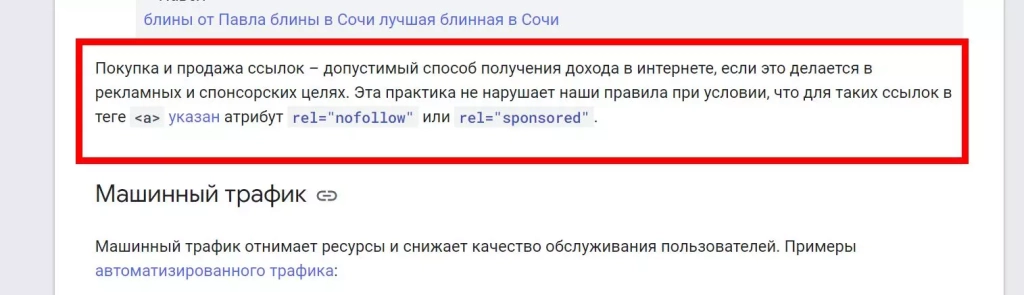

Платные ссылки — не работает

Имеются в виду ссылки с атрибутами sponsored и UGC, которые размещаются на сайте в обмен на оплату. Хотя платные ссылки с трастовых доменов и могут быть эффективным способом привлечения трафика в краткосрок, но по настоящему работающей SEO-стратегией из не назовешь. Почему? Потому что это форма манипулирования ссылочной массой домена, а это уже явное нарушение правил Google. У Google есть свои алгоритмы для обнаружения платных ссылок: если ПС обнаруживает такие ссылки и попытки манипулирования результатами поисковой выдачи, сайт-нарушитель пессимизируется.

Кроме того, ссылки с атрибутом sponsored и UGC чаще всего просто очень низкого качества. Такие размещаются на спамных донорах, включая ссылочные помойки. По этим причинам и не рекомендуется использовать платные ссылки (sponsored и UGC) для SEO.

Если вы хотите улучшить SEO сайта есть ряд других, более эффективных, способов сделать это: создание высококачественного контента, посевы в мессенджерах и соцсетях, постраничное SEO. Кроме того платные ссылки сами по себе имеют массу недостатков: во-первых, это дорого (особенно если речь идет о линках с трастовых доменов), во-вторых — их трудно отслеживать (статистика по sponsored-ссылкам более скудная).

Биржи ссылок существуют и сегодня. Они не умерли и по-прежнему обещают заработок вебмастеру и продвижение рекламодателю. Вроде все довольны, но здесь одно «но» — продвижение платными ссылками больше не работает, а выгоду получает только биржа. Безусловно, вы можете возразить: «Ну ведь бывают и хорошие, очень качественные доноры с огромными ИКС и Page Rank!». Да, бывают, не спорю. Но алгоритмы поисковых систем изучают не только непосредственное качество домена или сайта, но и анализируют саму ссылку, исходя из релевантности страницы и релевантности контента, расположенного на ней.

Александр Белов, ведущий аналитик TexTerra: «Биржи могут быть разные, мы смотрим не только на КАЧЕСТВО площадок, но и на другие факторы "жизни" : дату последнего размещения материала, качество материала, на сколько разные темы охватываются на площадках, каков общий трафик, как глубоко будет находиться статья, которую мы разместили, и т.д. Только при полном анализе качества можно покупать ссылку, но опять же, важно четко понимать — какие биржи вы используете и что покупаете. Например, в рамках нашего продвижения мы заказываем не только ссылку, но и текст под него. Поэтому, если площадка прошла наш первичный отбор — на бирже или в серпе — мы с ней связываемся и заказываем написание статьи с конкретными ссылками. Эта статья еще так же будет пушиться в соц сетях, емейлах , на главной странице и т.д.»

Если ссылка абсолютно не соответствует странице, то авторитет домены становится второстепенным фактором ранжирования. Алгоритмы «понимают», что ссылка покупная и не учитывают ее вообще.

Ошибочно думать, что Google настроен против всех платных ссылок. Поисковая система допускает покупку и продажу URL для заработка вебмастера. Но в этом случае обязательно выделяйте такие ссылки одним из двух способов:

Как видите, работы немало и разбираться придется во всех тонкостях. Если вам это не по силам, доверьте дело профессионалам, это точно будет эффективнее, а в конечном счете и дешевле.

Атрибуты покупных ссылок и как они передают вес

Для «покупных» ссылок Google ввел два атрибута: ugc (для пользовательского контента) и sponsored (для покупных и рекламных ссылок). Ссылки с вышеуказанными атрибутами никак не передают свой вес. Вес могут передать только dofollow-ссылки.

Как вес передает UTM, UGC и sponsored? Какие атрибуты и как воспринимаются поисковыми системами?

Краулеры действительно идентифицируют UTM-параметры в ссылке, причем все. Но о передаче веса речь не идет.

Давайте еще раз подытожим главное:

- Dofollow-ссылки вес передают;

- Nofollow-ссылки — вес не передают;

- Ссылки с атрибутами UGC / UTM / sponsored нужны для одной цели — более точное определение источника перехода. И никакой вес они передать не могут.

Единственная опасность — дублирование ссылочного контента. Чтобы ее избежать, настройте атрибут каноникал для главной страницы.

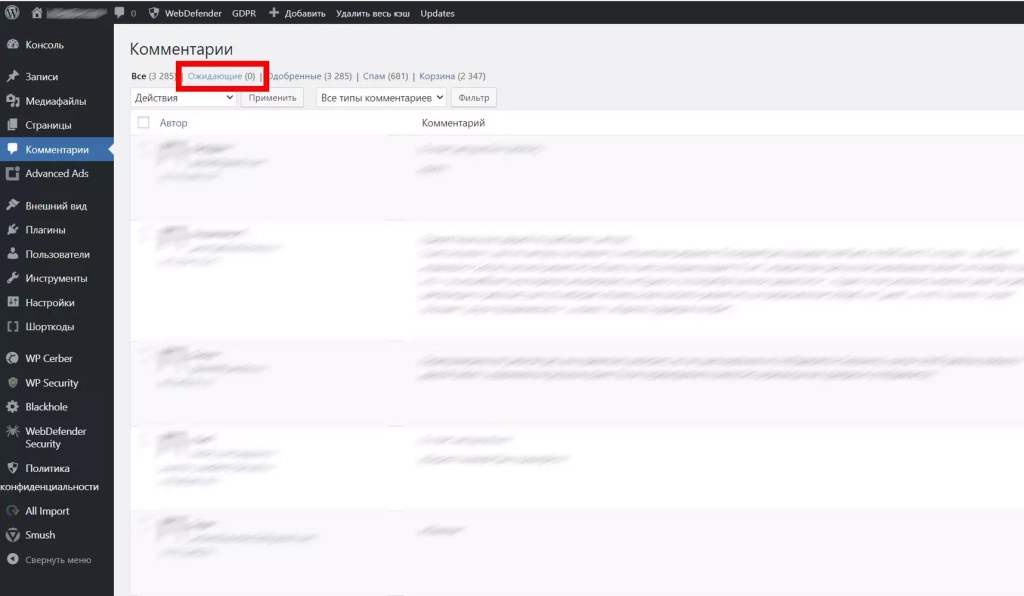

Размещение URL своего сайта в комментариях на других сайтах — работает частично

Ссылки на тематически релевантном и качественном доноре не навредят продвигаемому сайту, но только если это не ссылочная свалка (сайт, созданный специально для продажи ссылок, на таких сайтах очень много нерелевантных внешних URL). Сложность заключается в другом — в самом размещении. Оставить ссылку в комментариях, без договоренностей с администрацией сайта, точно не получится. Донор действительно живой и посещаемый? Значит ваш URL с высокой долей вероятности будет удален администратором.

Большинство современных CMS позволяют публиковать новые комментарии только после модерации. А комментарии со ссылкой не пропустит не один администратор. Таким образом, вашу ссылку точно заметят и удалят.

Огромное значение имеет качество донора: спамность его страниц, возраст домена, тематика, количество страниц в индексе, ссылочный профиль, поведенческие факторы трафика. Ссылки на мусорных сайтах без определенной тематики не дадут никаких бонусов продвигаемому сайту.

Александр Белов, ведущий аналитик TexTerra: «Такие действия не только приводят пользователей с других проектов, но приносят и другой эффект. Мы похожим способом увеличивали трафик крупных сайтов в два раза, только внедрив добавление домена сайта при копировании. По итогу, когда пользователи забирали с нашего сайта какую то информацию, они автоматом в буфер сохраняли источник в виде домена. Кто-то вставляет информацию на сайте с доменом, кто-то без. Например, в соцсетях чаще оставляют, что так же увеличивает цитируемость и положительно влияет на проект».

Покупка трастового чужого домена для продвижения сайта — работает частично

В теории дроп-домены — просто сказка. Судите сами: уже есть трафик и какой-никакой ссылочный профиль, возраст домена может быть и 5, и 10 лет, что также полезно для дальнейшего продвижения. Но на практике «дропнутые» домены на то и «дропнутые» — у них обязательно есть какие-то проблемы. Например, нет никакой гарантии, что домен действительно был дропнут законным образом. А еще, возможно, на нем фильтр или пессимизация, ограничения по монетизации и так далее.

Домен может быть, привязан к разным сервисам, например, к веб-аналитике. Вы потратите много времени, чтобы найти все такие сервисы и в итоге будет неприятно, когда ваш сайт нельзя будет добавить в Google Search Console, например.

Искусственно накрученные метрики авторитета домена, поведенческие факторы с имитацией действий пользователя — эти и другие накрутки сложно отследить. Но, они могут преследовать, домен ещё долгое время и остаться с ним навсегда.

Вы не контролируете то, что было ранее сделано с доменом, поэтому проблемы могут возникнуть и позже. Например, от кривой SEO-оптимизации позиции сайта через пару недель после покупки могут обрушиться, а трафик — исчезнуть.

В долгосрочной перспективе может оказаться дешевле создать свой собственный сайт, даже с нуля.

Чаще всего проблемы такие: искусственно нарощенный ИКС и PageRank, целый букет фильтров от «Гугла» и «Яндекса», большое количество мусорных ссылок. Поэтому внимательно проверяйте историю домена перед покупкой. Искать дропнутые домены можно через сервис Expired Domains. Больше об этом читайте здесь.

Имитация действий реальных пользователей — не работает

Имитация действий пользователей, ботовский трафик и другие мошеннические методы не просто не дадут никакой пользы сайту — они только навредят.

Google и Яндекс умеют определять не только качество доменов, ссылок, но и неестественный трафик. Им очень легко распознать манипуляцию.

Даже если на начальном этапе накрутки будут видны некоторые выгоды (рост посещаемости и улучшение поведенческих факторов), все это не будет продолжаться долго. В итоге сайт будет пессимизирован и пропадет из выдачи полностью или частично.

Что запомнить:

- Реально высокое вовлечение пользователей, высокие поведенческие факторы — это сигналы качественного сайта. Накрутки вообще не учитываются ПС.

- Лучше сосредоточить усилия на создании экспертного контента и улучшении пользовательского опыта — это наиболее разумная долгосрочная стратегия.

У «Яндекса» даже есть фильтр с таким названием. Действия имитируются с помощью ботов и делается это для улучшения поведенческих факторов посетителей. Несколько лет назад такой способ продвижения давал неплохие результаты, однако поисковые системы очень быстро научились идентифицировать накрутки. По опыту, Google относится к имитации действий лояльнее, чем «Яндекс». Пользоваться этим видом накрутки точно не стоит, вас все равно выведут на чистую воду — это лишь вопрос времени.

Что значит «имитация действий пользователя»

Имитация действий реальных пользователей — это накрутки трафика и поведенческих факторов. То есть это трафик, создаваемый ботами. Особенно плохо к накрутке поведенческих факторов относится «Яндекс», который очень быстро наложит фильтр. Google же может долгое время не «замечать» такие накрутки, но все равно выступает против них.

Как поведенческие факторы влияют на ранжирование. Разница учета «Гуглом» и «Яндексом»

Поведенческие факторы (ПФ) — это поведение пользователей. Время, проведенное на сайте, отказы, глубина просмотров — все это относится к внутренним ПФ.

Что учитывается:

- Отказы — это когда пользователь открыл страницу и практически сразу ушёл с неё. Google рассматривает высокие показатели отказов как отрицательный сигнал ранжирования, указывающий на плохой контент. А вот Яндекс больше ориентируется на качество посещений, чем на их количество.

- Количество страниц за посещение — Яндекс отдает предпочтение сайтам, которые демонстрирует высокую вовлеченность (включая более глубокий просмотр с большим количеством страниц за посещение). Google — более целостно рассматривает общие показатели вовлеченности.

- Время на сайте — чем дольше пользователь проводит на сайте тем он лучше. Очень продолжительные сеансы свидетельствуют о высоком качестве контента, высокой релевантности страницы, хорошем пользовательском опыте. Для Яндекса средняя продолжительность сеанса — важная метрика, которая влияет на ранжирование и демонстрирует качество страницы.

- Количество кликов за посещение — Яндекс использует этот показатель как сигнал качества (большее количество кликов показывает полезный для пользователя переход). Google — не делает прямого акцента на кликах.

- Глубина просмотра — простыми словами, количество страниц на сеанс (см. выше).

- Удобство для мобильных устройств — и Google, и Яндекс рассматривают качественную мобильную оптимизацию сайта как позитивный сигнал. Относится к пользовательскому опыту и напрямую влияет на ранжирование в поиске.

- Скорость страницы — более быстрое время загрузки улучшает пользовательский опыт, поэтому воспринимается положительно обеими поисковыми системами.

Если пользователь перешел на ваш сайт и провел на странице несколько минут, затем переходил по внутренним ссылкам и продолжал взаимодействие с контентом, то позиции сайта в SERP могут быть улучшены. И наоборот — если пользователь закрывает сайт сразу после перехода, то это яркий признак отсутствия у него интереса (возможно, контент на странице нерелеватен заголовку в сниппете). Однако данной информации (в патенте) противоречит не кто-нибудь, а сам сотрудник Google:

Кого слушать — решайте сами.

Разница учета ПФ «Гуглом» и «Яндексом» существует — у каждой поисковой системы собственные алгоритмы. Ярче всего это проявляется в учете показателя отказов. Так для «Яндекса» отказом считается любой визит, который длится меньше 15 секунд, а для Google — вообще любой визит, если при этом просматривалась только одна страница. У каждого вебмастера свое мнение, основанное на личном опыте. Я считаю, что для «Яндекса» поведенческие факторы важнее, чем для Google.

Спам в заголовках, переоптимизация контента — не работает

Насыщать текст большим количеством ключевых слов сейчас не имеет никакого смысла. Чрезмерная оптимизация заголовков и самого контента, спам у метатегах, выделение ключей жирным — это поисковый спам. Эти методы больше не работают для эффективного SEO и фактически могут навредить сайту.

Чего избегать:

Поисковые системы очень искусны в обнаружении вброса ключевых слов и неестественной оптимизации заголовков и контента. Это запускает спам-фильтры, которые могут привести к снижению рейтинга или даже удалению из индексов.

Многократное повторение одного и того же ключевого слова в теге заголовка рассматривается как чрезмерная оптимизация для рассылки спама. Основное внимание должно быть уделено надлежащему использованию заголовков для иерархии и структуры на странице.

Как нужно делать:

Сегодня для Google главным фактором являются не отдельные ключи в тексте, а общий тематизм текста — наличие LSI-слов, плюс экспертность и авторитетность автора. В широком смысле, все это относится к улучшению пользовательского опыта.

Теги заголовков должны отражать истинную структуру статьи, а не произвольно оптимизироваться с помощью ключевых слов. Аналогичным образом контент должен восприниматься естественно, а не быть перегруженным ключевыми словами.

Интересно, что обновление алгоритма Google Bert было разработано специально для выявления неестественных сочетаний слов и фраз.

В конце 2023 года поисковые системы придают главное значение качеству: экспертизе контента, авторитету домена, сигналам пользовательского опыта.

Прошли времена когда страницы с малополезным и бессмысленным контентом, состоящим из прямых вхождений ключевых слов, ранжировались высоко. Теперь главное — пользовательский опыт. И ясно, что переоптимизированные тексты его никак не улучшат, ведь написаны они исключительно с одной целью — для манипулирования результатами выдачи. Поисковый спам не работает ни в заголовках, ни в описаниях, ни в тегах страниц. И, естественно, не стоит выделять ключевые слова жирным или курсивом. Это лишь привлечет внимание алгоритмов. Краулеры прекрасно определяют переоптимизированные тексты и дают им «пинок», отправляя в конец результатов поиска или вовсе исключают такие страницы из выдачи.

Как правильно распределять фразы по страницам и какой метод кластеризации лучше

Шаг 1. Маркерный запрос

Сосредоточьтесь на основном ключевом слове, которое отражает главную тему страницы. Не перегружайте каждую страницу множеством конкурирующих ключевых слов — это ошибка. Но связанные вторичные ключевые слова можно использовать во вспомогательном контенте (например, в заголовках или alt-тегах изображений).

Шаг 2. Копируем похожие страницы

Сгруппируйте похожие страницы в кластеры (это все пересекающиеся темы). Отлично подойдут для этого общие названия категорий или, например, тегов.

Шаг 3. Проверка

Убедитесь, что ключевые слова в тегах, заголовках страниц, URL-адресах полностью релевантны контенту. Не злоупотребляйте только ключами и особенно — ключами в прямом вхождении!

Шаг 4. Оптимизация информационных и коммерческих запросов

Страницы товаров — оптимизируем ключами с коммерческим интентом (купить, цена).

Информационные тексты — ориентируем на информационную семантику.

Правило: не смешивайте коммерческую и информационную составляющую вместе.

Шаг 5. Распределяем по странице

Распределяйте ключевые слова по страницам естественным, органичным образом.

Шаг 6. Анализ

После окончания кластеризации и внедрения новой семантики — следите за трафиком. По колебаниям можно увидеть, какие ключевые слова набирают популярность — удваивайте количество кластеров с помощью дополнительных страниц и оптимизации под соответствующие запросы.

Краткий чек-лист:

- информационные ключи нельзя продвигать на коммерческих страницах;

- коммерческие ключи нельзя продвигать на информационных страницах;

- средне- и низкочастотные фразы можно использовать для группировки тегов;

- один ключ продвигается на одной странице. Не следует продвигать один ключ сразу на нескольких страницах, ведь в SERP будет только одна максимально релевантная страница;

- коммерческие слова («купить») допустимо указывать в карточке, но спамить не нужно;

- коммерческие страницы должны продвигаться под понятный, естественный ключ.

Домены-сателлиты — не работает

Это сайты, которые создавались для улучшения ссылочного профиля, искусственно увеличивая количество ссылок, ведущих на главный домен.

Использование доменов-сателлитов как способа искусственного увеличения количества ссылок больше не работает, и, как правило, не рекомендуется опытными оптимизаторами. Ведь теперь поисковые системы способны обнаруживать такие домены с высокой эффективностью. И ссылки с них не дадут никакой буст для продвигаемого сайта.

Полезно знать: сателлиты создают неестественную сеть связей между доменами, находящимися под контролем одного человека. Любые домены, добавленные исключительно ради получения ссылок и не имеющие ценности для пользователя, — не учитываются Гуглом и Яндексом.

Лучше сосредоточиться на создании естественного ссылочного профиля — создавая и публикуя качественный контент под ключи с поисковым спросом.

Google и «Яндекс» анализируют качество донора, поэтому нет смысла создавать такие сайты, регистрируя однодневные домены. Даже если сателлит сделан хорошо, он все равно больше не справится с отведенной ему ролью и никак не поможет продвижению главного домена.

Низкочастотная семантика — работает

Такой вид продвижения сводится к созданию релевантных страниц исключительно по НЧ-запросам, включая long-tail. Обычно берут количеством запросов и страниц. В качестве бонуса сайт получает первый трафик, причем часто весьма качественный. Естественно, под НЧ-фразы семантическое ядро подбирается отдельно.

Ориентируйтесь на длиннохвостые нишевые ключевые слова — с ясным интентом и небольшим объемом поискового спроса. Найти такие поможет Вордстат или Планировщик ключевых слов из Google Ads.

После того как низкочастотная семантика собрана — начинайте создавать контент.

Страница должна представлять реальную ценность для пользователя, а не только для поисковых систем.

На что обращать внимание:

- Внимательно следите за объемом поиска для каждой ключевой фразы, причем актуализируйте эти данные хотя бы раз в месяц (поисковый спрос часто меняется причем волнообразно). Не нужно искать тысяч и десятки тысяч ключей, лучше — сосредоточьтесь на 100-200 фразах. Для старта этого вполне достаточно.

- Не стесняйтесь удалять страницы, которые со временем так и не получили трафик.

- Важна интеграция семантики с общей тематикой сайта.

- Используйте веб-аналитику для выявления закономерностей в поведении пользователей по используемым ключевым словам. Яндекс.Метрики будет более чем достаточно (см. отчеты по поисковым фразам).

- Двигаться по низкочастотным запросам легче всего. Но при одном условии: контент на таких страницах должен быть качественным, с релевантным заголовком. Такие страницы сами очень быстро залетают в топ.

Александр Белов, ведущий аналитик TexTerra: «Практически любой сайт-новичок достаточно легко вывести в топ по низкочастотным запросам со стороны Яндекса (и чуть менее просто — со стороны Googl). Для этого достаточно иметь хорошую внутреннюю оптимизацию сайта и прорабатывать НЧ запросы, плавно переходя к СЧ и ВЧ».

Собственная страница под каждую поисковую фразу — не работает

Этот способ продвижения можно отнести к поисковому спаму. Точное вхождения ключевой фразы в заголовок страницы, как уже отмечали выше, больше не работает. Метод утратил свою актуальность после введения «Колибри» и других обновлений алгоритмов. Сейчас главное — полезный контент.

Создание отдельных страниц, оптимизированных исключительно для отдельных поисковых фраз, больше не является эффективной стратегией SEO и даже может рассматриваться как поисковый спам. А это уже пессимизация (фильтры).

Google очень легко распознает такие страницы, ведь начинающие оптимизаторы часто не задумываются — они просто добавляют главный ключ в прямом вхождении в title страницы. Но title должен создаваться не по ключевой фразе, а по контенту (который будет на такой странице) + по интенту поисковой фразы.

Основное внимание разумнее уделить созданию полезных, высококачественных групп контента по темам (а не отдельных страниц, заполненных ключевыми словами).

Три рекомендации:

- Избегайте дублей в title страниц. Title должен быть уникальным у каждой страницы.

- Удобство пользователя и трастовость домена важнее, чем искусственная оптиимизация страницы под ключи.

- Делаем целевые страницы под определенную тему — вдумчиво, внимательно, вручную. Но добавление страниц под каждый вариант ключевого слова — это плохо.

Пробуйте сочетать прямые вхождения ключей с разбавлением их при помощи LSI, слов из поисковых подсказок, околотематических слов. Лучше если у вас будет одна качественная релевантная страница под один ключ, чем десять страниц с бесполезным содержанием, на которое тратят максимум 15 секунд, чтобы только понять, что информация здесь бесполезна.

Аффилиатные версии основного домена — не работает

Этот способ продвижения, также как и сателлиты, потерял актуальность. Аффилиат представляет из себя дубль главного домена. «Яндекс» и Google определяют аффилиаты, главным образом, по странице контактов и адресу организации. Но это не значит, что краулеры не учитывают и другие страницы — они анализируют буквально все. И не только страницы, но и тематику сайта, систему управления контентом и даже ваш хостинг.

Использование доменов-аффилиатов — плохая практика. Как и любые другие дубли они не поощряются ПС.

Google сканирует любой домен невероятно тщательно, ПС учитывается сотни сигналов. Создали аффилиат для прокачки SEO, улучшения ссылочного профиля или получения трафика? Поисковые системы сразу увидят такие манипуляции.

В чем опасность аффилиатов

Наличие нескольких похожих доменов, в значительной степени с дублирующимся контентом друг у друга, не имеет ценности для пользователя, соответственно — они не ранжируются высоко или вообще не попадают в результаты поиска.

Аффилиат — неестественная, манипулятивная техника SEO. Ресурсы лучше потратить на разработку одного сильного домена, чем на сомнительное агентство, которые предлагает продвижение аффилиатами.

Подытожим минусы у доменов-аффилиатов:

- Не передают вес размещенных на них ссылок.

- Возможна пессимизация аффилиата вплоть до полного исключения из выдачи.

- Не несут никакой ценности для пользователя.

- Не влияют на авторитетность продвигаемого домена и его ранжирование в долгосрочной перспективе.

Основное внимание должно быть уделено высококачественному уникальному контенту и естественным входящим ссылкам на один основной домен.

Главная цель аффилиатов — занять как можно больше «места» на странице SERP. Но вас обязательно выведут на чистую воду. «Яндекс» и Google не наказывают основной домен при обнаружении аффилиатов, но такие версии сайта просто исчезнут из выдачи.

Частые вопросы про аффилиатные домены:

- Нужно ли работать с аффилиатными доменами в 2023 году

Продвижение доменами-аффилиатами устарело уже лет 10 назад. Сегодня аффилиаты — это «черное SEO» и рассматривать этот способ продвижения всерьез точно не стоит. Искусственное манипулирование результатами выдачи карается как «Гуглом», так и «Яндексом».

- Что за аффилиат-фильтр и признают ли его поисковики

«Яндекс» строго следит за аффилиатами, и у него есть отдельный фильтр против них. Если фильтр накладывается, то все копии сайта просто уходят на десятки позиций вниз (начиная с топ-20 и дальше).

Google ведет себя мягче. Он убирает аффилиаты в «сопли» (Supplementary results), где они не получают никакого трафика. В справке Google слово аффилиат не встречается. Вместо него используется термин некачественные партнерские сайты.

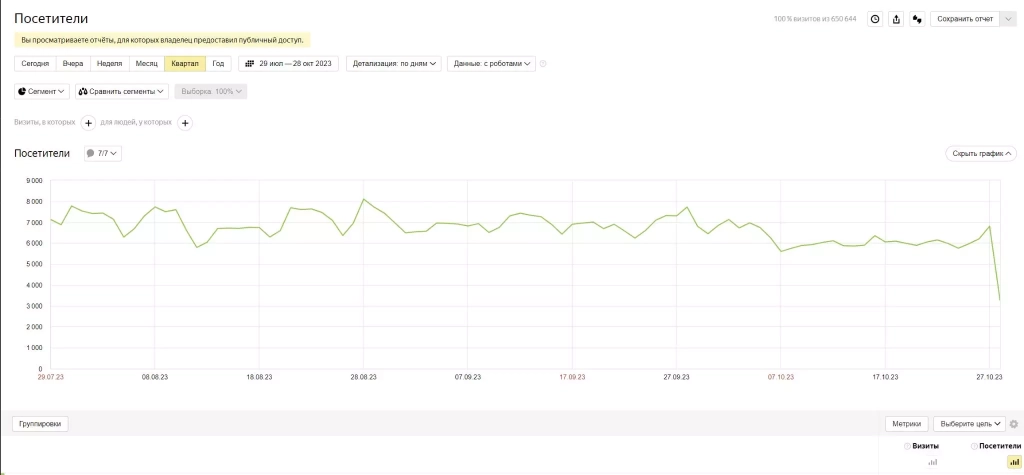

Суммарный трафик — работает с оговоркой

Суммарный объём трафика из разных каналов никак не влияет на ранжирование сайта, его позиции или видимость на странице результатов поисках — ведь алгоритмы Яндекса и Google ориентированы на предоставление наиболее полезных, релевантных результатов поиска, а не на выдаче списка популярных сайтов.

Многие начинающие оптимизаторы и вебмастеры искренне считают, что объем трафика может определять качество сайта. На самом деле это заблуждение, о чём неоднократно говорили и сотрудники Google. Ни качество страницы, ни релевантность интента, ни даже поведенческие — объём трафика никак не коррелирует с этими составляющими напрямую.

Показатели трафика, скорее всего, рассматриваются как дополнительные сигналы, а не основные. В любом случае никто не знает, как работают алгоритмы ранжирования на самом деле, можно лишь догадываться об этом по косвенным знакам. Понятно только то, что одной посещаемости для выстраивания сайтов на странице результатов поиска мало.

Однако известно, что Google учитывает и конверсионный показатель коммерческих сайтов. Поэтому, если товары покупают регулярно, то этот фактор также будет положительным сигналом для алгоритмов поисковой системы. Но это не означает, что нужно отравлять на сайт ботов — такой подход не сработает.

Лонгриды ранжируются лучше — работает частично

Хотя, скорее да, чем нет. Однако и короткие заметки прекрасно «сидят» в топе по многим, даже высокочастотным, запросам. Причем касается это как коммерческих, так и информационных запросов.

Длина текста — всего лишь один из сигналов среди многих. И он далеко не самый важный. И если вы внимательно читаете SEO-гайды Текстерры, вы точно об этом знаете. Актуальность контента, пользовательский опыт, качество сайта — все это гораздо важнее длины текста. Но определенные хитрости в этой теме, все же, есть.

- Фразы из 1-2 слов лучше всего подходят для коммерческих и транзакционных ключей.

- Интент есть и у ключевых фраз из 2 слов, просто не всегда он так очевиден как у НЧ-ключей.

- Длинная ключевая фраза может ранжироваться при поиске по теме, короткая — при точном совпадении ключевых слов.

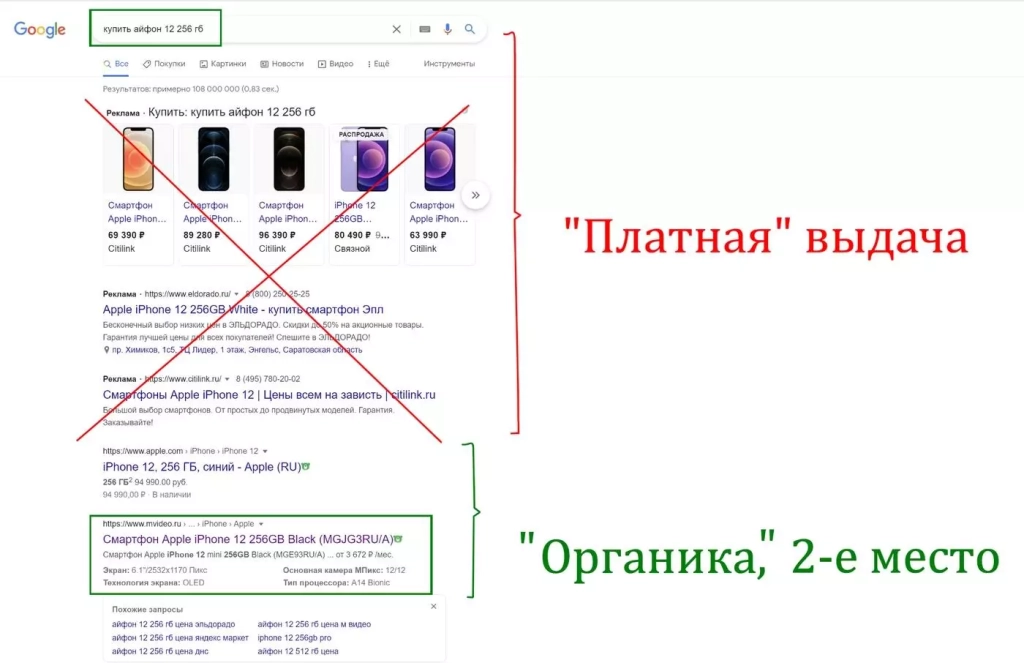

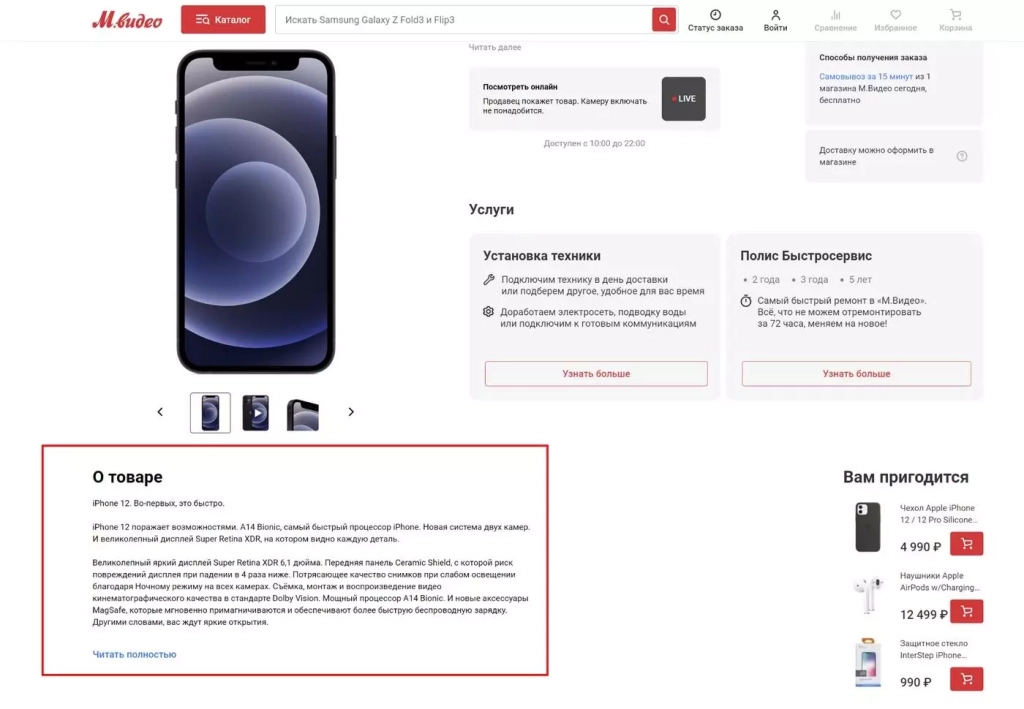

Длина описания карточки товара сайта, занимающего второе место:

Так что писать «простыни» для карточки товара точно не стоит. Раньше считалось, что длинный текст дает информационным и коммерческим страницам существенные бонусы при ранжировании.

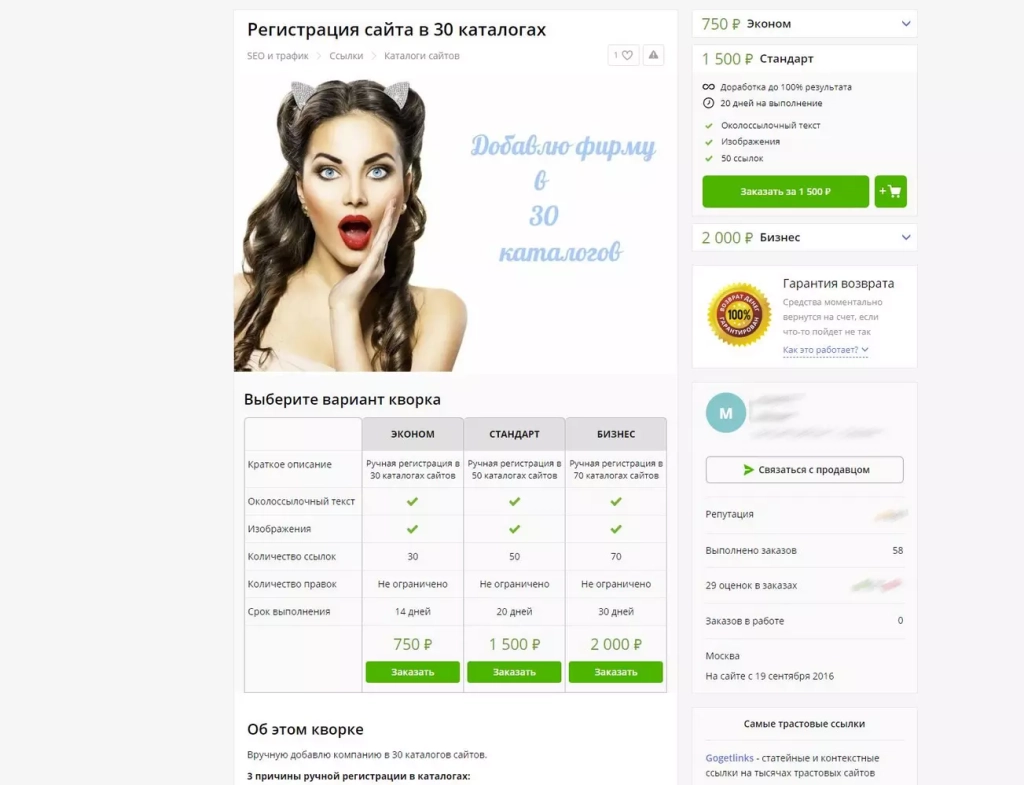

Каталоги — не работают

До сих пор на биржах фриланса многочисленные исполнители предлагают добавить ваш сайт в десятки «белых» каталогов:

Кажется, что этот инструмент вообще никогда не работал. Судите сами: у каталогов практически нет трафика, а значит и переходов по ссылкам на продвигаемый сайт вы также не получите.

Турбо- и AMP-страницы — работают частично

Александр Белов, ведущий аналитик TexTerra: «Наличие АMP- страниц значительно повышает вероятность попадания сайта в Discovery , что может заметно увеличить трафик сайта. Турбо страницы размещаются в спецблоках топ выдачи (при общем хорошем качестве сайта) , что также может поднять трафик. Однако есть и минусы. При низком качестве АMP-страниц , если за ними не следить, они могут вылетать из индекса, что сильно скажется на трафике. Как правило, мы ставим на проект турбо страницы, а АMP — только на проектах с большими объемами контента и наличием технической поддержки».

Использование AMP и других методов ускорения загрузки может помочь с сигналом скорости страницы, но само по себе наличие AMP-версий или турбо-версий напрямую не влияет на ранжирование. Некоторые дополнительные моменты:

- Скорость страницы — лишь один из многих факторов, определяющих рейтинг сайта. Но релевантность страницы в поиске этот сигнал не затрагивает.

- Более быстрые сайты обеспечивают лучший пользовательский опыт, что со временем становится ценным и для SEO.

- А вот AMP-версии страниц отображаются отдельно в мобильном поиске — вот почему они не обязательно передают вес основной версии сайта.

Как улучшить SEO при помощи AMP- и турбо-страниц:

- Ресурсы лучше тратить не на попытки оптимизации турбо-версий под поиск, а на создание оптимизированного для турбо-версий контента.

- У каждой важной страницы сайта, которая приносит какой-либо объём трафика должна быть AMP-версия (и турбо, если трафик из Яндекса важен для сайта).

- Не забудьте по максимуму оптимизировать скорость загрузки обычной версии страницы. Для этого сделайте компрессию всех изображений на сайте или внедрите динамическое сжатие. В специфических сценариях можно внедрить CDN-инфраструктуру

- Контент и удобство использования остаются главными факторами. В первую очередь — улучшайте их.

Как подключить AMP-страницы

Во-первых, убедитесь что текущие версии веб-страниц подходят под эти параметры.

Во-вторых, принципы добавления структурированных данных ничем не отличаются от принципов добавления обычных веб-страниц.

Создать свою первую AMP-страницу вы можете следующим образом (выдержка из справки amp.dev):

- Тип документа <!doctype html>.

- Верхний тег <html ⚡> или <html amp>.

- Теги <head> и <body> не являются обязательными в HTML-разметке.

- Указание главной страницы происходит при помощи тега <link rel="canonical" href="$PRIMER_URL">. PRIMER_URL нужно заменить ссылкой на исходный документ или на HTML-версию AMP-страницы.

- Первый дочерний элемент заголовка <meta charset="utf-8">.

- В теге заголовка должен быть прописан тег viewport со значением initial-scale=1. Тег выглядит так: <meta name="viewport" content="width=device-width">.

- Последний элемент заголовка должен содержать следующий тег: <script async src="https://cdn.ampproject.org/v0.js"></script>.

- Тег <head> должен включать в себя такой фрагмент:

<style amp-boilerplate>body{-webkit-animation:-amp-start 8s steps(1,end) 0s 1 normal both;-moz-animation:-amp-start 8s steps(1,end) 0s 1 normal both;-ms-animation:-amp-start 8s steps(1,end) 0s 1 normal both;animation:-amp-start 8s steps(1,end) 0s 1 normal both}@-webkit-keyframes -amp-start{from{visibility:hidden}to{visibility:visible}}@-moz-keyframes -amp-start{from{visibility:hidden}to{visibility:visible}}@-ms-keyframes -amp-start{from{visibility:hidden}to{visibility:visible}}@-o-keyframes -amp-start{from{visibility:hidden}to{visibility:visible}}@keyframes -amp-start{from{visibility:hidden}to{visibility:visible}}</style><noscript><style amp-boilerplate>body{-webkit-animation:none;-moz-animation:none;-ms-animation:none;animation:none}</style></noscript>

После того, как код сформирован, подтвердите валидность страницы.

Если вы не хотите или не умеете работать в коде, то подключать AMP-страницы удобнее плагином. Например, отличным вариантом будет AMP для WP — Ускоренные мобильные страницы. Как подключить AMP-страницы, вы можете узнать из нашего руководства.

Как подключить турбо-страницы

Теперь о «Яндексе». Нельзя сказать, что турбо-страницы улучшают ранжирование сайта, но свидетельства тому в рунете есть. Нам не удалось найти более-менее серьезной выборки, чтобы утверждать однозначно, будто турбо-страницы улучшают ранжирование. Есть вебмастера, у которых подключение турбо-страниц, по их словам, стало причиной падения трафика с мобильных устройств. У других он, наоборот, увеличился, а количество отказов уменьшилось (эти данные взяты с портала searchengines.ru).

Подключаются турбо-страницы за пять шагов:

- Формирование RSS-канала.

- Первоначальная настройка в «Яндекс.Вебмастере».

- Подключение рекламной системы.

- Отправка RSS-ленты.

- Обработка RSS-канала «Яндексом».

Если ваш сайт работает на WordPress, то подключить турбо-страницы будет проще при помощи плагина «Яндекс.Турбо». Кстати, в справке «Яндекса» есть подробное описание того, как подключить турбо-страницы для контентных и коммерческих страниц.

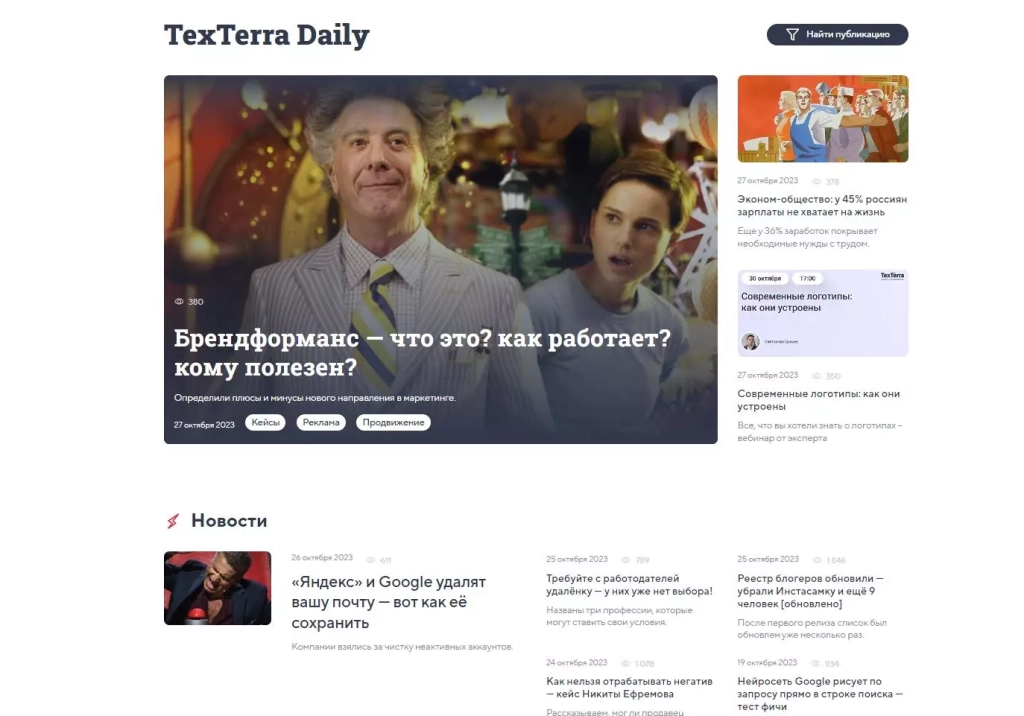

Контент-маркетинг — работает

Это долго, дорого, сложно. Но это главный инструмент поисковой оптимизации в 2023 году, и он приносит результат — именно с точки зрения продвижения в «органике» Google и «Яндексе».

Страница должна быть релевантной и полностью соответствовать интентному намерению посетителя: он должен найти то, что искал.

Обязательно дополняйте текстовой контент медиа-материалами: качественными изображениями в высоком разрешении, инфографикой, анимациями и видео.

Плюсы, которые вы получите от качественного контент маркетинга:

- Лучшая видимости на странице результатов поиска

Высококачественный, релевантный контент помогает привлекать органический поисковый трафик. Ведь наличие такого трафика является сигналом для Google и Яндекс о том, что сайт популярен.

- Вовлечение ЦА

Только регулярно публикуемый контент поможет улучшить поведенческие факторы, глубину просмотра количество страниц на сеанс и в конечном итоге — привлечь внимание пользователя к целевым страницам. Но сделать всё выше перечисленное, может только по-настоящему экспертный, популярный и качественный контент. Хорошо написанные статьи, гайды, тщательно проработанная инфографика, нескучные видео — всё это поможет. Ваша задача сделать так, чтобы целевая аудитория начала воспринимать контент на сайте как экспертный.

- Посевы в соцсетях и мессенджерах

Распространение контента в социальных сетях увеличивает его охват, может решать другие задачи (например, прокачка узнаваемости бренда).

- Цена

Все каналы продвижения сайта стоят денег: контекст и таргет, SEO, реклама в мессенджера. Контент-маркетинг в этом плане, не исключение — он может стоить очень дорого. Но стоить денег он будет лишь в начале, затем он начнет работать на автопилоте, а вы будете получать заявки из поиска ежедневно. Бесплатный трафик, куча лидов и конверсий — это ли не мечта? Мы можем доказать вам это цифрами своих результатов.

Косвенное улучшение SEO сайта — еще один плюс качественного контент-маркетинга. Ведь хорошо распространяемый контент поможет сайту обрасти с ссылками, увеличить объем трафика, поднять поведенческие факторы. В итоге: видимость сайта на странице результатов поиска вырастет.

Семантическая разметка schema.org для Google — работает с оговорками

Наличие семантической разметки на странице не является прямым фактором ранжирования. Другое дело, что расширенные результаты поиска Google выглядят привлекательнее и, как следствие, такие сниппеты имеют высокую кликабельность. Но никаких прямых бонусов при ранжировании ваш сайт не получит.

Словарь семантической разметки Schema.org помогает Гуглу и Яндексу лучше понимать содержание контента, который публикуется на странице. Кроме того, на основе этого словаря строятся расширенные результаты поиска.

Хорошо реализованная семантическая разметка — это улучшение пользовательского опыта. Ведь наличие Schema.org позволяет делать снипеты более привлекательными визуально (внутри появляются структурированные данные).

Особенно сильно на кликабельность сниппета наличие семантической разметки может повлиять, если страница содержит информацию о конкретном товаре (с ценой). Обзоры, рецепты, отзывы, адреса — лишь некоторые примеры контента, который особенно выиграет, если на странице присутствует семантическая разметка под соответствующие типы данных.

Что запомнить:

- Наличие Schema.org на страницах само по себе напрямую не повышает рейтинг домена в результатах поиска. Основное внимание должно по-прежнему уделяться созданию полезного, ориентированного на ЦА контента.

- Наличие разметки schema.org на странице никак не помогает ранжированию сайта в Google.

- О том, как сделать разметку на своем сайте и попасть в расширенные результаты поиска Google, мы подробно писали в этой статье.

- Семантическая разметка обязательна для коммерческих сайтов. Размечая публикуемые на странице данные, вы можете получить определенные бонусы по сравнению с теми сайтами, которые внедрить семантическую разметку еще не успели.

Особенно актуальной разметка стала после того, как Google объявил о появлении E-A-T (expertise, authoritativeness, trustworthiness или компетентность, авторитетность, надежность). Теперь он превратился в E-E-A-T (добавился опыт). Этот алгоритм введен для того, чтобы в топ попадали только авторитетные страницы, содержащие проверенные данные.

Приведем пример: по запросу «оценка рисков долевого участия», по задумке Google, в топе поисковых результатов должна находиться статья, написанная юристом. Семантическая разметка, к слову, задействуется и для указания автора статьи.

Минимальный набор типов данных, которые нужно разметить на сайтах разных типов, следующий:

- Website (для всех сайтов);

- Article (особенно актуально для информационных сайтов с авторитетными публикациями);

- Review (для магазинов);

- Product (актуально для магазинов);

- FAQ (для коммерческих сайтов — FAQ-блоки дают хороший трафик);

- Organization (для сайтов компаний).

Голосовой поиск — работает

Голосовые запросы становятся все популярнее и их доля среди других типов запросов, совершаемых пользователями Google и «Яндекса», растет.

Используем естественный разговорный язык, без технического жаргона. Ориентируемся на дружелюбный, непринужденный стиль, как будто отвечаете на реальные вопросы, но устно.

Как структурировать текст:

- Важные ключевые слова — добавляем в начало текста (но не стоит начинать предложение с ключа). Обязательно заполняем alt-теги у всех изображений.

- Оптимизируем title страниц так, чтобы они отражали основные темы контента (обязательно с учётом разговорной формы, которую используют пользователи голосового поиска Google и Яндекс).

- Четко структурируем контент с помощью соответствующих тегов, заголовки и подзаголовки разного уровня, абзацы, списки — всё это пригодится для формирования расширенных сниппетов.

- Метатег description должен быть адаптирован для голосовых запросов. Заполняем его кратко, но информативно.

- Контакты компании: адрес, телефон, электронная почта, контакты в соцсетях и мессенджерах —- все это должно быть на одной странице

Следите за данными по ключевым словам из Подбора слов и других сервисов. Нужно проверять все важные фразы на предмет растущих запросов из голосового поиска (и заблаговременно оптимизировать релевантные страницы).

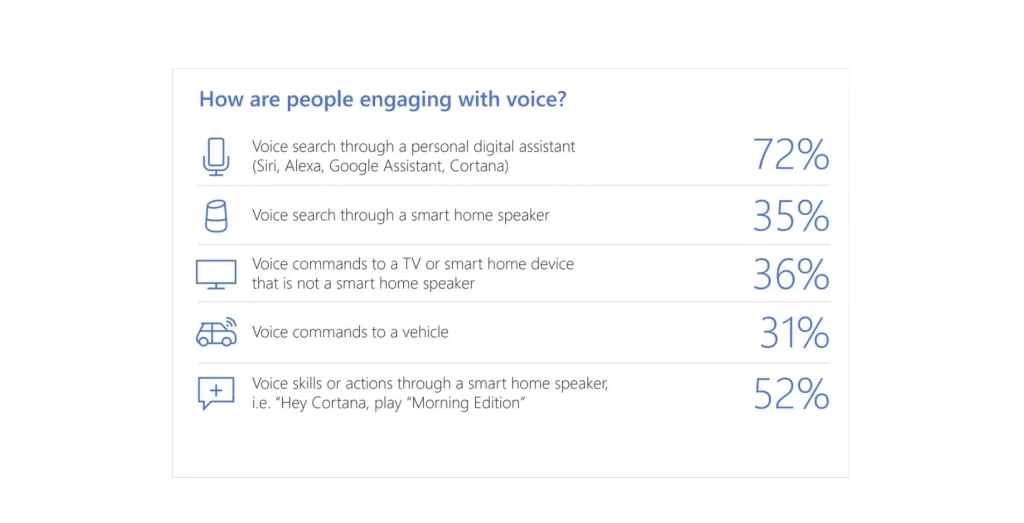

Microsoft провела интересное исследование, которое показало — именно голосовой поиск через ассистентов (Siri, Alexa, Google-ассистент, Cortana) является самым популярным способом использования голоса для взаимодействия с устройствами:

Голосовой поиск открывает практически безграничные возможности для оптимизации контента и юзабилити сайта. Возможно, уже через несколько лет управлять мобильными устройствами можно будет только голосом, а традиционные устройство ввода, такие как, например, экранная клавиатура, вовсе исчезнут.

Уже сейчас, на этапе сбора семантики, стоит предусматривать голосовой тип запросов. Естественно, они существенно отличаются от стандартных типов, которые делаются при помощи клавиатуры.

Голосовые запросы могут включать очень большое количество дополнительных слов, связок и иметь нестандартные «хвосты». Все это нужно учитывать при составлении голосового семантического ядра.

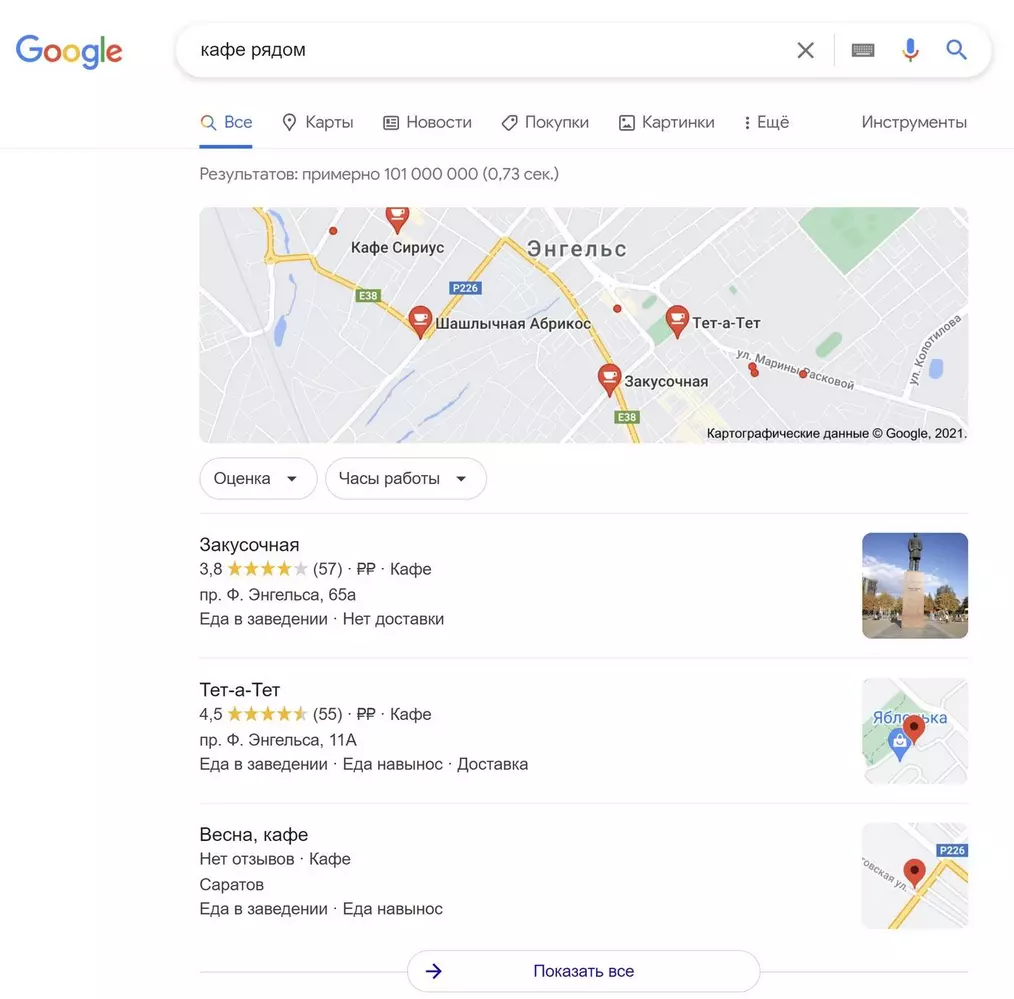

«Места рядом со мной» — работает

Локальный поиск — это алгоритм, который показывает результаты с учетом местоположения пользователя. Естественно, что присутствие в локальном поиске особенно важно для компаний и организаций.

Как попасть в расширенную выдачу Места рядом:

- Добавляем точный адрес с улицей и номером дома, номером телефона и часами работы организации.

- Добавляем бизнес-профиль компании на Яндекс.Карты. Если вы не в РФ — на Google Maps, Apple Maps, Bing Places.

- Создаем локальные страницы, оптимизированные для конкретного ГЕО (например, для Москвы). Пример контента с геотаргетингом — зоны обслуживания, прайс-листы, контакты.

- Отслеживаем запросы, зависящие от местоположения, и оптимизируем такие страницы для решения проблемы пользователя (обязательно учитываем интент).

- Обеспечиваем максимально быструю загрузку сайта, поскольку мобильным пользователям требуется быстрый доступ.

Чтобы повысить видимость по геозапросам, попытайтесь получить ссылки с местных сайтов — например, региональных СМИ.

Логика простая: чем ближе компания находится к пользователю, тем выше шансы, что окажется в поисковой выдаче.

К локальным можно отнести три типа поисковых «блоков» Google:

- Local Organic — SERP с учетом текущего местонахождения пользователя;

- Local Pack — карта с указанием на ней компаний, с учетом текущего местонахождения пользователя;

- Local Knowledge Graph — сведения о компании / организации / другом объекте, с учетом текущего местонахождения пользователя.

Чтобы оказаться в локальной выдаче, обязательно зарегистрируйте свою компанию в «Google Мой Бизнес».

Для продвижения в локальной выдаче Google важен не только Title страницы, но и наличие на ней номера телефона и точного адреса компании. Если ваш сайт отсутствует в локальной выдаче, убедитесь, что его мобильная версия демонстрирует приемлемые показатели Core Web Vitals.

Обязательно обратите внимание на ленту рекомендаций «Что рядом». Этот инструмент также можно использовать для загрузки изображений и добавления отзывов о компании. Но и здесь важно не переусердствовать.

Мобильная версия сайта — работает

Поисковая оптимизация страниц под мобильные устройства — это не только сокращение скорости загрузки сайта, которое декларируется факторами Core Web Vitals.

Экран смартфона очень маленький. Поэтому структура полной версии сайта (наличие всех элементов на главной странице / главном экране) должна быть пересмотрена. В мобильной версии на экране находятся только необходимые кнопки, которые нужны пользователю.

Особенное внимание обратите на читаемость текста, расположение элементов по отношению к друг другу и сдвиги макета при загрузке.

Что касается функционального элемента мобильной версии, то он практически всегда урезан по сравнению со стандартной версией сайта. И это нормально. Главное — оставить только необходимые мобильному посетителю возможности, которые действительно ему пригодятся.

Вернемся к скорости загрузки мобильной версии. Google уже давно пытается заставить вебмастеров уменьшить скорость загрузки своих сайтов. Для этого и был введена оценка Core Web Vitals. Изучите из чего именно формируются эти показатели и попытайтесь их улучшить.

Наличие быстрой, отзывчивой и оптимизированной для мобильных пользователей версии сайта — фактор ранжирования.

Уже более десятка лет Google учитывает удобство использования сайта на мобильных устройствах. Яндекс — делает также.

Теперь большинство поисковых запросов выполняется именно с мобильных устройств. И страницы, которые загружаются мгновенно, легко читаются, имеют простую навигацию — обеспечивают наилучший пользовательский опыт.

Разработчикам рекомендуется внедрять адаптивный дизайн, обеспечивающий единую версию сайта для всех устройств. Мобильная версия сайта, по сути, становится канонической — она индексируется и ранжируется.

Page Experience — работает

Особенности этого алгоритма должны учитываться при поисковой оптимизации страниц в 2023 году. Page Experience состоит из уже знакомого нам Core Web Vitals, а также включает в себя три фактора:

- наличие раздражающей рекламы;

- качество мобильной версии сайта;

- наличие HTTPS-протокола.

Все перечисленное влияет на пользовательский опыт самым прямым образом.

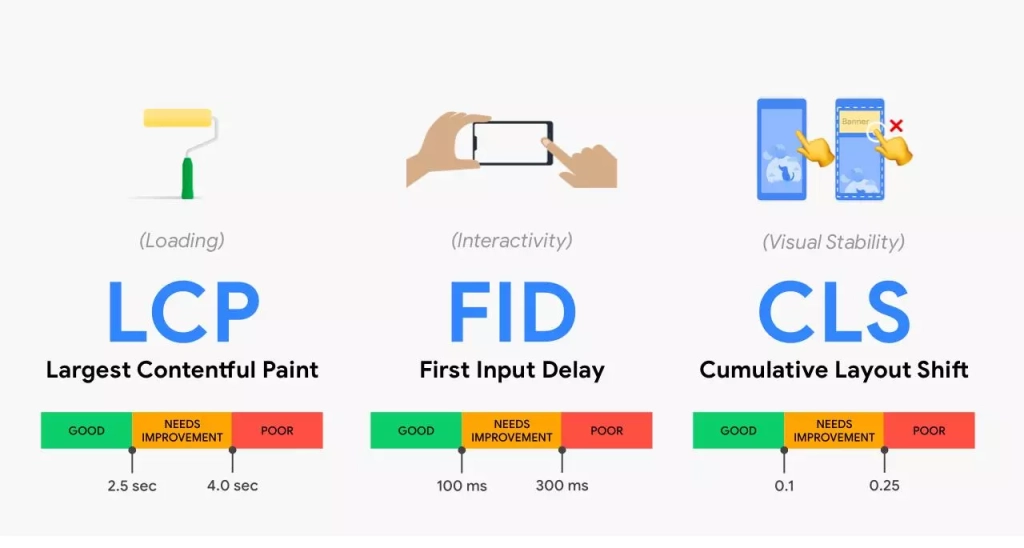

В марте 2022 года Google объявил: сигнал Page Experience является третьим по значимости после контента и ссылок. Показатели LCP, FID, CLS, напрямую влияют на оценку Page Experience. По сути — это коэффициент восприятия страницы пользователем ,и в него входит множество других сигналов (наличие HTTPS-протокола, удобство навигации, читабельность контента с мобильного устройства).

Чтобы соответствовать рекомендациям Page Experience, страница должна соответствовать минимальным пороговым значениям Core Web Vitals.

Для хорошего SEO необходимы регулярные проверки и оптимизация страницы. Для измерения показателей CWV и Page Experience используйте бесплатный сервис Google PageSpeed Insights и Lighthouse. Там же вы получите ценные рекомендации, индивидуальные для каждого сайта.

Бонус: Почему не получается обогнать конкурента

Вы хотите обогнать сайт, который находится в топе несколько лет? У него десятки тысяч страниц, а у домена — высочайшие метрики авторитета? Естественно, ваш молодой сайт просто не сможет подвинуть такого конкурента. Сравните ИКС своего сайта и ИКС конкурента, а также качество ссылочного профиля и возраст доменов. Посмотрите, сколько страниц у конкурента и у вашего сайта. Скорее всего, вы обнаружите довольно ощутимую разницу.

Авторитет домена

Это один из сигналов авторитета, ведь сайты, которые существуют уже много лет, накопили гораздо более высокие показатели траста. Поисковые системы считают их более заслуживающими доверия по умолчанию, чем домены-новореги.

Ссылочный профиль

У домена с историей почти всегда крупный ссылочный профиль. Тысячи релевантных, естественных ссылок показывают — домену можно доверять. Ссылочная масса продолжает оставаться основой первоначального алгоритма ранжирования Google, и хотя за десятки лет он значительно изменился, ссылки продолжают играть важную роль в работе Google сегодня.

Страницы в индексе

Количество проиндексированных страниц. Это ещё одна причина, почему не удаётся обогнать конкурента в поиске. Простой пример: сайт с тридцатью тысячами проиндексированных страниц имеет гораздо больше анкров, чем сайт из пятисот проиндексированных страниц.

Глубина контента так же важна. Для крупных сайтов, пишет не один копирайтер, а целая редакция авторов. Вот почему контент по актуальным темам на таких сайтах появляется очень оперативно. Кроме того, крупные конкуренты могут исчерпывающе охватывать темы в масштабе.

Рекомендации: ищите конкурентов по органической выдаче и внимательно изучайте такие домены. Анализируйте упущенную семантику, обратные ссылки, а также их анкоры. Для этих целей удобнее всего использовать инструменты Semrush.

Какие предложения конкурент делает лучше и в чем его преимущество? Оцените качество контента на информационных / коммерческих страницах и то, насколько экспертен текст на них. В идеале проведите конкурентный анализ самых серьезных доменов.

Как часто следует обновлять семантику

Обновление семантики актуально практически для любых сайтов, включая информационные и коммерческие. Для последних даже больше, ведь там обновляется товарный ассортимент.

Для информационных сайтов: старайтесь обновлять основную семантику (ключевые слова и темы) по крайней мере ежеквартально, чтобы объем трафика не снижался. По очень динамичным темам обновлять ключевые слова можно раз в месяц и даже чаще.

Для коммерческих сайтов: обновляйте семантику всякий раз, когда добавляются новые артикулы. Учитывайте время года: для сезонных товаров семантику нужно менять чаще.

На что обращать внимание:

- Следите за Вордстатом: если интересы ЦА меняются, обновляйте семантику как можно быстрее. В идеале находить новые ключевые слова нужно каждый раз, когда на сайт добавляется новый контент.

- Крупный редизайн сайта или миграция с одной CMS на другую может потребовать частичного изменения семантического ядра.

- Нет необходимости менять семантику просто так, если она остается актуальной — делать изменения нужно только при необходимости.

Рекомендуется обновлять семантическое ядро в следующих сценариях:

- выделен новый кластер для продвижения;

- выявлен новый товарный спрос (для коммерческий сайтов);

- выявлен новый информационный спрос (для контентных сайтов);

- изменение ключевых запросов, а, соответственно, и страниц, которые вы продвигаете;

- в названии страницы указан год.

Резюме

Мы убедились, что SEO в 2023 году «живее всех живых». Да, какие-то инструменты ушли безвозвратно, но на смену им пришли новые, обладающие не меньшим потенциалом. К новым инструментам можно отнести: локальную выдачу, голосовой поиск, Core Web Vitals, обновления алгоритмов ранжирования (такие как E-A-T и Page Experience). Все это нужно учитывать при поисковой оптимизации страниц в 2023 году.

Поиск живет и развивается, но в погоне за SEO-приемами не забывайте о главных принципах ранжирования, которые нужно учитывать:

- Тип запроса (коммерческий или информационный).

- Тип URL.

- Местоположение пользователя.

- Интент запроса.

Учитывая все это, вы сможете создавать и продвигать страницы, которые действительно полезны пользователю.

Читайте также:

Новые принципы Google: что такое Core Web Vitals и как улучшить показатели на сайте. Краткий гайд

Подробный гайд по «Яндекс.Бизнесу»: недостатки и главные плюсы