Причина 1. Запрещающие директивы в robots.txt

Для релиза на тестовых поддоменах разработчики часто закрывают сырой продукт в robots.txt, а при выкатке в «бой» забывают его открыть.

Рекомендательные директивы в стандарте исключений для роботов могут быть причиной снижения органического трафика сайта. Возможно, недавно вы изменяли рекомендации по индексированию страниц? Например, скрыли от краулеров сайт целиком или какой-то его раздел. Этого может быть достаточно, чтобы трафик из поиска снизился.

Если сайт всегда плохо индексируется, проверьте домен через оператор site (site:_ваш_домен).

Пример robots.txt, содержащий запрещающие директивы для Google-bot

Вот что означают директивы в robots.txt:

- агент (краулер или поисковый робот) Googlebot не может обходить никакие URL, начинающиеся с http://example.com/nogooglebot/;

- краулеры других поисковых систем могут свободно обходить любые страницы сайта;

- файл с картой сайта доступен по пути: http://www.example.com/sitemap.xml.

Причина 2. Изменения на сайте

Любые изменения в работе сайта способны привести к падению поискового трафика. При следующих изменениях большая часть страниц полностью выпадает из индекса:

- страницы удалены, например, по причине релиза нового сайта, корректировки разделов, переноса контента. Решение – восстановить удаленные страницы;

- страницы закрыты от индексирования. Решение – проверить файл robots.txt и найти запрещающие директивы (disallow), удалить их;

- доступно несколько зеркал сайта. Решение – поменять главное зеркало. Для этого нужно настроить 301-е перенаправление (постраничное) со второстепенных на главное зеркало. Также нужно отметить главное зеркало в «Яндекс.Вебмастере» (откройте отчет «Переезд сайта» и выберите корректный домен). Проверить все зеркала сайта вы можете в «Яндекс.Вебмастере» – там зеркала главного домена группируются в кластеры, которые отображаются в отчете «Мои сайты».

Навредить поисковому трафику сайта способны конкретные обстоятельства, вытекающие из разобранных причин:

- изменение вида URL (включая переход на HTTPS-протокол);

- изменение шаблона сайта;

- изменение дизайна всего сайта или отдельных страниц;

- переезд на другую систему управления контентом (CMS);

- изменение структуры сайта;

- переименование меню, разделов и страниц.

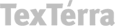

Google Search Console сортирует все страницы по причинам исключения (переадресация, блокировка в robots.txt, 404-й ответ)

Причина 3. Фильтры

Фильтры – ручные и автоматические меры борьбы с некачественными сайтами, которые пытаются манипулировать результатами поисковой выдачи.

Если ваш сайт получал хороший органический трафик, но в один день он снизился практически до нуля, практически наверняка сайт пессимизирован.

Вот за что поисковые системы могли вас наказать:

- излишняя поисковая оптимизация страниц (например, слишком частое повторение ключевых фраз);

- малополезный контент;

- некачественный контент (например, рерайт или неуникальные статьи);

- имитация действий пользователей (накрутка трафика и поведенческих факторов);

- назойливая, нерелевантная, неприемлемая реклама;

- скачок в ссылочном профиле сайта;

- размещение платных ссылок;

- ссылки на сайты запрещенных тематик;

- большое количество сквозных URL;

- скрытый текст на странице.

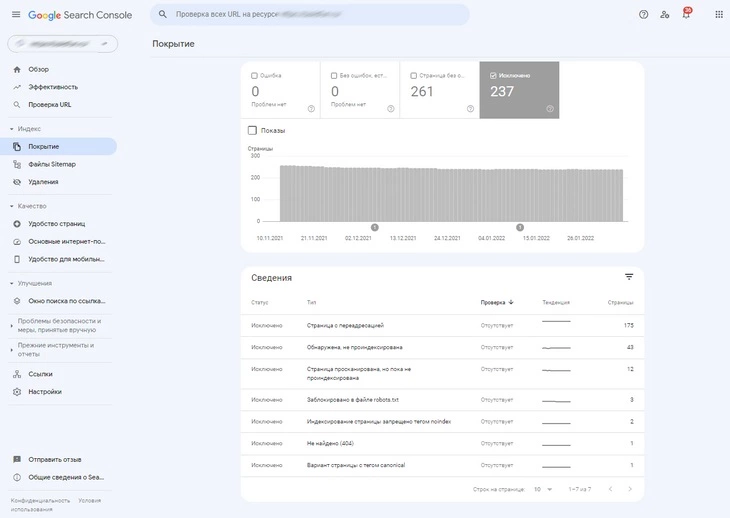

В отчете «Меры, принятые вручную» указываются санкции, которые были применены к вашему домену со стороны Google

Причина 4. Скорость загрузки страницы

Скорость загрузки – важный фактор ранжирования сайта. Вы можете проанализировать скорость загрузки сайта при помощи автоматических инструментов: PageSpeed Insights, WebPageTest, Pingdom Website Speed Test.

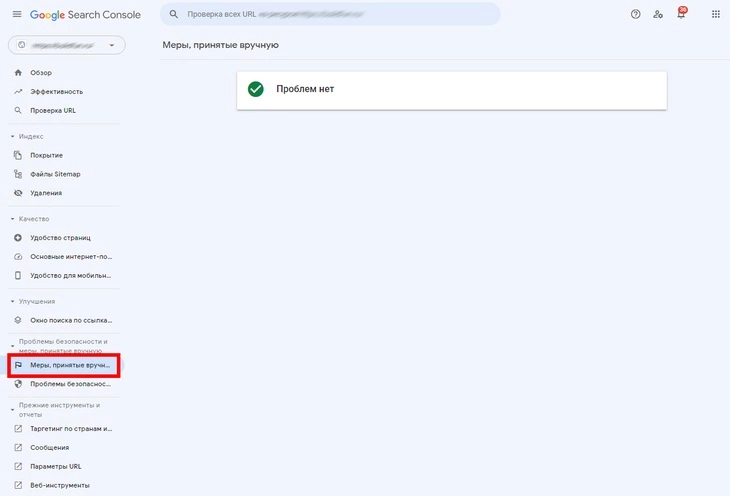

Сайты, не соответствующие минимальным значениям Core Web Vitals, ухудшают пользовательский опыт, загружаясь недостаточно быстро. Вот простые рекомендации, которые помогут улучшить оценки Core Web Vitals на сайте:

- оптимизируйте скорость загрузки изображений, внедрив ленивую загрузку (картинки не будут загружаться, пока пользователь до них не дойдет);

- уменьшите физический размер HTML-кода страницы;

- удалите ошибки в JS;

- внедрите кэширование данных.

Если скорость критически низкая, и вам не удалось оптимизировать сайт самостоятельно, подключите разработчиков.

При помощи этих инструментов вы можете измерить показатели LCP, FID, CLS у своего сайта

Причина 5. Сезонный фактор

Большая часть информационных и товарных ниш отличается ярко выраженным сезонным фактором. Это значит, наибольший объем трафика сайт получает не круглогодично, а в определенные месяцы.

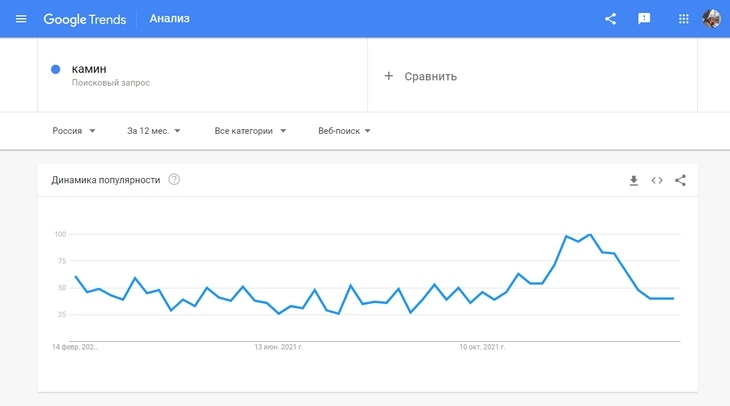

Проверить динамику популярности ключевой фразы за год можно при помощи сервиса Google Trends. Он покажет все колебания интереса к теме и позволит сделать выводы о сезонности темы.

Динамика популярности поискового запроса “камин”

Для изучения популярности запроса вы также можете использовать «Подбор слов». Еще можно опираться на «Яндекс.Метрику», если есть статистика за несколько лет.

Причина 6. Обновление алгоритмов ранжирования

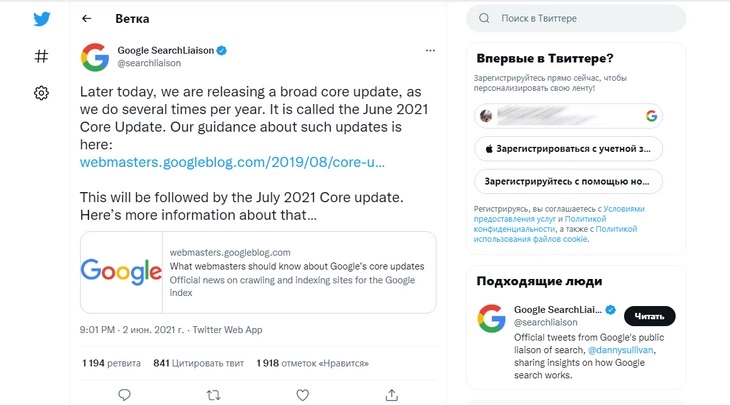

Серьезное падение поискового трафика по большинству страниц может быть связано с глобальными изменениями в механизмах ранжирования Google и «Яндекс». Такие изменения всегда анонсируются поисковыми системами и, как правило, внедряются поэтапно:

Пример анонса алгоритма June 2021 Core Update в Twitter

Сервис Algoroo поможет отследить просадки органического трафика, связанные с обновлением алгоритмов ранжирования.

Причина 7. Редиректы

Если вы настроили глобальное перенаправление (например, с домена с www на версию без www), то сайт вообще может стать недоступным для посетителей. Редиректы, особенно если они сложные, должны настраиваться только техническими специалистами. Пример настройки перенаправления на домен без www при помощи добавления команд в .htaccess:

RewriteEngine On RewriteCond %{HTTP_HOST} ^www.site.ru$ [NC] RewriteRule ^(.*)$ http://site.ru/$1 [R=301,L]

Вышеуказанный способ сработает только на Linux.

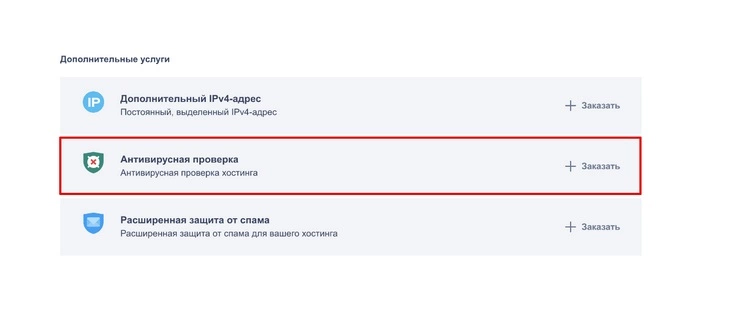

Причина 8. Вирусы

Google и «Яндекс» не любят сайты, на которых присутствует вредоносный код. Заражение вирусом – реалистичный сценарий резкого падения поискового трафика. Проверяйте свой домен при помощи сканеров вирусов, например, Kaspersky VirusDesk или QUTTERA.

Антивирус reg.ru доступен в разделе «Домены и услуги». Откройте его и пройдите в пункт «Рекомендуем», а затем – кликните по строке «Больше услуг»

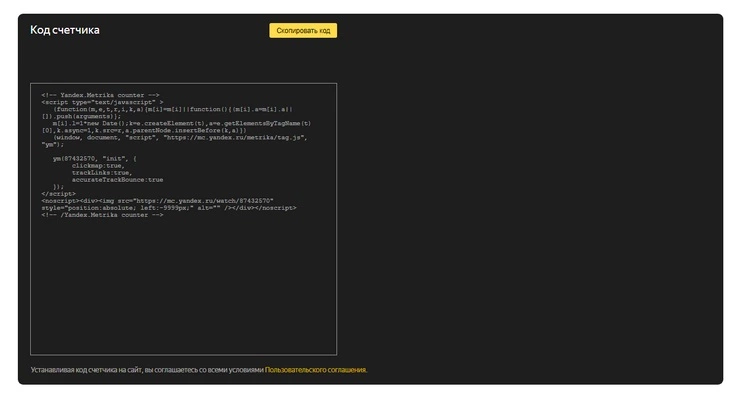

Причина 9. Слетел код счетчика веб-аналитики

Такое бывает по разным причинам: действия сторонних плагинов внутри CMS, изначально некорректная установка счетчика, изменение шаблона сайта, изменения вида URL.

Если слетает код счетчика, веб-аналитика не будет показывать вообще никакой трафик. В таком случае переустановите код счетчика.

Пример кода счетчика «Яндекс.Метрики»

Причина 10. Конкуренты

Конкуренция в органической выдаче – еще одна возможная причина снижения трафика из поисковых систем. Если в вашей нише появился качественный и сильный конкурент, позиции вашего сайта могут стремительно ухудшиться.

Работайте над экспертностью контента и делайте все, чтобы сформировать постоянную аудиторию и привлечь новых пользователей.

Причина 11. Технические ошибки

Самые распространенные технические ошибки:

- некорректный ответ (500-е, 400-е, 300-е и так далее);

- большое количество перенаправлений, сложные цепочки редиректов;

- большое количество дублей страниц;

- несовпадение кодировки сайта и сервера.

Все это – причины для исключения страницы из результатов поиска

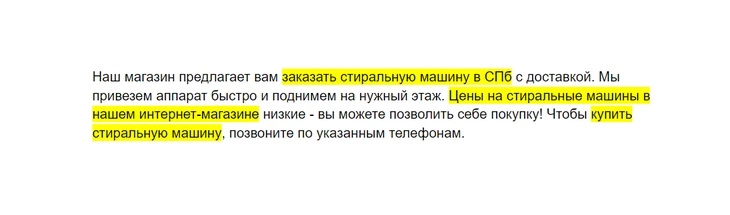

Причина 12. Переоптимизация в анкорах ссылок

Желательно соблюдать естественное соотношение ссылок в ссылочном профиле сайта: 10 % – URL с анкорами, 90 % – без анкоров. Околоссылочный текст также не должен представлять из себя поисковый спам.

Пример переспама в анкорах ссылок. Стандартный синий цвет URL заменен и выделен желтым (для наглядности)

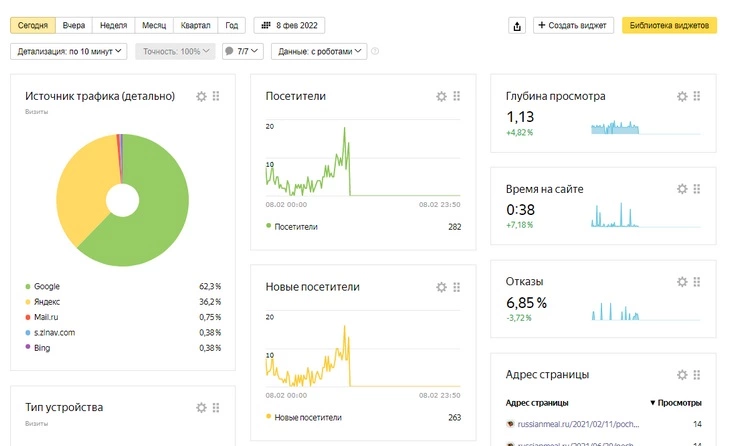

Причины 13. Ухудшение поведенческих факторов

Если поведенческие факторы вашего сайта долго находились «на грани», нет ничего удивительного в потере поискового трафика. Google и «Яндекс» учитывают поведение пользователя на каждой странице сайта.

Такое «Время на сайте» никуда не годится

Если пользователь сразу покидает страницу, позиции страницы рано или поздно снизятся. Высокий % отказов – причина плохих позиций даже по низкочастотным запросам.

Работайте над релевантностью контента по отношению к заголовку страницы, добиваясь улучшения метрик «Время на сайте» и «Глубина просмотра».

Причина 14. Сайт давно не обновлялся

Судя по сообщениям зарубежных оптимизаторов и самого Google, поисковая система внимательно следит за тем, как часто на сайте появляются новые страницы и обновляются старые.

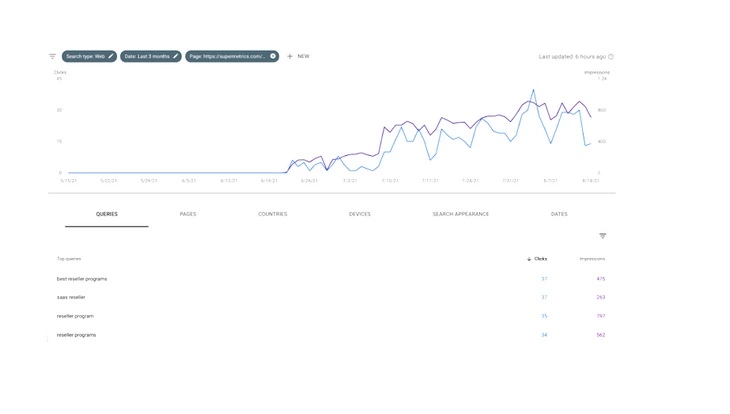

Рост поискового трафика после обновления и актуализации старых статей на сайте

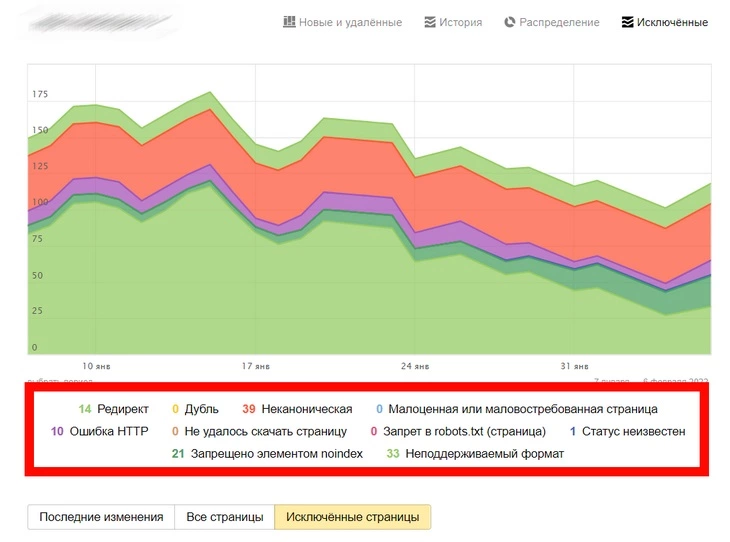

Причина 15. Ошибки покрытия в Google Search Console и «Яндекс.Вебмастере»

Чтобы страница присутствовала в результатах поиска и приносила трафик, она должна быть проиндексирована поисковым роботом. Иногда страницы не попадают в индекс автоматически после создания, а иногда покидают его со временем, если:

- краулер не может получить доступ к содержимому веб-страницы – проверьте файл robots.txt и удалите все запрещающие директивы (слово disallow), убедитесь, что страница загружается и не отдает ошибку;

- битые URL – удалите битые ссылки на сайте вручную или с помощью плагина (например, Broken Link Checker для WordPress);

- нет HTML-тегов – пропишите уникальные метатеги title и description для каждой страницы;

- некорректно отображаются мобильные страницы – внедрите адаптивную верстку (в идеале) или сделайте отдельную мобильную версию сайта на поддомене;

- серверные сбои – напишите в саппорт и уточните, нет ли перебоев в работе сервера;

- дублирование контента – удалите страницы, на которых дублируется контент.

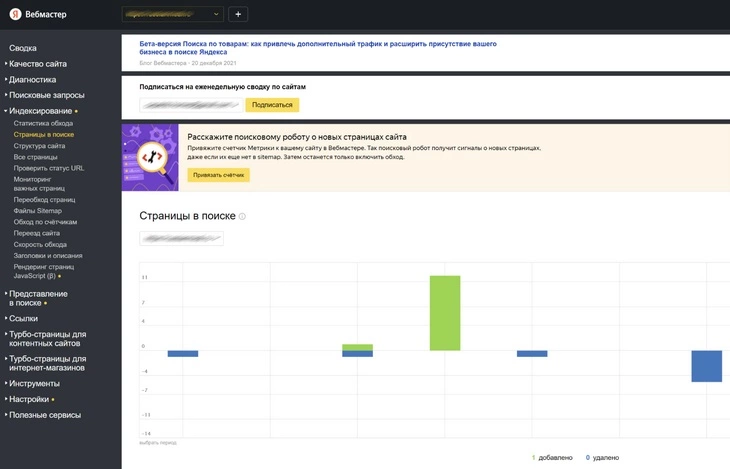

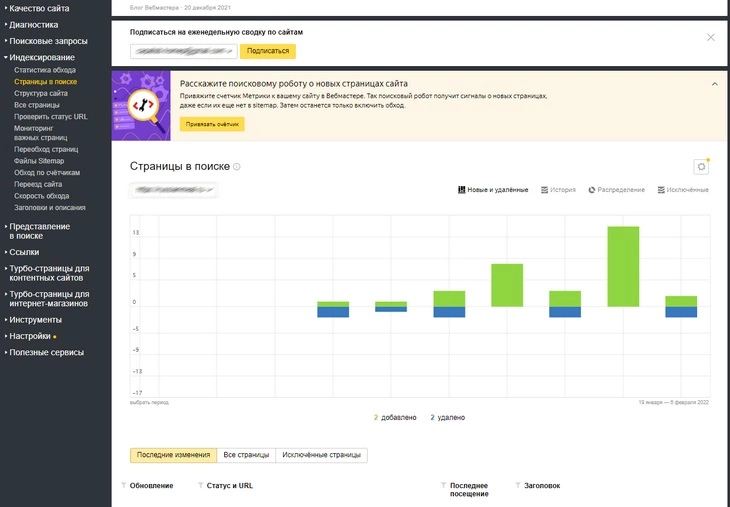

Мониторить отчеты по индексированию можно в инструментах «Вебмастера»:

- проверьте наличие критических ошибок в вебмастерах;

- проверьте сайт на наличие вредоносного кода;

- проверьте индексацию сайта.

График добавления и удаления страниц из поисковой выдачи «Яндекс». Чтобы проанализировать страницы вашего сайта, участвующие в поиске, откройте отчет «Страницы в поиске» в «Яндекс.Вебмастере»

Как восстановить поисковый трафик сайта

- Проанализируйте все источники трафика.

- Убедитесь, что просадка наблюдается именно в посещаемости из поисковых систем.

- Проверьте отчет «Безопасность и нарушения» в «Яндекс.Вебмастере», а также отчеты «Меры, принятые вручную» и «Проблемы безопасности» в Google Search Console. Если на домене есть санкции ПС или найден вредоносный код, в этих отчетах вы увидите дополнительную информацию.

Если восстановить трафик не удается, обратитесь за помощью к «Текстерре». Максимально быстро исправим недостатки сайта и поможем привлечь новых посетителей.

Читайте также:

Кейс успешного SEO-продвижения при минимальном бюджете

Google Core и Spam Update 2024 – чем это грозит вашему сайту

Google Trends: полная инструкция по важнейшему сервису для маркетологов