Google закончил развертывание обновление основного алгоритма August Core Update, которое было запущено 15 августа 2024 года. На это ушло 19 дней, хотя планировалость около 30-ти.

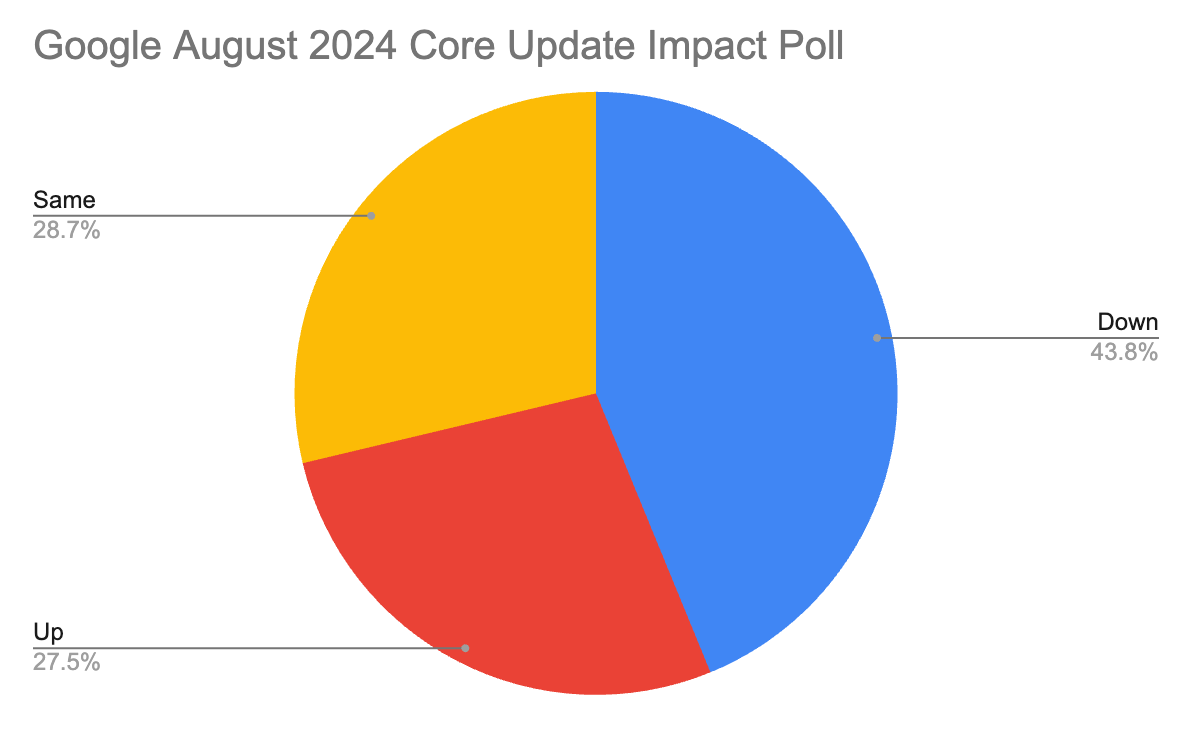

August Core Update позволит поисковику отсекать некачественный и малополезный контент. Чаще этим грешат тексты, которые пишутся не для пользы людей, а для SEO – тексты для поисковиков с ключевыми словами и словосочетаниями. Поэтому те сайты, где таких текстов много, уже начали проседать по трафику. И таких сайтов оказалась почти половина (синий сектор диаграммы ниже)! Согласно опросам, расти трафик продолжает только у 27,5% сайтов (красный сектор диаграммы), у остальных – стоит на месте (желтый сектор диаграммы), что уже нельзя назвать продвижением.

При этом люди не стали делать меньше запросов. Так куда же они ушли, если на вашем сайте их нет? Правда жестока – к конкурентам.

Как и Google, эксперты TexTerra рекомендуют подтянуть тексты и улучшить представленный на сайтах контент, для чего предпочтительнее нанять профессионалов.

Александр Белов, ведущий аналитик TexTerra:

«Запуск обновления Google August 2024 Core Update привел к значительным изменениям в алгоритмах ранжирования. Google все больше акцентирует внимание на факторах E-E-A-T (Expertise, Authoritativeness, Trustworthiness), что видно из улучшения или отсутствия изменений позиций у авторитетных сайтов с долгой историей и недавно созданных сайтов, предоставляющих качественный контент. Сайты, полагающиеся на генерацию текстов ИИ или содержащие малополезный контент, получили значительную просадку позиций и трафика. Все это является частью постоянных усилий Google по улучшению качества поисковой выдачи и борьбе с малополезным контентом.

В свете текущих обновлений и направления развития алгоритмов, важно регулярно анализировать контент на предмет его полезности, релевантности и структуры. Необходимо отслеживать использование ИИ для генерации текстов, а также наличие страниц с малым содержанием контента, которые не дают полных ответов на вопросы, чтобы избежать негативных последствий. Кроме того, стоит учитывать поведенческие факторы, такие как взаимодействие пользователей с сайтом и время, проведенное на странице сайта, так как они играют ключевую роль в ранжировании».

Но удалять некачественный контент, из-за которого сайт теряет позиции, ни в коем случае нельзя, тем более, вместе со страницей – исчезновение контента и страниц тоже негативно сказывается на SEO и на поисковой выдаче. Об этом предупреждает и сам Google:

«Удаление контента должно быть крайней мерой… если он был создан для поисковых систем, а не для пользователей».

Далее в статье мы приведем подробности апдейтов и расскажем, что ждет сайты в будущем.

О новых апдейтах Google

Google объявил о развертывании алгоритмов Core и Spam Update — в последний раз они происходили параллельно в октябре 2023 года. Тогда Google продолжил движение в сторону E-E-A-T-контента ( концепция четырех ключевых элементов качественного контента: опыта, компетентности, авторитетности и достоверности). А также сократил в выдаче количество сайтов, которые занимаются клоакингом, фишингом — в общем, показывают себя как спамные.

В марте продолжается примерно та же самая ситуация — только Core Update будет более масштабным, чем ранее. В этот раз развертывание Core Update займет месяц, а Spam Update — около двух недель.

Элизабет Такер, директор по продуктам для поиска в Google:

«Мы вносим алгоритмические усовершенствования в наши основные системы ранжирования, чтобы обеспечить отображение наиболее полезной информации в Интернете и уменьшить количество неоригинального контента в результатах поиска».

Google ожидает, что объединение Core Update и предыдущих усилий по приоритизации E-E-A-T контента позволит сократить количество некачественных и неоригинальных сайтов в результатах поиска на 40%.

А Spam Update обновляет политику в отношении спама. Поисковая система усиливает борьбу с разными типами контента, которые являются вредными для пользователей. Их можно разделить на три основных группы:

- Expired и дроп-домены

Изначально домен регистрировался для одной цели — например, на медицинскую тематику — а потом начал использоваться для других целей. Получается, что у домена одна история и одна тематика в прошлом, а сейчас он занимается другим.

- Масштабные злоупотребления контентом

Если на сайте создается много мусорных страниц, которые на самом деле не закрывают пользовательский интент — часто такой контент генерируется с помощью ИИ.

- Злоупотребления репутацией сайта

Когда манипулируют ссылками, размещают платные SEO-статьи — по-другому это называют «паразитным» SEO. Advanced SEO приводит несколько примеров:

- Образовательный сайт, размещающий страницу с обзорами быстрых займов, написанными сторонними лицами, которые распространяют эту страницу по всему интернету, с целью манипулирования ранжированием.

- Медицинский сайт, на котором размещена страница о «лучших казино», созданная с целью манипулирования ранжированием, с малым участием или без участия владельца сайта.

- Сайт рецензий на фильмы, на котором размещены сторонние страницы на темы, которые были бы странными для пользователей сайта (такие как «способы покупки подписчиков на сайтах социальных сетей», «лучшие сайты гадалок» и «лучшие сервисы написания эссе»), где цель заключается в манипулировании ранжированием.

Можно ожидать, что после обновления многие сайты, которые манипулируют поиском способами, описанными выше, будут понижены в выдаче.

О ручных санкциях

Сразу после объявления о развертывании апдейтов Google, согласно многим заявлениям SEO-специалистов и владельцев сайтов, вручную применил к некоторым сайтам санкции.

На канале «SEO без воды» собрали примеры подобных кейсов — в основном из выдачи были выброшены или понижены в позициях сайты, владельцы которых учили манипулировать поиском и «штамповать» ИИ-контент.

1,9% сайтов информационной тематики получили ручные санкции от Google, согласно исследованию Джонатана Гиллхэма. В исследовании были рассмотрены 79 000 сайтов инфо-тематики на разных языках. Вот что получилось:

- 1446 сайтов (1,9%) полностью ушли из индекса, их трафик стал равняться нулю.

- Cуммарная потеря их трафика составила около 20 млн посетителей в месяц.

- У трех сайтов с миллионной посещаемостью трафик упал до нуля.

- 100% сайтов, подвергшихся ручным санкциям от Google, создавали контент через ИИ-инструменты.

- У 50% из сайтов, которые ушли из поиска, доля AI-контента составляла не менее 90%.

Что ждет сайты в будущем

Кажется, если вы не пишете статьи на тему «Как обмануть Google и делать контент только с помощью ИИ» — вы вне опасности. Как можно увидеть из приведенных выше данных, санкции и обновления, в первую очередь, коснулись тех, кто пытался манипулировать поиском и плодил мусорные страницы, которые не ценны для пользователя.

Можно ожидать, что дальше такой контент будет все сильнее понижаться в ранжировании и «выбрасываться» из индекса. Можно также предположить, что и Яндекс пойдет по такому пути, а значит, ни одна из крупных поисковых систем в России не будет терпеть засилье ИИ-контента и манипуляции.

В то же время даже статьи про то, как создавать ИИ-контент и в целом сгенерированный с помощью сервисов контент не будут большой проблемой, если они будут сопровождаться полезными рекомендациями, личным опытом, картинками, инфографикой — в общем, всем, что делает контент лучше и полезнее для его конечного потребителя — вашего читателя.

Спросили эксперта нашей компании, как обновления, ручные санкции и новые правила Google скажутся на сайтах, а также что все это значит и для чего делается.

Александр Белов, ведущий аналитик TexTerra:

«Всё закономерно. Сначала Google добавляет экспертизу в основу своих алгоритмов E-E-A-T, а теперь делает Core Update и Spam Update параллельно друг другу.

Качество контента и общих показателей сайта всегда было наиболее значимым показателем для Google, наравне с ссылочным профилем. У Google есть целый материал про то, как создавать полезный и заслуживающий доверия контент, ориентированный на людей. Неудивительно, что они продолжают работать над своей и без того успешной системой SpamBrain, что позволяет роботу находить „себе подобных“ и отличать тексты, написанные человеком, от ИИ-текстов.

Мне кажется, это хороший сигнал для тех, кто считал, что контент-агентства больше не нужны и можно будет и дальше публиковать материалы, написанные с помощью нейросетей. Так не получится».

Читайте также:

Как писать SEO-тексты в 2024 году: 9 главных советов