Если интернет – огромная библиотека, то поисковые системы – ее сверхбыстрые сотрудники, способные быстро сориентировать читателя (интернет-пользователя) в бескрайнем океане информации. В этом им помогает систематизированная картотека – собственная база данных.

Когда пользователь вводит ключевую фразу, поисковая система показывает результаты из этой базы данных. То есть ПС хранят на своих серверах копии документов и обращаются к ним, когда пользователь отправляет запрос. Чтобы представить в выдаче определенную страницу, ее нужно сперва добавить в базу (индекс). Поэтому только что созданные сайты, о которых поисковики не знают, в выдаче не участвуют.

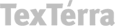

Поисковая система отправляет своего робота (он же паук, он же краулер) на поиски новых страниц, которые появляются в сети ежесекундно. Паучья стая собирает данные, передвигаясь по ссылкам с одной страницы на другую, и передает их в базу. Обработку информации производят уже другие механизмы.

У каждой поисковой системы – свой набор ботов, выполняющих разные функции. Вот пример некоторых роботов «Яндекса»:

- Основной робот.

- Индексатор картинок.

- Зеркальщик (обнаруживает зеркала сайта).

- Быстробот. Эта особь обитает на часто обновляемых сайтах. Как правило – новостных. Контент появляется в выдаче практически сразу после размещения. При ранжировании в таких случаях учитывается лишь часть факторов, поэтому позиции страницы могут измениться после прихода основного робота.

У «Гугла» тоже есть свой робот для сканирования новостей и картинок, а еще – индексатор видео, мобильных сайтов и т. д.

Скорость индексирования новых сайтов у разных ПС отличается. Каких-то конкретных сроков здесь нет, есть лишь примерные временные рамки: для «Яндекса» – от одной недели до месяца, для Google – от нескольких минут до недели. Чтобы не ждать индексации неделями, нужно серьезно поработать. Об этом и пойдет речь в статье.

Сперва давайте узнаем, как проверить, проиндексирован ли сайт.

Как проверить индексацию сайта

Проверить индексацию можно тремя основными способами:

- Сделать запрос в поисковик, используя специальные операторы.

- Воспользоваться инструментами вебмастеров (Google Search Console, «Яндекс.Вебмастер»).

- Воспользоваться специализированными сервисами или скачать расширение в браузер.

Поисковые операторы

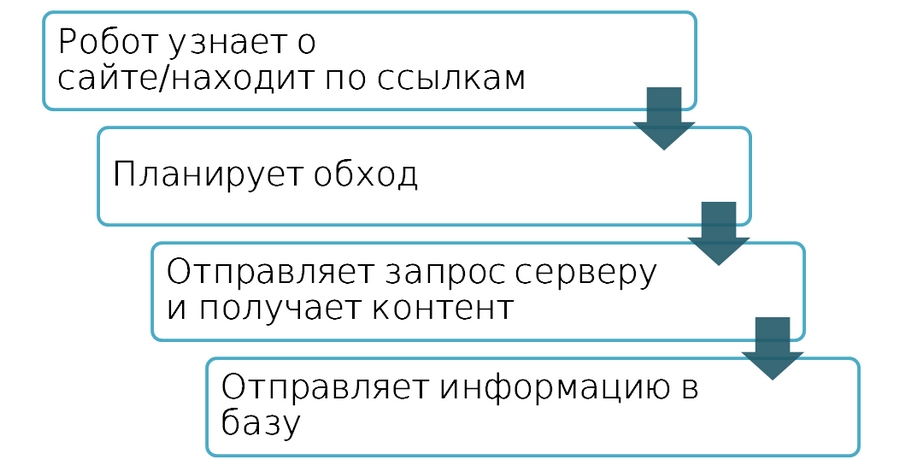

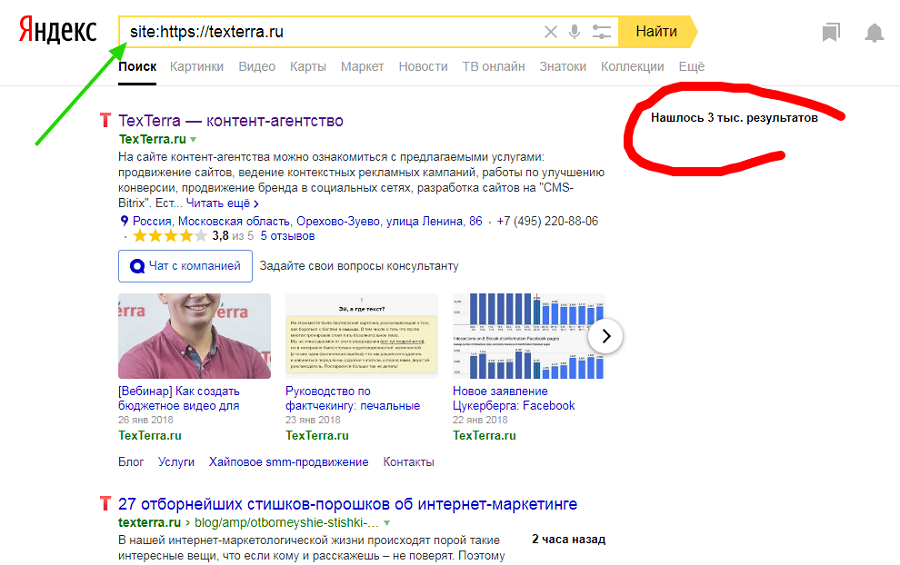

Быстро и просто примерное количество проиндексированных страниц можно узнать с помощью оператора site. Он действует одинаково в «Яндекс» и «Гугл».

Сервисы для проверки индексации

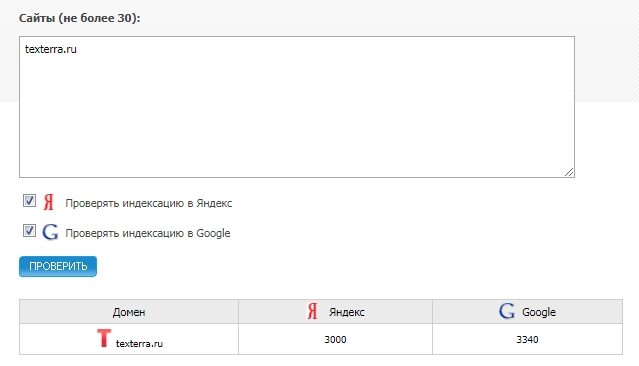

Бесплатные сервисы позволяют быстро узнать количество проиндексированных «Яндексом» и Google страниц. Есть, к примеру, очень удобный инструмент от XSEO.in и SEOGadget (можно проверять до 30 сайтов одновременно).

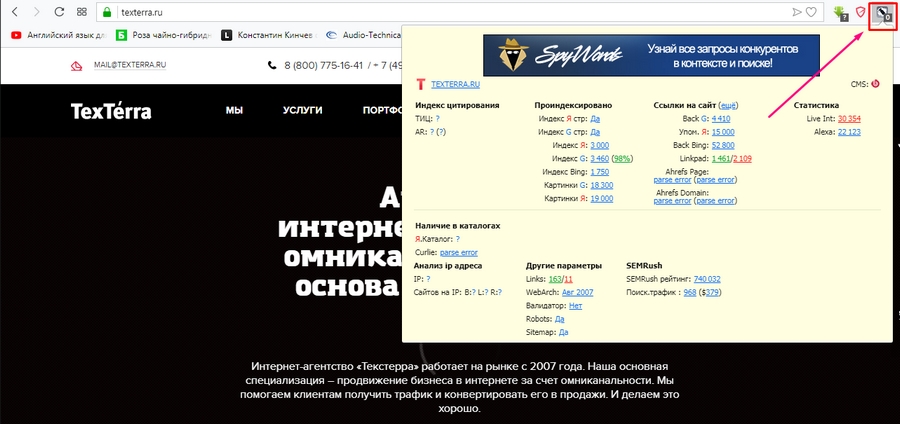

У RDS целая линейка полезных инструментов для проверки показателей сайтов, в том числе проиндексированных страниц. Можно скачать удобный плагин для браузера (поддерживаются Chrome, Mozilla и Opera) или десктопное приложение.

Вообще плагин больше подходит профессиональным SEOшникам. Если вы обычный пользователь, будьте готовы, что эта утилита будет постоянно атаковать вас лишней информацией, вклиниваясь в код страниц, и в итоге придется либо ее настраивать, либо удалять.

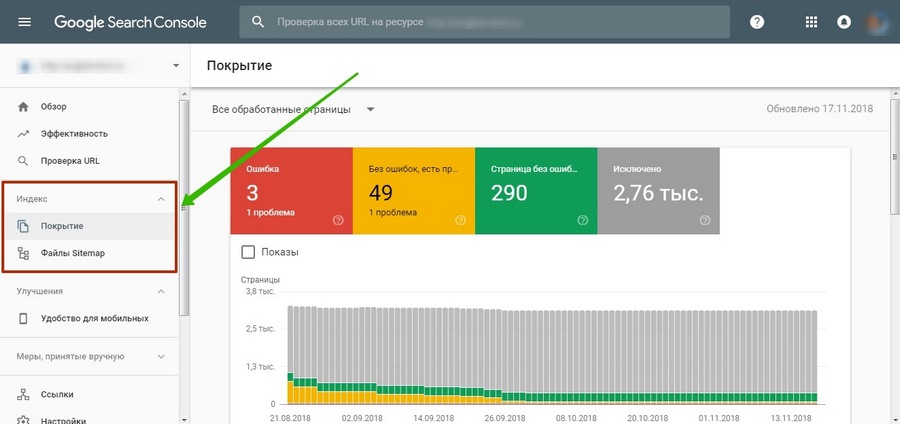

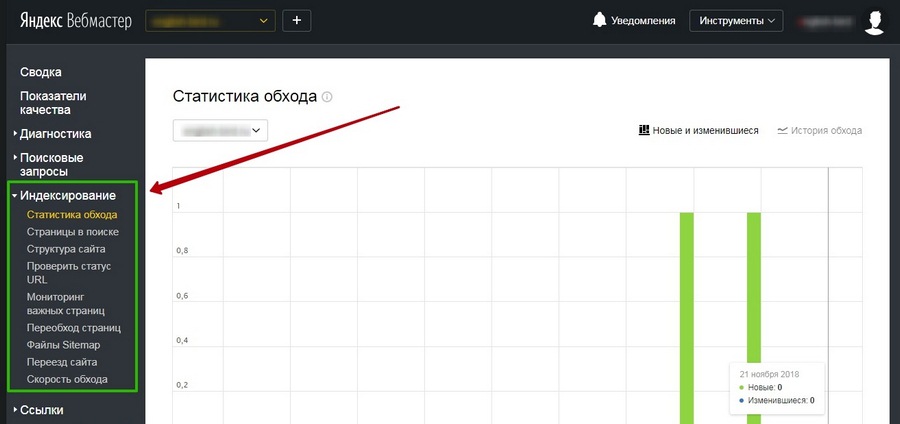

Панели вебмастера

«Яндекс.Вебмастер» и Google Search Console предоставляют подробную информацию об индексировании. Так сказать, из первых уст.

В старой версии GSC можно также посмотреть статистику сканирования и ошибки, с которыми сталкиваются роботы при обращении к страницам.

Подробнее о данных об индексировании, представленных в панелях вебмастеров, можно почитать в соответствующих разделах наших руководств по «Яндекс.Вебмастеру» и Google Search Console.

Как контролировать индексацию

Поисковые системы воспринимают сайты совсем не так, как мы с вами. В отличие от рядового пользователя, поисковый робот видит всю подноготную сайта. Если его вовремя не остановить, он будет сканировать все страницы, без разбора, включая и те, которые не следует выставлять на всеобщее обозрение.

При этом нужно учитывать, что ресурсы робота ограничены: существует определенная квота – количество страниц, которое может обойти паук за определенное время. Если на вашем сайте огромное количество страниц, есть большая вероятность, что робот потратит большую часть ресурсов на «мусорные» страницы, а важные оставит на будущее.

Поэтому индексированием можно и нужно управлять. Для этого существуют определенные инструменты-помощники, которые мы далее и рассмотрим.

Robots.txt

Robots.txt – простой текстовый файл (как можно догадаться по расширению), в котором с помощью специальных слов и символов прописываются правила, которые понимают поисковые системы.

Директивы, используемые в robots.txt:

|

Директива |

Описание |

|

User-agent |

Обращение к роботу. |

|

Allow |

Разрешить индексирование. |

|

Disallow |

Запретить индексирование. |

|

Host |

Адрес главного зеркала. |

|

Адрес карты сайта. |

|

|

Crawl-delay |

Время задержки между скачиванием страниц сайта. |

|

Clean-param |

Страницы с какими параметрами нужно исключить из индекса. |

User-agent показывает, к какому поисковику относятся указанные ниже правила. Если адресатом является любой поисковик, пишем звездочку:

User-agent: Yandex

User-agent: GoogleBot

User-agent: Bingbot

User-agent: Slurp (поисковый робот Yahoo!)

User-agent: *

Самая часто используемая директива – disallow. Как раз она используется для запрета индексирования страниц, файлов или каталогов.

К страницам, которые нужно запрещать, относятся:

- Служебные файлы и папки. Админ-панель, файлы CMS, личный кабинет пользователя, корзина и т. д.

- Малоинформативные вспомогательные страницы, не нуждающиеся в продвижении. Например, биографии авторов блога.

- Различного вида дубли основных страниц.

На дублях остановимся подробнее. Представьте, что у вас есть страница блога со статьей. Вы прорекламировали эту статью на другом ресурсе, добавив к существующему URL UTM-метку для отслеживания переходов. Адрес немного изменился, но он все еще ведет на ту же страницу – контент полностью совпадает. Это дубль, который нужно закрывать от индексации.

Не только системы статистики виноваты в дублировании страниц. Дубли могут появляться при поиске товаров, сортировке, из-за наличия одного и того же товара в нескольких категориях и т. д. Даже сами движки сайта часто создают большое количество разных дублей (особенно Wordpress и Joomla).

Помимо полных дублей существуют и частичные. Самый лучший пример – главная страница блога с анонсами записей. Как правило, анонсы берутся из статей, поэтому на таких страницах отсутствует уникальный контент. В этом случае анонсы можно уникализировать или вовсе убрать (как в блоге Texterra).

У подобных страниц (списки статей, каталоги товаров и т. д.) также присутствует постраничная навигация (пагинация), которая разбивает список на несколько страниц. О том, что делать с такими страницами, Google подробно расписал в своей справке.

Дубли могут сильно навредить ранжированию. Например, из-за большого их количества поисковик может показывать по определенным запросам совершенно не те страницы, которые вы планировали продвигать и на которые был сделан упор в плане оптимизации (например, есть усиленная ссылками страница товара, а поисковик показывает совершенно другую). Поэтому важно правильно настроить индексацию сайта, чтобы этой проблемы не было. Как раз один из способов борьбы с дублями – файл robots.txt.

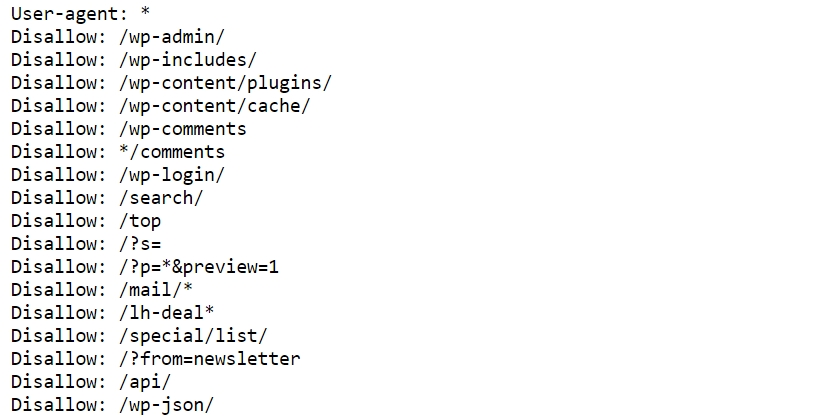

Пример robots.txt для одного известного блога:

При составлении robots.txt можно ориентироваться на другие сайты. Для этого просто добавьте в конце адреса главной страницы интересующего сайта после слеша «robots.txt».Не забывайте только, что функционал у сайтов разный, поэтому полностью скопировать директивы топовых конкурентов и жить спокойно не получится. Даже если вы решите скачать готовый robots.txt для своей CMS, в него все равно придется вносить изменения под свои нужды.

Давайте разберемся с символами, которые используются при составлении правил.

Путь к определенному файлу или папке мы указываем через слеш (/). Если указана папка (например, /wp-admin/), все файлы из этой папки будут закрыты для индексации. Чтобы указать конкретный файл, нужно полностью указать его имя и расширение (вместе с директорией).

Если, к примеру, нужно запретить индексацию файлов определенного типа или страницу, содержащую какой-либо параметр, можно использовать звездочки (*):

Disallow: /*openstat=

Disallow: /*?utm_source=

Disallow: /*price=

Disallow: /*gclid=*

На месте звездочки может быть любое количество символов (а может и не быть вовсе). Значок $ используется, когда нужно отменить правило, созданное значком *. Например, у вас есть страница eda.html и каталог /eda. Директива «/*eda» запретит индексацию и каталога, и страницы. Чтобы оставить страницу открытой для роботов, используйте директиву «/eda$».

Запретить индексацию страниц с определенными параметрами также можно с помощью директивы clean-param. Подробнее об этом можно прочитать в справке «Яндекса».

Директива allow разрешает индексирование отдельных каталогов, страниц или файлов. Например, нужно закрыть от ПС все содержимое папки uploads за исключением одного pdf-файла. Вот как это можно сделать:

Disallow: /wp-content/uploads/

Allow: /wp-content/uploads/book.pdf

Следующая важная (для «Яндекса») директива – host. Она позволяет указать главное зеркало сайта.

У сайта может быть несколько версий (доменов) с абсолютно идентичным контентом. Даже если у вас домен единственный, не стоит игнорировать директиву host, это разные сайты, и нужно определить, какую версию следует показывать в выдаче. Об этом мы уже подробно писали в статье «Как узнать главное зеркало сайта и настроить его с помощью редиректа».

Еще одна важная директива – sitemap. Здесь (при наличии) указывается адрес, по которому можно найти карту вашего сайта. О том, как ее создать и для чего она нужна, поговорим позже.

Наконец, директива, которая применяется не так часто – crawl-delay. Она нужна в случае, когда нагрузка на сервер превышает лимит хостинга. Такое редко встречается у хороших хостеров, и без видимых причин устанавливать временные ограничения на скачивание страниц роботам не стоит. К тому же скорость обхода можно регулировать в «Яндекс.Вебмастере».

Нужно отметить, что поисковые системы по-разному относятся к robots.txt. Если для «Яндекса» это набор правил, которые нельзя нарушать, то «Гугл» воспринимает его, скорее, как рекомендацию и может проигнорировать некоторые директивы.

В robots.txt нельзя использовать кириллические символы. Поэтому если у вас кириллический домен, используйте онлайн-конвертеры.

После создания файла его нужно поместить в корневой каталог сайта, т. е.: site.ru/robots.txt.

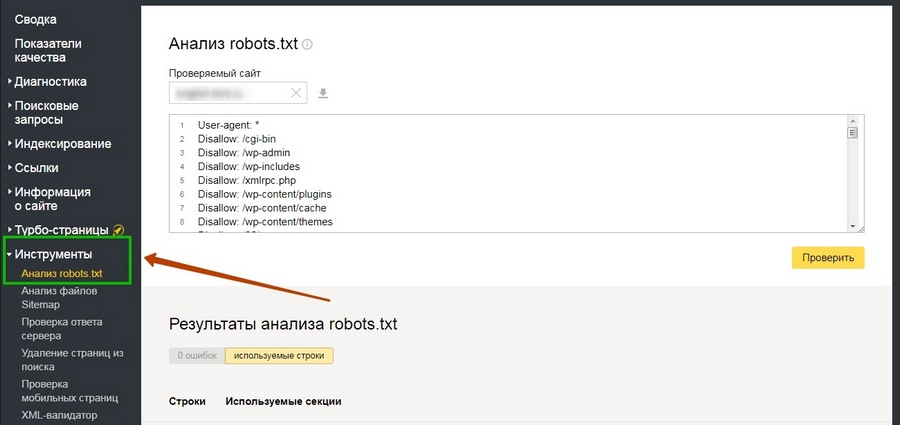

Проверить robots.txt на наличие ошибок можно в разделе «Инструменты» панели «Яндекс.Вебмастер»:

В старой версии Google Search Console тоже есть такой инструмент.

Как закрыть сайт от индексации

Если вам по какой-то причине нужно, чтобы сайт исчез из выдачи всех поисковых систем, сделать это очень просто:

User-agent: *

Disallow: /

Крайне желательно делать это, пока сайт находится в разработке. Чтобы снова открыть сайт для поисковых роботов, достаточно убрать слеш (главное – не забыть это сделать при запуске сайта).

Nofollow и noindex

Для настройки индексации используются также специальные атрибуты и html-теги.

У «Яндекса» есть собственный тег <noindex>, с помощью которого можно указать роботу, какую часть текста он не должен индексировать. Чаще всего это служебные части текста, которые не должны отображаться в сниппете, или фрагменты, которые не должны учитываться при оценке качества страницы (неуникальный контент).

Проблема в том, что этот тег практически никто кроме «Яндекса» не понимает, поэтому при проверке кода большинство валидаторов выдают ошибки. Это можно исправить, если слегка изменить внешний вид тегов:

<!—noindex-->текст<!--/noindex-->

Атрибут rel=”nofollow” позволяет закрыть от индексации отдельные ссылки на странице. В отличие от <noindex> его понимают все поисковые системы. Чтобы запретить роботу переходить по всем ссылкам на странице сразу, проще использовать вот такой мета-тег: <meta name="robots" content="nofollow" />.

Кстати, на мега-теге robots стоит остановиться подробнее. Как и файл robots.txt, он позволяет управлять индексацией, но более гибко. Чтобы понять принцип работы, рассмотрим варианты инструкций:

|

<meta name="robots" content="index,follow" /> |

индексировать контент и ссылки |

|

<meta name="robots" content="noindex,nofollow" /> |

не индексировать контент и ссылки |

|

<meta name="robots" content="noindex,follow" /> |

не индексировать контент, но переходить по ссылкам |

|

<meta name="robots" content="index,nofollow" /> |

индексировать контент, но не переходить по ссылкам |

Это далеко не все примеры использования мета-тега robots, так как помимо nofollow и noindex существуют и другие директивы. Например, noimageindex, запрещающая сканировать изображения на странице. Подробнее почитать об этом мета-теге и его применении можно в справке от Google.

Rel=”canonical”

Еще один способ борьбы с дублями – использование атрибута rel=”canonical”. Для каждой страницы можно задать канонический (предпочитаемый) адрес, который и будет отображаться в поисковой выдаче. Прописывая атрибут в коде дубля, вы «прикрепляете» его к основной странице, и путаницы c ee версиями не возникнет. При наличии у дубля ссылочного веса он будет передаваться основной странице.

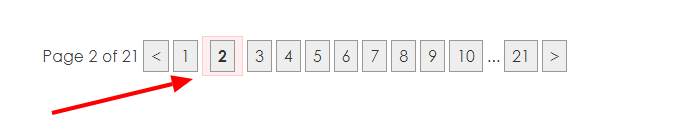

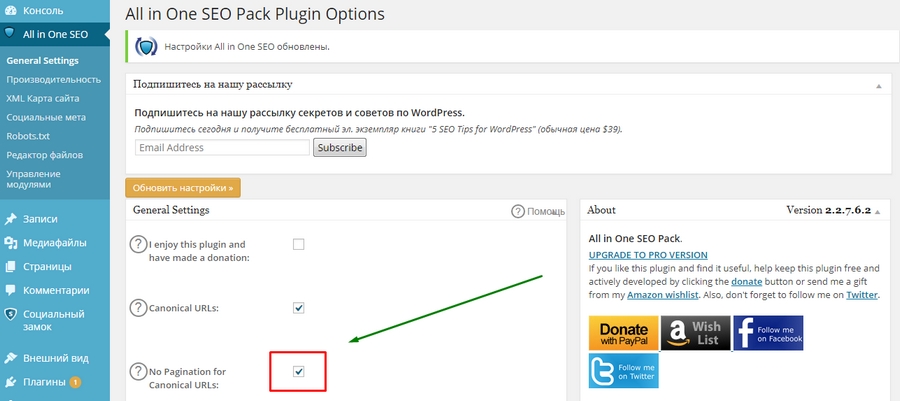

Вернемся к примеру с пагинацией в Wordpress. С помощью плагина All in One SEO можно в один клик решить проблему с дублями этого типа. Посмотрим, как это работает.

Зайдем главную страницу блога и откроем, к примеру, вторую страницу пагинации.

Теперь посмотрим исходный код, а именно – тег <link> с атрибутом rel="canonical" в разделе <head>. Изначально он выглядит так:

<link rel="canonical" target="_blank" href="http://site.ru/page/2/">

Каноническая ссылка установлена неправильно – она просто повторяет физический адрес страницы. Это нужно исправить. Переходим в общие настройки плагина All in One SEO и отмечаем галочкой пункт «No Pagination for Canonical URLs» (Запретить пагинацию для канонических URL).

После обновления настроек снова смотрим код, теперь должно быть вот так:

<link rel="canonical" target="_blank" href="http://site.ru/">

И так – на любой странице, будь то вторая или двадцатая. Быстро и просто.

Но есть одна проблема. Для Google такой способ не подходит (он сам об этом писал), и использование атрибута canonical может негативно отразиться на индексировании страниц пагинации. Если для блога это, в принципе, не страшно, то со страницами товаров лучше не экспериментировать, а использовать атрибуты rel=”prev” и rel=”next”. Только вот «Яндекс» их, по словам Платона Щукина, игнорирует. В общем, все неоднозначно и ничего не понятно, но это нормально – это SEO.

sitemap (карта сайта)

Если файл robots.txt указывает роботу, какие страницы ему трогать не надо, то карта сайта, напротив, содержит в себе все ссылки, которые нужно индексировать.

Главный плюс карты сайта в том, что помимо перечня страниц она содержит полезные для робота данные – дату и частоту обновлений каждой страницы и ее приоритет для сканирования.

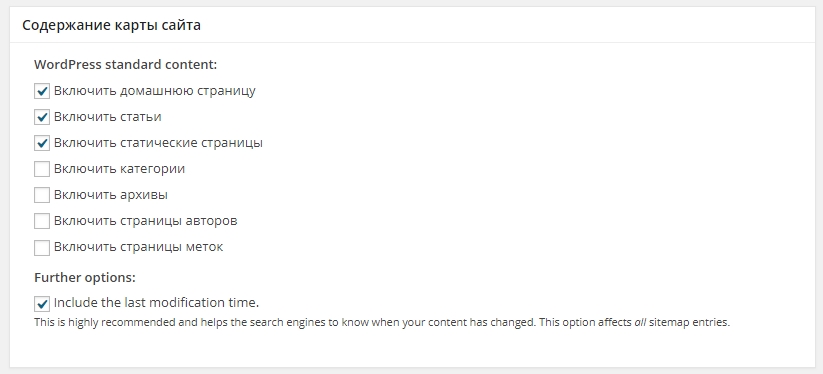

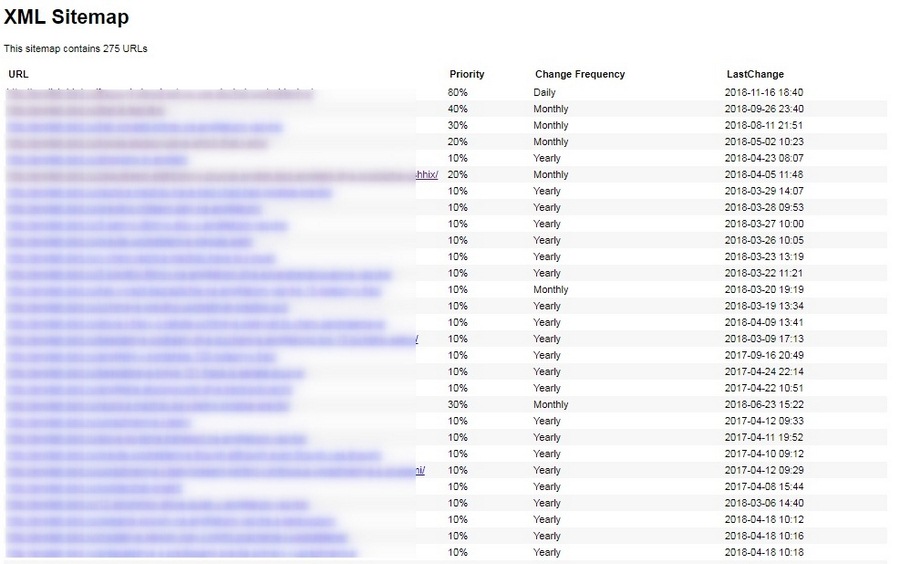

Файл sitemap.xml можно сгенерировать автоматически с помощью специализированных онлайн-сервисов. Например, Gensitemap (рус) и XML-Sitemaps (англ). У них есть ограничения на количество страниц, поэтому если у вас большой сайт (больше 1000 страниц), за создание карты придется заплатить символическую сумму. Также получить готовый файл можно с помощью плагина. Самый простой и удобный плагин для Wordpress – Google XML Sitemaps. У него довольно много разных настроек, но в них несложно разобраться.

В результате получается простенькая и удобная карта сайта в виде таблички. Причем она становится доступной сразу после активации плагина.

sitemap крайне полезен для индексации, так как зачастую роботы уделяют большое внимание старым страницам и игнорируют новые. Когда есть карта сайта, робот видит, какие страницы изменились, и при обращении к сайту в первую очередь посещает их.

Если вы создали карту сайта при помощи сторонних сервисов, готовый файл необходимо скачать и поместить, как и robots.txt, в папку на хостинге, где расположен сайт. Опять же, в корневой папке: site.ru/sitemap.xml.

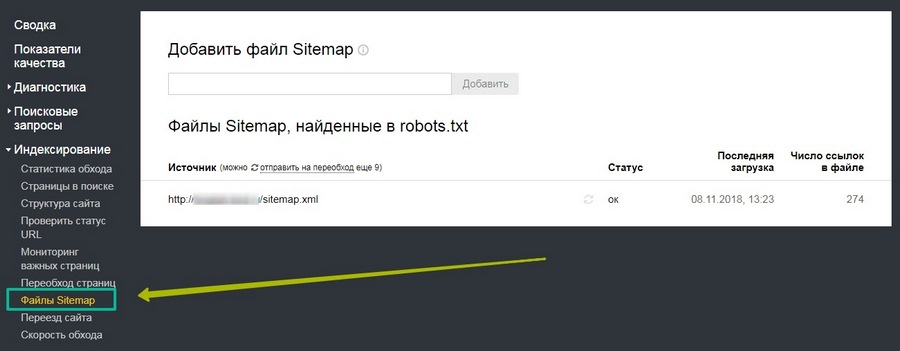

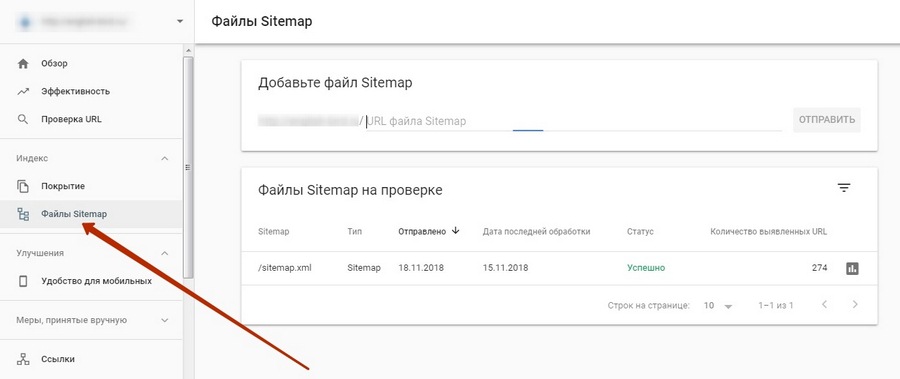

Для удобства желательно загрузить полученный файл в специальный раздел в «Яндекс.Вебмастере» и Google Search Console.

В старой версии инструмент немного отличается.

В «Яндекс.Вебмастере» проверить содержимое карты сайта на наличие ошибок можно в разделе «Инструменты».

Как ускорить индексацию

Поисковые системы рано или поздно узнают о вашем сайте, даже если вы ничего для этого не сделаете. Но вы наверняка хотите получать клиентов и посетителей как можно раньше, а не через месяцы, поэтому затягивать с индексацией – себе в убыток.

Регулярное быстрое индексирование необходимо не только новым, но и действующим сайтам – для своевременного обновления данных в поиске. Представьте, что вы решили оптимизировать старые непривлекательные заголовки и сниппеты, чтобы повысить CTR в выдаче. Если ждать, пока робот сам переиндексирует все страницы, можно потерять кучу потенциальных клиентов.

Вот еще несколько причин, чтобы как можно быстрее «скормить» роботам новые странички:

- На сайте публикуется контент, быстро теряющий актуальность. Если сегодняшняя новость проиндексируется и попадет в выдачу через неделю, какой от нее толк?

- О сайте узнали мошенники и следят за обновлениями быстрее любого робота: как только у вас публикуется новый материал, они копируют его себе и благополучно попадают на первые позиции благодаря более быстрому индексированию.

- На страницах появляются важные изменения. К примеру, у вас изменились цены или ассортимент, а в поиске показываются старые данные. В результате пользователи разочаровываются, растет показатель отказов, а сайт рискует опуститься в поисковой выдаче.

Ускорение индексации – работа комплексная. Каких-то конкретных способов здесь нет, так как каждый сайт индивидуален (как и серверы, на которых они расположены). Но можно воспользоваться общими рекомендациями, которые, как правило, позитивно сказываются на скорости индексирования.

Перечислим кратко, что можно сделать, чтобы сайт индексировался быстрее:

- Указать роботам, что индексировать и что не индексировать. Про robots.txt, карту сайтаи все их преимущества мы уже говорили. Если файлы будут составлены правильно, боты быстрее справятся со свалившимся на них объемом новой информации.

- Зарегистрироваться в «Яндекс.Вебмастере» и Google Search Console. Там вы сможете не только заявить о новом сайте, но и получить доступ к важным инструментам и аналитике.

- Обратить внимание на сам сайт. Чтобы роботу (как и пользователям) проще было ориентироваться на сайте, у него должна быть понятная и простая структура и удобная навигация. Сюда же можно отнести грамотную перелинковку, которая может помочь в передвижении по сайту и обнаружении важных страниц. Качество контента тоже может повлиять на скорость индексирования, поэтому лучше выкладывать уникальные тексты, несущие пользу.

- Публикуйтесь на внешних площадках. Многие рекомендуют регистрировать сайты в сервисах социальных закладок, каталогах, «прогонять» по «Твиттеру», покупать ссылки и т. д. Мне в свое время это не помогло – новый сайт индексировался месяц. Но вот ссылки с крупных посещаемых ресурсов (где даже может обитать быстробот) действительно могут помочь. О том, как и где публиковаться, у нас было много статей: «Гостевой постинг: как публиковаться, вставлять ссылки и не платить за это», «Внешний контент-маркетинг: зачем, о чем и куда писать», гайд по линкбилдингу.

- Обновляйте сайт чаще. Если на сайте месяцами не публикуются новые материалы, робот меняет тактику и заходит на сайт реже.

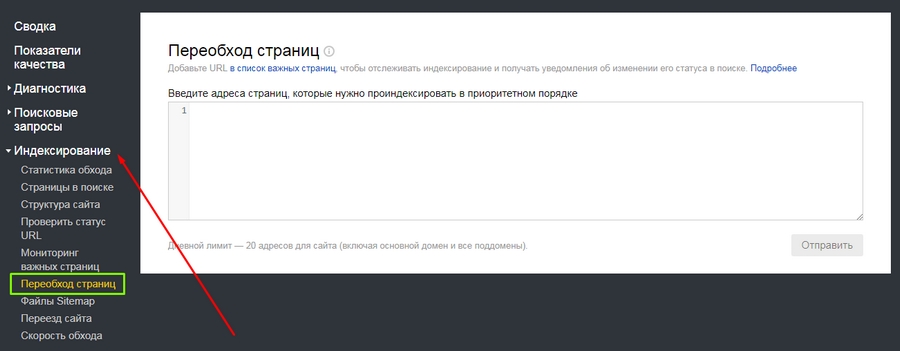

Еще в панелях «Яндекс.Вебмастера» и Google Search Console можно отправлять роботов на конкретные страницы.

Обратите внимание на то, что отдельные адреса можно добавить в важные, чтобы потом отслеживать их индексирование.

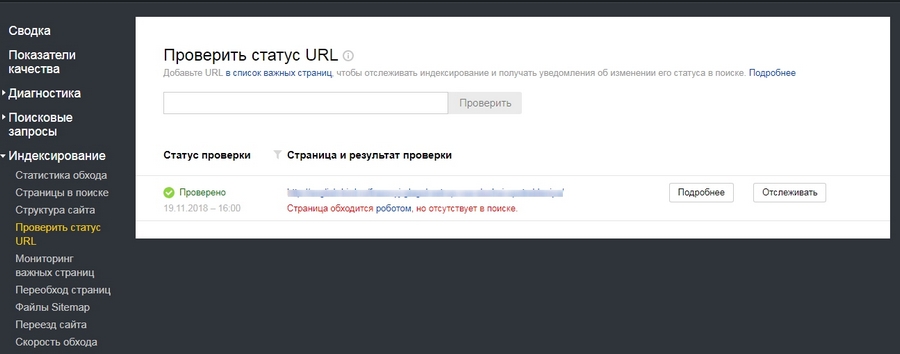

А вот еще одна полезная штука: здесь можно узнать, проиндексирован ли конкретный URL.

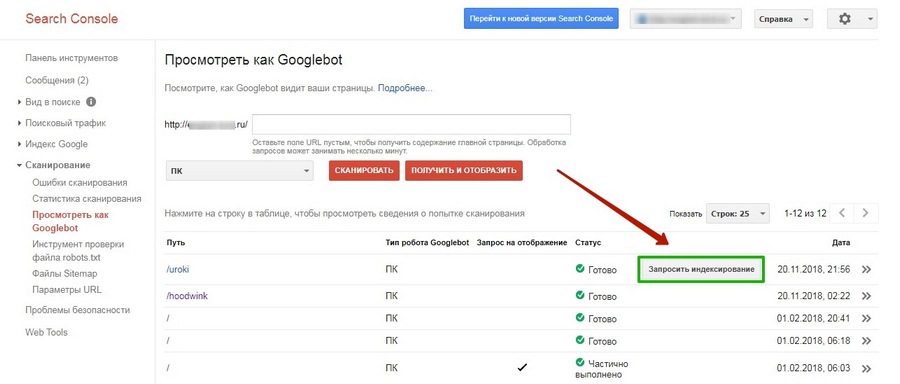

В Google запросить индексирование конкретных страниц можно во вкладке «Посмотреть как Googlebot» (старая версия).

Это, пожалуй, самые основные способы ускорения индексации. Есть и другие, но их эффективность – под вопросом. В большинстве случаев тратить на них время не стоит, если только проиндексировать сайт нужно срочно, и вы готовы испробовать любые способы. В таких случаях лучше читать конкретные кейсы. Например, как проиндексировать сайт в Google в течение 24 часов.

Вывод

Индексация сайта – сложный процесс, с которым поисковые системы далеко не всегда справляются в одиночку. Так как индексирование влияет непосредственно на ранжирование сайта в поисковой выдаче, имеет смысл взять управление в свои руки и максимально упростить работу поисковым роботам. Да, придется повозиться и набить много шишек, но даже такой непредсказуемый зверь как поисковый бот все же может покориться человеку.