Несколько раз в год Google вносит в механизмы ранжирования особенно существенные корректировки. Команда поисковика называет их основными (или масштабными) обновлениями. Сейчас полным ходом идет развертывание очередного Core Update, так что если ваш сайт «трясет» в выдаче – скорее всего, это благодаря апдейту: его уже называют самым серьезным, самым жестким и даже худшим за последние годы.

Что про апдейты (и конкретно про этот) говорят в Google

«Если вы делаете качественный контент и думаете об удобстве пользователя, вам нечего бояться», – примерно так компания комментирует каждое обновление алгоритмов. У вебмастеров, как правило, на этих словах начинает дергаться глаз: специалисты знают, что не все так однозначно.

Когда Google выпускает апдейт и говорит «Делай что должно – и будь что будет»

Краткий пересказ того, как в Google откомментировали майский Core Update от 2022 года:

«Масштабные обновления [дословный перевод выражения core updates] – это изменения, которые мы вносим, чтобы улучшить поиск в целом и идти в ногу с изменяющейся природой интернета.

О масштабных обновлениях мы объявляем отдельно, потому что обычно они производят заметный эффект. На некоторых сайтах может отмечаться падение или, наоборот, рост, – и люди, чьи сайты «падают», будут искать решение проблемы. Мы хотим убедиться, что они не попытаются исправить то, что исправлять не нужно (а иногда не нужно вообще ничего исправлять).

Отдельные страницы могут работать хуже после обновления – но это не значит, что они нарушают наши правила. Масштабные обновления вообще не имеют отношения к отдельным страницам: мы вводим изменения в саму систему оценки контента. И это приводит к тому, что недооцененные ранее страницы поднимаются в результатах выдачи».

Какие выводы уже сделали вебмастера

Западное SEO-сообщество уже назвало апдейт одним из самых серьезных за последние несколько лет. А от некоторых специалистов даже прозвучало слово «худший»: некоторые вебмастера сообщают о падении трафика на 80 %.

Вот какие промежуточные выводы из разных сообщений можно сделать уже сейчас:

- обновление сильно влияет на выдачу в Google Discover и расширенных сниппетах;

- некоторые сайты YMYL-тематик могут оказаться в выдаче выше, чем правительственные, которым поисковик, как правило, доверяет больше (так уже происходит по данным SEO-директора Path Interactive Лили Рэй);

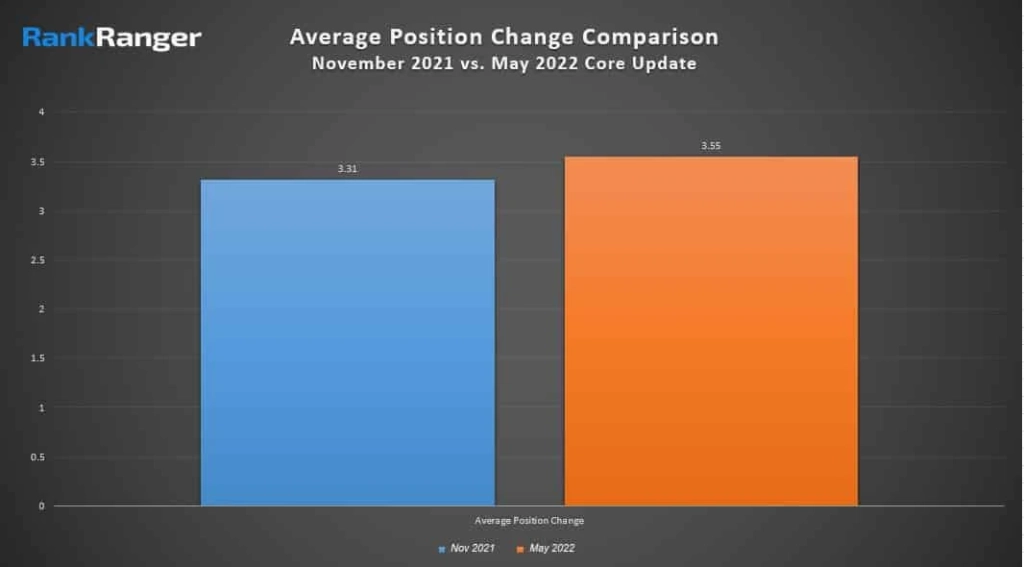

- средние данные по изменениям позиций сайтов выше, чем при ноябрьском обновлении (исследование RankRanger).

Средние данные по изменениям позиций: майское обновление явно более жесткое

Последний пункт означает, что вы даже как пользователь можете заметить странности в выдаче Google: она стала, по выражению западных вебмастеров, «спамной». Надеемся, временно, как это обычно и бывает.

Что происходит на самом деле

Апдейты идут внахлест: быстро вычислить, какой именно на вас повлиял и за счет чего, не так-то просто.

Частенько сайты начинает «трясти» в выдаче еще до того, как Google говорит, что он выкатил обновление. Почему?

Встречается предположение, что реальная выкатка начинается чуть раньше, чем ее анонсируют. Более вероятный вариант – на момент выхода нового Core Update до сайта только-только докатились изменения предыдущего апдейта (если не еще более раннего!). То есть, по факту, развертывание алгоритмов происходит дольше заявленного.

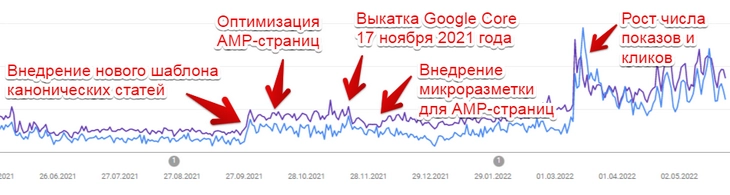

Живой пример – хронология изменений на нашем же сайте.

- В первой декаде октября мы оптимизировали AMP-страницы (перед этим изменился дизайн на сайте, и в AMP тоже нужно было внести изменения).

- В ноябре Google выпустил очередное глобальное обновление. Специалисты Semrush отметили, что «ноябрьский апдейт был “намного более волатильным”, чем июльский <...>: в десктопной выдаче – на 12 %, а в мобильной – на 23 %». То есть изменения были заточены скорее под мобильную выдачу.

- В конце ноября-начале декабря мы внедрили разметку для AMP-страниц.

- Реальные изменения докатились до нашего сайта… 10 марта, когда даже майский апдейт был уже ближе по времени, чем ноябрьский.

Реальные изменения в ранжировании «настигли» сайт только через четыре месяца после апдейта, гипотетически заточенного именно под мобильную выдачу

Это нормальная практика, когда официальное развертывание алгоритма уже завершено, но постепенное закручивание гаек продолжается вплоть до следующего апдейта.

Вывод: SEO не просто не дает мгновенных результатов – все усилия, направленные на оптимизацию, отразятся в выдаче Google позже, чем в выдаче «Яндекса». Хорошая новость – эти результаты надежные: трафик они приносят стабильно сразу же после того, как устаканились.

Часть механизмов ранжирования – черный ящик для самих сотрудников Google

Google – машина умная и давно учится сама. Поэтому когда сотрудники компании разводят руками и говорят «просто думайте о пользователе и молитесь все будет хорошо», они делают это искренне.

Конечно, сотрудники Google представляют, какую информацию они «скормили» искусственному интеллекту для обучения. Это данные от асессоров – живых людей, которые тестируют сайты; на основе их оценок обучается Google machine learning. Но заранее сказать, как это отразится на ранжировании и какие именно сайты и страницы упадут в выдаче, все равно нельзя.

Апдейт Google глазами вебмастера. Вроде и знаешь, что все к лучшему – но каждый раз страшно

Как устоять перед лицом глобального Core Update

Рекомендация «делать хорошее и не делать плохого» – это такая себе помощь вебмастеру.

Невозможно одним днем актуализировать весь контент на сайте, в один присест конвертировать все изображения в самый современный формат и одним кликом исправить все ошибки (а они неизбежно появляются в ходе работы над ресурсом). Хорошо бы – но невозможно. Поэтому вебмастерам и владельцам справедливо хочется знать, за что хвататься здесь и сейчас, с выходом очередного глобального обновления: за мобилку, микроразметку, скорость загрузки или еще что-то.

Да, котик, мы стараемся…

В реальности здесь работает только одно – коллективный опыт. Если у вас один сайт, да еще со скоростью обновления не повезло, да еще нет дневника обновлений с четкими датами, когда и что было сделано, – вы будете три-четыре месяца сидеть как на иголках. И правильно ли вы «угадали», чего там поисковику понадобилось на этот раз, вы узнаете нескоро.

Что делать? Есть два варианта.

Мониторинг изысканий других вебмастеров

Таким образом мы, например, вычислили примерное количество материалов, которое нужно обновлять на сайте.

В 2020 году поисковик анонсировал набор факторов E-A-T (expertise, authoritativeness, trustworthiness – экспертность, авторитет и достоверность). А достоверность для Google – это в том числе и актуальность.

На нашем сайте продолжают ежедневно набирать трафик статьи трех-, а иногда четырехлетней давности (в отдельных случаях – и более старые), при этом зачастую информацию там уже неплохо бы обновить. Сделать это сразу для всех материалов – нереально, так как сейчас на сайте почти 4 000 статей, из которых примерно четверть все еще пользуется спросом. Остальное – ситуативки и совсем устаревший контент, который уже никак не актуализировать.

Как понять, с какой скоростью обновлять материалы? Мы взяли несколько исследований на предмет того, какие контентные сайты (это важно! – ресурсы надо сравнивать с похожими) просели или взлетели в выдаче. Авторы провели кропотливую работу, выявив примерный процент обновлений в каждом отдельном случае. Нам осталось только найти среднее арифметическое от цифр из изысканий, пересчитать проценты в реальное количество статей и сделать вывод – в год нам нужно актуализировать примерно семь-восемь сотен материалов.

Дальше – дело техники.

Мы выявили самые трафиковые материалы, раздали их внутренним специалистам на проверку и начали процесс обновления.

Самые вечнозеленые материалы, где нужно просто проверить работоспособность ссылок, сменить изображения на «облегченный» формат webp, пометить запрещенные ныне организации и сделать другие косметические правки, обновляются на новом шаблоне статьи, но без поднятия на главную страницу сайта и TexTerra Daily, так как добавленной ценности там немного.

Несмотря на то, что дата не меняется, Google все равно замечает изменения и дает странице буст: чаще небольшой, реже взрывной. В сумме это дает прибавку к общему трафику – не грандиозную, но значимую и, главное, стабильную.

Материалы, которые требуют значительных изменений по содержанию, отдаются авторам соответствующей специализации, перерабатываются и выпускаются на TexTerra Daily с новой датой. При этом и роботам, и людям мы даем понять, что это не новый материал, а обновленный:

У обеих дат – и публикации, и обновления – есть соответствующая микроразметка. Раз Google ценит актуализированный контент не меньше свежего, пусть видит, что мы его выпускаем

Как и другие SEO-активности, эта работа редко оказывается «волшебной таблеткой», и здесь речь тоже о ежедневных усилиях. Плюс все тот же: обновления дают хорошую инерцию, то есть стабильный трафик.

Интересный факт: иногда обновленные статьи, как выяснилось, подхватывает «Дзен», – в том числе даже повторно, если когда-то он уже давал им показы. Здесь играет роль сумма роботного и человеческого факторов: алгоритмы предлагают обновленную статью людям, предполагая, что контент может быть все еще актуален, и, если видят активные клики и дочитывания, продолжают давать показы.

Работа сразу с десятками проектов

Это более надежный вариант. Здесь вы не довольствуетесь выкладками незнакомых специалистов, а работаете в окружении нескольких проектных групп, у каждой из которых есть свой пул «подопечных» ресурсов. Так работаем мы в агентстве – и так, очевидно, не может работать вебмастер-одиночка.

Мы смотрим, как каждое обновление влияет на разные проекты, и постепенно становится понятно, где нужно что-то «подкрутить» и как подстроиться под новые реалии.

То есть у агентства, на продвижении у которого находится сразу несколько десятков проектов, есть доступ к своеобразным «большим данным». Это не big data в классическом понимании, конечно, потому что проектов все же не миллион. Но чем больше выборка – тем точнее вывод. Мы можем залезть в историю изменений каждого проекта, посмотреть, что меняли мы, как переоценил ресурс (или конкретную страницу) Google, как это соотносится с датами апдейтов, «тряской» в выдаче других сайтов и так далее. Все, что в моменте работает в «новой гугловской реальности», внедряется на других проектах. Для бизнесов, которые приходят на разработку сайта, соответственно, создаются сайты, которые этой новой реальности отвечают.

Если у вас нет возможности быть в курсе нескольких десятков проектов (как в нашей компании), то всегда есть еще один метод – экспериментальный. Выдвинули гипотезу – проверили на нескольких страницах/разделах – сделали выводы – и при положительном результате распространили на весь сайт.

У нас есть еще один читерский прием – это наш собственный сайт, где мы можем экспериментировать, не согласовывая ничего с клиентом, потому что клиенты здесь мы сами. Удачные SEO-решения с нашего сайта переходят на клиентские и наоборот – мы пользуемся опытом project-менеджеров, которые работают с внешними проектами.

Что имеем в сухом остатке

- Когда специалисты Google говорят, что четких рекомендаций нет, и часть решений поисковика остается в «черном ящике» в том числе для них самих, они не лукавят, дело и правда так обстоит.

- Между апдейтами Google нет четких границ – только постепенное закручивание гаек алгоритмами.

- SEO не может умереть и/или перестать работать: это бесконечное движение в сторону здравого смысла, пользы и удобства. Того, к чему вообще по задумке своей стремится глобальная сеть.

- Рано или поздно хорошая работа по SEO «выстреливает» – и начинает стабильно приносить трафик. Вебмастер может на какое-то время оставить «подкрученные» характеристики сайта в покое и заняться другими… потому что впереди новые апдейты.

- Хорошая работа – это работа, основанная на полных и разносторонних данных. И они, в виде бэкграунда большого количества проектов, чаще всего есть только у команды специалистов, которая одновременно продвигает много бизнесов.

Обсудим продвижение или создание сайта для вас?