Нейросети для написания статей используют и фрилансеры, и корпорации. При этом одни компании приветствуют автоматизацию и экономят на производстве контента, а другие — увольняют сотрудников за генерацию GPT-текстов.Стоит ли бояться ИИ-контента и как с ним работать? Рассказали об этом и не только.

Как изменился рынок контента с появлением ИИ

Контент-маркетинг становится зоной компромиссов: между скоростью и смыслом, экономией и имиджем. Прямо сейчас формируются два главных ИИ-тренда, которые влияют на сегодняшний рынок.

Тренд на удешевление и ускорение производства

ИИ позволяет генерировать десятки текстов в день: статьи, описания товаров, рассылки, посты в соцсетях. Это просто подарок для e-commerce, новостных агрегаторов, контент-агентств — снижаются расходы на авторов и редакторов, увеличивается скорость запуска.

Cкорость становится все более важным преимуществом ньюсмейкеров. В ИТ, где конкуренция выше, чем в среднем по рынку, этот тренд еще заметнее. Мы конкурируем за внимание пользователя с другими ИТ-компаниями, Netflix, Instagram*, TikTok и другими гигантами. Мы стараемся использовать любые инструменты, которые дают преимущество.

Толковый копирайтер стоит от 40 000 рублей в месяц. Даже годовой доступ к ИИ обойдется дешевле*. А если учесть, что ИИ будет использоваться не только для работ с текстом, то окупаемость годового доступа очевидна.

Для нас ИИ — это выход на новые скорости. Я, как редактор с опытом более 15 лет, могу написать любой нужный нам текст. Но вопрос в том, насколько это рациональное использование моего рабочего времени: потратить час на написание текста или на подготовку структуры лендинга с ТЗ для дизайнера — что выгоднее?

*Примечание редакции: подписка ChatGPT на месяц стоит от 20 долларов — на момент публикации статьи это около 1 600 рублей.

Тренд на снижение уникальности и качества

ИИ-оптимизация контента несет определенные риски: тексты могут терять смысл, стиль, индивидуальность. Статья, подготовленная с помощью нейросети, может быть довольно связной, но поверхностной — особенно если не уметь составлять промпты. Теряется контроль над тоном, глубиной, достоверностью, а значит, и над восприятием бренда.

ИИ не отличает важное от второстепенного, не чувствует стиля и не уточняет факты. Тексты от нейросети обычно читаются легко, но не убеждают и что еще хуже — снижают доверие к бренду.

Почему компании боятся ИИ-контента

Несмотря на очевидные выгоды, многие бизнесы относятся к ИИ с настороженностью или даже категорически запрещают его использовать. На это есть несколько причин.

- Нарушение договоренностей

Если компания заказывает текст, написанный человеком, а получает сгенерированный вариант — это обман. Заказчик не всегда может распознать подмену, но если такое случается, возникают сомнения в порядочности автора: а вдруг нас обманывают в чем-то еще?

- Потеря доверия к бренду

Когда читатели замечают неестественный стиль или бессмысленные фразы, у них ожидаемо снижается вовлеченность и лояльность. Особенно важно следить за этим брендам, которые через тексты строят отношения с аудиторией, например, образовательным проектам, СМИ, IT-компаниям.

Мы много пишем о здоровье, а в этой сфере отказ от ИИ в пользу экспертного контента — несомненный плюс. Сегодня многие идут в ChatGPT вместо поликлиники, вплоть до того, что просят нейросеть расшифровать анализы или посоветовать лекарство. А ведь это может быть опасно — ИИ периодически выдумывает информацию.

В 2024 году в журнале Гарвардской школы Кеннеди Misinformation Review были опубликованы данные о присутствии в академической поисковой системе Google Scholar фальшивых научных статей, сгенерированных нейросетью. Это вызвало волну критики и обсуждений этики публикаций, созданных с использованием искусственного интеллекта. Эксперты отмечали, что значительная часть заимствований сложно выявляется стандартными инструментами.

Однажды нам пришла идея добавить в контент-план статью о самых известных киберпреступниках. Прямой поиск в сети выдавал исключительно экономические преступления и кибератаки, про которые мы уже писали.

Я решила обратиться за информацией к GPT и получила отличный список цифровых мошенников, который идеально подходил идее.

Стоит ли говорить, что все они были выдуманы нейросетью? Эта статья в итоге так и не вышла, а мы получили полезный опыт работы с ИИ — всю информацию нужно проверять.

- Риски внутри команды

Если в компании нет прозрачной политики по работе с ИИ, руководитель оказывается между двух огней.

Часть его сотрудников точно создает контент в нейросетях, только скрытно, опасаясь возможных санкций. Возникают вопросы: считать ли такую работу добросовестной, нужно ли снижать оплату, как проверять результат?

Другие работают по старинке, возмущаясь успехам коллег, ведь они тратят меньше времени, а получают столько же. И снова вопросы: так ли хороши те, кто работает вручную, как относиться к тому, что они не развиваются, не стремятся к новому?

Своим мнением делится Ольга Михайлина, эксперт по контенту в luxury e-commerce и управляющий партнер ивент-агентства AllAltai Agency:

— Бизнес, который запрещает использовать ИИ в работе с текстами, обманывает сам себя. Копирайтер будет продолжать рассказывать вам, что делает все вручную. Но при этом будет пользоваться нейросетями.

А дальше вопрос в профессионализме копирайтера. Ленивый и бездарный будет просто кидать вам тексты от нейросети. Толковый будет использовать ИИ, чтобы оптимизировать время и увеличить свою эффективность. Но вам будет рассказывать, что на этот шедевр он потратил двое суток без сна и перерыва на кофе.

Дальновидный бизнес захочет использовать такого копирайтера, подключая его на другие задачи. И вот он уже не копирайтер, который пишет посты в соцсеть, а Head of Content. Все в выигрыше: автору — профессиональный рост в нейрокопирайтинге, бизнесу — оптимизация и эффективность процессов, связанных с контентом.

А мы даже на работу принимаем с учетом этого — использует ли соискатель ИИ. На этапе отбора кандидатов задаем вопрос: «Пользуетесь ли вы нейросетями в своей работе?».

Отрицательный ответ, даже если резюме впечатляет, скорее всего, станет причиной отказаться от сотрудничества. Наличие навыка базового взаимодействия с ИИ в 2025 году — это не просто «плюс» в портфолио, а уже обязательный стандарт профессиональной компетентности.

Аргументы за и против ИИ-контента

Итак, ИИ все чаще признается удобным инструментом для работы с текстами, хотя и вызывает много споров. Поэтому, прежде чем решать, насколько серьезно вы будете его использовать, стоит понять, чего больше в вашем случае — рисков или выгод.

Аргументы за

- Автоматизация рутины. ИИ быстро справляется с шаблонными задачами: описания товаров, подборки, инструкции, посты, если в чат с нейросетью уже загружены инструкции по ToV.

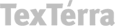

Как создавать контент с помощью нейросети: для генерации текстов в нужной тональности в ChatGPT загружается пример стиля, интонации и принципы подачи материала

- Высвобождение ресурсов. У авторов и редакторов появляется время на аналитику, генерацию новых идей, разработку стратегии.

Наш отдел маркетинга стал генерировать не десятки, а сотни креативов каждый месяц с помощью нейросетей и инструментов вайб-маркетинга.

Благодаря нейрокопирайтеру наш блог стабильно экономит около 1 млн рублей в месяц, а на прошлой неделе мы приступили к полному автоматическому генерированию SEO-статей без ручного вмешательства.

По внутренним расчетам, каждый департамент экономит в среднем 25-30% времени и столько же бюджета, используя комплекс ИИ-агентов и специализированных нейросетевых решений.

- Универсальность технологии. ИИ можно подключить на любом этапе создания контента — от идеи и структуры до создания черновиков и адаптации под разные форматы.

Аргументы против

- Снижение качества. Тексты от нейросети могут быть похожими, без экспертизы и глубины. Такой пример мы рассмотрим в следующем разделе.

- Риск плагиата. Генеративные модели часто заимствуют чужие формулировки. Так, The New York Times в США обвинил ChatGPT в выдаче почти дословных фрагментов своих материалов без указания авторства.

- Неочевидные затраты. Сэкономив на создании контента, компании могут потратить больше на доработку и редактуру.

Мы пробовали использовать ИИ-контент, но отказались от него.

Во-первых, качество текста оставляет желать лучшего. Редактировать текст, который написал ИИ, все равно что пытаться редактировать текст копирайтера с биржи за 200 рублей — времени уходит больше, чем на написание с нуля.

Во-вторых, ИИ-тексты практически не индексировались. Говорят, что поисковики не борются с контентом, созданным нейросетями, но по какой-то причине эти тексты либо не индексировались вовсе, либо делали это, скажем так, странно: на статьи переходили по запросам, даже близко не связанным с темой статьи.

Как распознать сгенерированный текст

Сегодня ИИ-тексты уже не выглядят набором случайных слов, но у них по-прежнему есть узнаваемые признаки. Такие ИИ-маркеры пригодятся, если вы часто работаете с внешним контентом и не знаете, как понять, что текст сгенерирован.

Признаки:

- повторяемость одних и тех же мыслей;

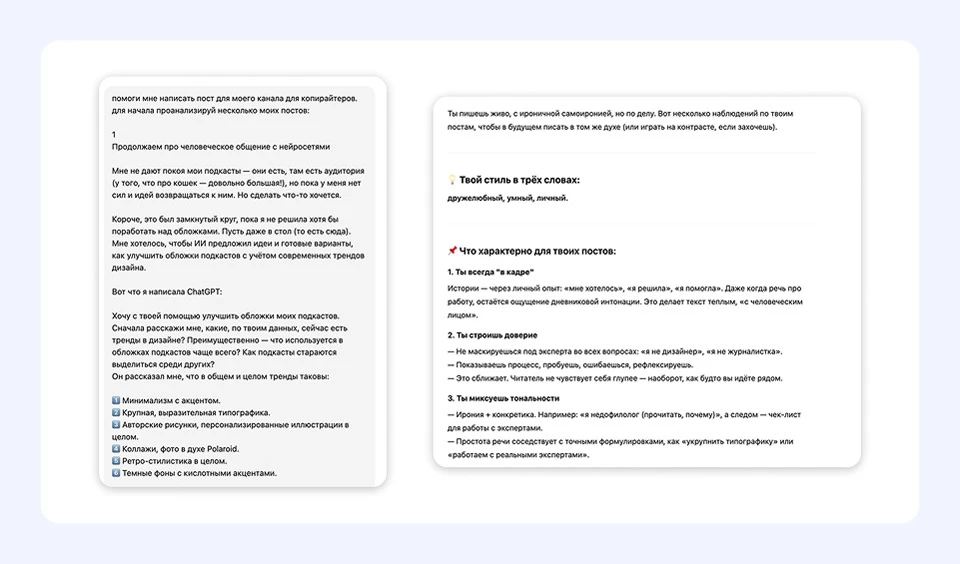

- пафос и парцелляция — короткие отрывистые фразы для выделения интонации — почти как в художественной литературе;

- много общих фраз, избегание конкретики;

- нестыковки в логике, особенно в длинных текстах — текст может начинаться с одной мысли, а заканчиваться другой.

Характерные признаки генерации текста с помощью ИИ: короткие пафосные фразы, повтор одних и тех же мыслей, отсутствие конкретики. На первый взгляд выглядит убедительно, но по сути не сказано почти ничего

Кроме перечисленного, в ИИ-текстах часто повторяются такие речевые шаблоны:

- это не просто …, а …;

- не только …, но и …;

- как …, так и …;

- это особенно важно (критично) для…;

- будь то;

- такие как;

- включая;

- это позволяет / обеспечивает / гарантирует.

Как проверить на ИИ готовую статью с помощью… самого ИИ

Сегодня есть десятки сервисов, которые, по словам их создателей, умеют выявлять ИИ-контент — к слову, все они тоже работают на базе ИИ.

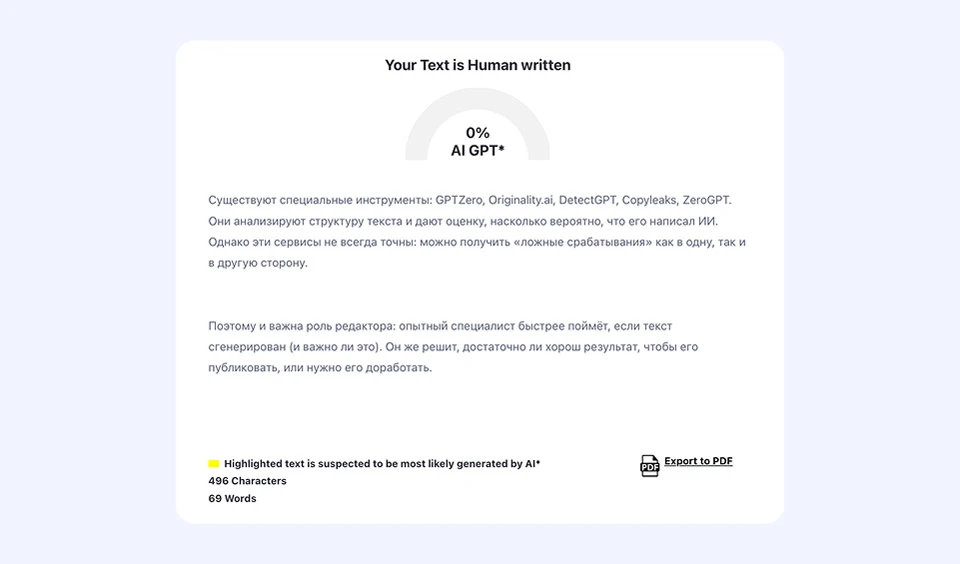

Чтобы понять, насколько достоверны выводы таких детекторов, проведем эксперимент. Сгенерируем небольшой фрагмент текста:

«Существуют специальные инструменты для определения ИИ-контента: GPTZero, Originality.ai, DetectGPT, ZeroGPT. Они анализируют структуру текста и дают оценку, насколько вероятно, что его написал ИИ. Однако эти сервисы не всегда точны: можно получить «ложные срабатывания» как в одну, так и в другую сторону.

Поэтому и важна роль редактора: опытный специалист быстрее поймёт, если текст сгенерирован (и важно ли это). Он же решит, достаточно ли хорош результат, чтобы его публиковать, или нужно его доработать».

Посмотрим, что ZeroGPT скажет про этот текст:

Сервис ZeroGPT показал, что проверяемый фрагмент написан человеком — полагаться на такие инструменты пока рано

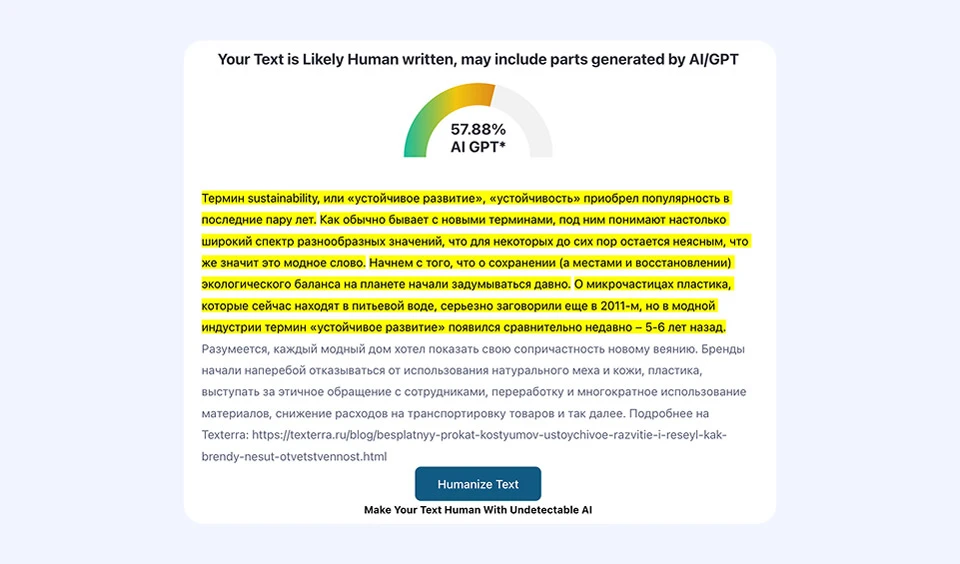

Теперь возьмем настоящий человеческий текст:

Это фрагмент текста, написанный вручную в 2021 году, когда нейросети еще не умели писать связно и не использовались в массовой работе с контентом. Однако ИИ-детектор посчитал текст сгенерированным

Согласимся с тезисом, который сгенерировал ChatGPT для нашего эксперимента: в производстве ИИ-контента очень важна роль редактора. Опытный специалист всегда заметит, где отсутствуют нужные смыслы и не хватает конкретики.

Стратегический подход к ИИ-контенту

Первые шаги к ИИ-политике в компании — определить, когда применение нейросетей допустимо, а когда — нет, кто несет ответственность и как проверяется результат.

Шаг 1. Ответьте на вопросы

- В каких задачах с помощью ИИ можно сэкономить ресурсы, не потеряв в качестве?

- Готова ли ваша команда работать с новыми инструментами?

- Что для вас важнее и почему — скорость или глубина погружения в тему, массовость или индивидуальный подход к каждой единице контента?

Шаг 2. Разделите зоны ответственности

Нужны четкие правила: допустимо ли использование ИИ, на каких этапах, с каким уровнем проверки. Например, можно использовать ИИ для оформления текста и адаптации под разные форматы, нельзя — для сбора фактуры.

Использование нейросетей может быть уместно для черновиков, служебных заметок, подборок, но не для экспертных материалов или креативных концепций. Используйте ИИ как ассистента для сотрудников, но не передавайте ему всю работу с идеями и смыслами.

Мы обучаем сотрудников вопросам безопасности данных: какие данные можно передавать ИИ, а какие — нет.

Сейчас мы разрабатываем внутреннюю платформу, чтобы упростить работу с ИИ, собрать все инструменты в одном окне и сделать администрирование аккаунтов более прозрачным.

Шаг 3. Договоритесь с подрядчиками

Если вы работаете с подрядчиками или внутри команды, заранее договоритесь, можно ли использовать ИИ, на каких условиях и кто отвечает за результат, чтобы не было неприятных неожиданностей. Настройте процесс так, чтобы каждый текст проходил человеческую проверку — на смысл, стиль и соответствие задаче.

TexTerra знает, как сочетать технологии и редакторскую экспертизу, чтобы контент работал на бренд. Напишите нам в Телеграм или на почту — обсудим задачу и предложим решение.

Читайте также:

Как получать лиды из ChatGPT и других нейросетей — подробный гайд «Текстерры»

10+ нейросетей для работы с контентом в 2025 году

*Instagram принадлежат Meta, которая признана экстремистской организацией и запрещена на территории РФ