О, вам это понравится! Особенно перспективы, которые мы обозначили в конце этой статьи. Но обо всем по порядку.

На днях голосовая помощница Яндекса «Алиса» описала суть известного мультфильма «Маша и Медведь» в духе какого-то японского аниме. Маша живет одна, так как:

«Она всего лишь призрак убитой девочки, именно поэтому она не растет, и видеть ее могут только животные. Родители же не смогли выдержать потери ребенка и уехали, оставив пустой дом. А мучает Маша Медведя потому, что он и лишил ее жизни».

Такой ответ «Алисы» встревожил уполномоченного по правам ребенка в Санкт-Петербурге Анну Митянину. Выступая в парламенте, она указала на то, что технологии искусственного интеллекта могут негативно влиять на психику и развитие детей.

Действительно: те, кто работает с нейросетями, знают, что выдаваемую ими информацию нужно проверять. Проще говоря, искусственный интеллект может выдумывать то, чего не было.

Дарья Капитонова, SMM-маркетолог TexTerra, специалист по нейросетям:

— Нейросети – это хороший инструмент, который может сэкономить немало времени и усилий. Однако он не может заменить критическое мышление человека и способность формировать собственные суждения. К ответам ИИ очень важно относиться с осторожностью, особенно по темам, требующим экспертных знаний. Не стоит слепо полагаться на алгоритмы, а полученные результаты, содержащие факты, имеет смысл перепроверять. Причиной ошибок, по «словам» самих нейросетей может быть следующее:

Но в Яндексе уже заявили, что рассказ про «Машу и Медведя» – единичный случай со стороны «Алисы», и проблема уже устранена.

«"Алиса" в единичных случаях могла ответить некорректно на вопрос o семье главной героини мультфильма "Маша и Медведь". В данный момент она больше так не отвечает. Мы всегда рекомендуем активировать детский режим при общении с "Алисой", чтобы оградить ребенка от нежелательного контента», — цитирует РИА «Новости» объяснение «Яндекса».

Почему нейросети врут

Но зачем врать и выдумывать, спросят некоторые. Нейросети не выдумывают, а берут информацию из открытых источников и, судя по всему, надежность этих источников не всегда им корректно оценивается. Например, кто-то пошутил про мультик на каком-нибудь форуме, а на выходе – доклад уполномоченного по правам ребенка в парламенте. На деле же «Алиса», вероятно (это только наша догадка), подсмотрела сюжет одной из серий аниме «Секрет Машуко», где тоже есть Маша и Медведь, а также Машуко (робот-заяц). Или другое аниме.

«Для части вопросов, на которые "Алиса" не может ответить сама, она берет информацию из открытых источников», – подтвердили в компании.

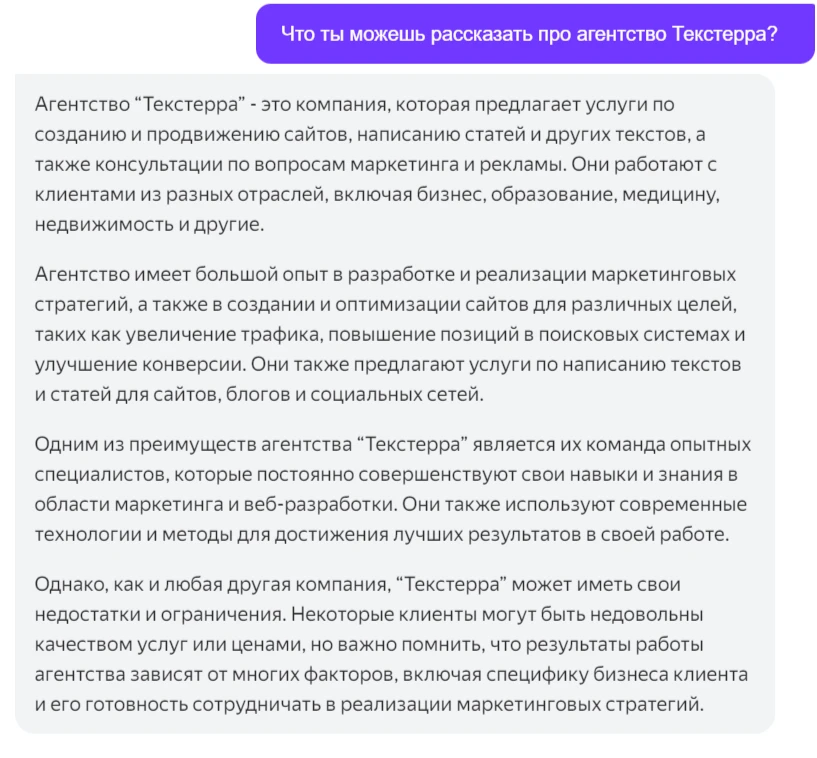

В случае TexTerra тоже есть сбои. Несмотря на уникальное название и множество информации о нас в открытом доступе, некоторые нейросети (в данном случае – GroqChat) не прочь пофантазировать:

Другие (Claude) признаются, что ничего о нас не знают:

А третьи (YandexGPT) пишут все как есть и весьма корректно:

Корректность ответов нейросетей – в ваших руках

Случай с «Алисой» – не единичный. Бизнес уже озаботился тем, что искусственный интеллект, отвечая на запросы (промпты) пользователей, порой искажает действительность и может очернять бренды.

Все больше компаний начинают проверять, как их описывают нейросети – чат-боты, такие как ChatGPT, Bard, Perplexity и прочие.

Исполнительный директор компании цифрового маркетинга Jellyfish Джек Смит объясняет, что упоминание брендов происходит без отрыва от слов и фраз, вместе с которыми они встречаются в интернете. Например, вместе с названием лосьона нейросеть может применить слово «нежный».

Если языковая модель (нейросеть) не может связать с продуктом определенный термин или связывает с ним негативные слова, то это происходит лишь потому, что подобное сочетание уже есть где-то в сети (или же никаких сочетаний найдено не было).

Компании не могут изменить то, что нейросети уже «знают» об их брендах. Но могут создавать новый контент и публиковать его. Тогда нейросети, которые постоянно обучаются, со временем начнут менять свои ответы.

«Для поиска ответов нейросети по умолчанию подключаются к открытой сети, они будут поглощать все больше и больше актуального и свежего контента», — говорит мне Смит.

Свежими могут оказаться и негативные отзывы о компании.

«Это почти как поисковая оптимизация, и здесь весело, потому что надо понять, какой тип контента окажет наибольшее влияние на "мнение" нейросети о компании», — говорит Смит.

При этом Смит указывает на то, что формат видео становится все более значимым для самообучения нейросетей – набор типов данных для обучения постоянно расширяется. То есть, помимо текстов нейросети уже учатся на аудио и видео, отследить негатив в которых сложнее, чем в текстах. А на очереди – сбор информации через микрофоны смартфонов и их видеокамеры.

Именно поэтому ChatGPT (версия 3.5) уже не требует от пользователей даже элементарной авторизации – это позволяет собирать информацию, так как в анонимном режиме она не является личными данными. Проще говоря, отменив регистрацию, OpenAI устранил барьер для сбора обучающих данных. Однако в компании отмечают, что пользователи могут отказаться от использования их разговоров в целях обучения нейросети.

И тут компании уже никак не смогут контролировать, что нейросети будут выдавать про их бренды. Например, кто-нибудь будет ругать принтер HP за плохую печать, и все это попадет в ответы нейросетей. Или в объективе камеры окажется кривой стол из Ikea, дымящий автомобиль, кривой зонт и так далее. Тогда компаниям останется только работать на совесть и надеяться на лучшее.

Читайте также:

Лучшая нейросеть на русском для изображений

Gemini от Google – самый мощный конкурент ChatGPT [обновлено]