Специалист по поисковой оптимизации Google Мартин Сплитт заявил, что дублированный контент, конечно, создает операционные проблемы, но не снижает рейтинг сайта.

Действительно, дублированный контент нельзя назвать таким уж вредным, но он замедляет сканирование сайта, затрудняет отслеживание эффективности страниц и создает конкуренцию между похожими фрагментами контента. Но у всех этих зол есть решения. Вот что советует сам Google (далее мы дадим вам советы практикующих SEO-специалистов).

1. Используйте канонические теги

Мартин Сплитт рекомендует использовать канонические теги в HTML-коде или заголовках HTTP-страниц, чтобы указать предпочтительные URL-адреса для задублированного контента. Правда робот Google рассматривает их скорее как рекомендации, чем как директивы. Но они помогают поисковой системе принимать решения об индексации.

«Владельцы сайтов часто неправильно используют эти теги, поэтому поиск Google не может полагаться на них полностью, и рассматривает их как подсказки, но все равно может выбрать другой URL», – поясняет Мартин Сплитт.

2. Внутренние ссылки и переадресация

Если канонические теги не повлияли на выбор робота Google, то необходимо:

-

проверить и обновить внутренние ссылки, чтобы они указывали на предпочтительные вами URL,

-

рассмотреть возможность внедрения 301-го редиректа для переадрсации внешних ссылок,

-

убедиться, что переадресация настроена правильно.

3. Объединяйте похожий контент

Объединение похожих страниц в одну приведет к:

-

улучшению взаимодействия с пользователями,

-

оптимизации отчетов Search Console,

-

облегчит сайт.

«Если вы обнаружите, что у вас есть несколько очень похожих страниц, даже если Google не считает их дубликатами, попробуйте объединить их. Это упростит поиск информации для ваших пользователей, упростит работу с отчетами в Google Search Console и уменьшит беспорядок на вашем сайте».

Google Search Console может помечать страницы с одинаковым контентом по-разному:

-

«Дублирование без выбранного пользователем канонического тега» (Duplicate without user-selected canonical),

-

«Альтернативная страница с правильным каноническим тегом» (Alternate page with proper canonical tag),

-

«Google выбрал другой канонический тег, чем пользователь» (Duplicate Google chose different canonical than user).

Эти уведомления указывают на то, что Google проиндексировал контент, возможно, на других страницах вашего сайта, а не на тех, где предполагали вы.

Кстати схожий контент на нескольких языках допустим и корректно обрабатывается системами Google.

Но практика и наблюдения показывают, что не все так просто и безоблачно.

В чем опасность дублированного контента

Здесь можно назвать целый ряд неприятных последствий. Среди них:

- высокий риск пессимизации одной страницы и целого домена;

- затруднение при индексировании новых страниц сайта;

- проблемы с внешними URL;

- утрата позиций в SERP;

- дубли в результатах поиска – нередки случаи, когда дублирующая страница полностью замещает оригинал и встает на его место в SERP.

Неявные дубли могут стать причиной снижения общей уникальности текста на странице. Особенно это характерно для широко тиражируемого контента, например – новостей.

Не следите за дублями? Значит, можно ожидать дополнительных сложностей при SEO-оптимизации выбранных страниц, ведь «Яндексу» и Google становится сложно выявить наиболее подходящую по смыслу (релевантную) страницу по отношению к ключевой фразе.

При отсутствии контроля за дублями, создаются дополнительные временные затраты при переобходе всех страниц. Дело в том, что у каждого краулера существует определенный лимит запросов к вашему домену. Вполне реальны случаи, когда краулер тратит все лимиты при обходе мусорных страниц, а до страниц с оригинальным контентом так и не добирается.

Что такое дубли

Дублями называют умышленно или случайно дублируемый на сайте контент. Дублем справедливо называть абсолютно любой повторяющийся (только на различающихся URL) контент. Естественно, речь о повторах на одном домене.

Почему появляются дубли

Самые частые причины дублирования контента:

- Не настроено перенаправление.

- Пагинационные страницы.

- Слэш (как отсутствие, так и присутствие) в конце ссылок.

- Карточки похожих товаров.

- Особенности CMS.

Самая главная причина – это техническое несовершенство абсолютно всех CMS, которые автоматически генерят дубли во множестве ситуаций. Самый частый случай – соотнесение одной веб-страницы одновременно с двумя (и более, соответственно) рубриками на сайте.

Так могут выглядеть дубли, создаваемые системой управления контентом:

- texterra.ru/contacts1/info/

- texterra.ru/contacts2/info

Именно сама CMS представляет наибольшую опасность, когда мы говорим об автогенерации URL и возникающим дублировании контента.

Дублями очень часто грешат и плагины для CMS, особенно – плагины для WordPress. Когда мы говорим о дублях в технических разделах сайта, то наиболее часто портачит Joomla и всеми любимый Bitrix. Указанные CMS автоматически создают ссылки, включающие специальные параметры. Особенно часто дубли формируются при регистрации, использовании поиска на сайте, фильтровании товаров, кастомизации карточек товаров, сортировке, пагинации.

Выглядят параметрические URL следующим образом:

- texterra.ru/info.php

- texterra.ru/info.php?ajax=X

Многие CMS также грешат зацикливанием URL, которое происходит автоматически. Большое количество таких ссылок затрудняет работу краулеров и негативно сказывается на индексации домена.

Вторая самая частая причина появления дублей – некорректные записи в системном файле robots.txt и ошибки в нем же.

Третья – некорректная настройка 301-го перенаправления.

Как найти дубли на своем сайте

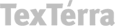

Для выявления дублированного контента на своих сайтах, я использую несколько инструментов. Вообще искать можно и вручную, но, если страниц много, то этот вариант трудно исполним. Гораздо легче находить дубли при помощи специализированных сервисов, таких как NetPeak Spider. Достаточно ввести домен в поисковой строке и выбрать пункт «Найти». Предварительно, откройте раздел с параметрами и отметьте следующие чекбоксы:

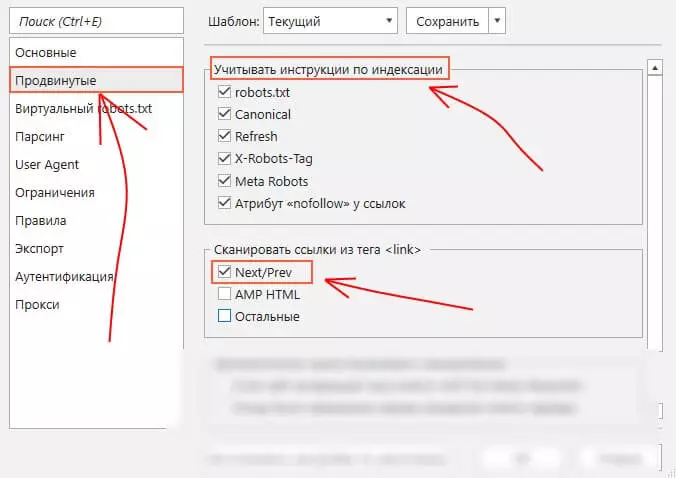

Теперь указываем домен своего сайта и выбираем пункт «Старт». После того как сканирование будет завершено, выбираем «Отфильтрованные результаты», открываем раздел «Отчеты» и в пункте «Ошибки» находим все интересующие нас дубли: страниц / текста / Title / Description:

Отмечу, что прорабатывать нужно только те дубли, которые отдают 200-ый код.

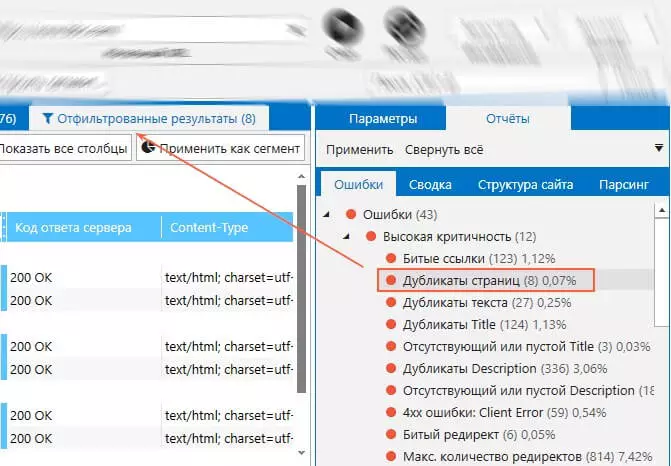

Также для автоматического поиска дублей можно использовать программу Screaming Frog SEO Spider: достаточно указать домен и запустить сканирование. В результатах поиска нужно выбрать пункт URL. Дублирование контента выводится в разделе Duplicate:

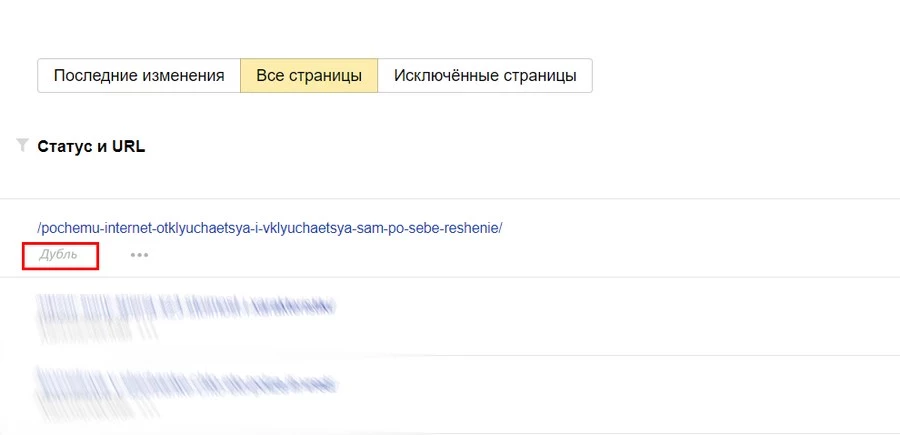

Ну и, конечно, дубли покажет «Яндекс.Вебмастер» и Google Search Console. В первом случае идем в пункт «Страницы в поиске», который находится в разделе «Индексирование». Теперь обращаем внимание на пункт «Статус и URL». Здесь будут отображаться все найденные дубли:

В GSC дублированный контент обнаружить не составит труда. Достаточно открыть раздел «Покрытие». Здесь обращаем внимание на пункт «Сведения» и в поле «Статус» смотрим лист исключенных URL.

Какие дубли встречаются наиболее часто

Все дубли можно усредненно разделить на очевидные и неочевидные. Начнем с последних.

Неочевидные дубли

Этот тип дублированного контента отличается тем, что на разных страницах, он располагается в произвольном порядке (но содержание самого контента остается идентичным).

Итак, мы поняли, что неочевидные дубли представляют из себя страницы с максимально идентичным или полностью повторным контентом. Рассмотрим три самых частых причины появления таких дублей подробнее.

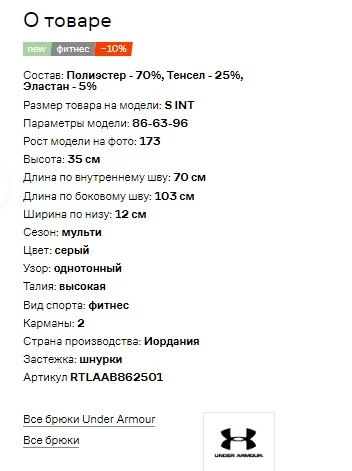

Товары с мало отличающимися / близкими характеристиками

У таких товаров, как правило, описание просто дублируется, либо частично отличается, например, дополнительным словом или небольшим предложением.

Попробую привести наглядный пример: магазин продает одежду, в карточке одного товара появляются вариации – размера или цвета, например. Практически одинаковые или схожие описания для разных товаров – это не очень хорошо:

Одно описание для разных размеров / цветов / вариантов:

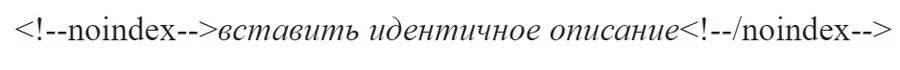

Краулер, с высокой долей вероятности, просто запутается – обойдет первую карточку товара, а схожие (с разными размерами, цветами, материалами) оставит без внимания. Решение простое: все повторяющиеся предложения (на страницах со схожим контентом) просто берем в следующий тег:

Подводные камни такого решения: данный тег учитывает только «Яндекс», кроме этого он не подходит для отличающихся характеристик товара.

Еще один вариант решения проблемы схожих описаний: использовать селектор, чтобы выбирать различные характеристики товара. CSS-селектор определяет с каким именно элементом соотносится выбранное CSS-правило. Предварительно нужно будет сгруппировать все схожие типы товаров, в рамках единой карточки, например, если мы говорим об интернет-магазине.

Третий вариант: все описания схожих предметов нужно сделать максимально уникальным. Если таких карточек слишком много, то начните с тех, которые приносят наиболее высокие конверсии. Например, уникализируйте описания футболок только красного цвета, а зеленые и розовые оставьте на потом, если их не покупают. В общем, правильно расставляйте приоритеты.

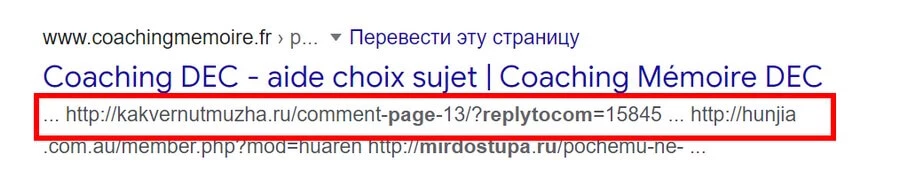

replytocom-комментарии

replytocom – это так называемые дублирующие древовидные комментарии. Отмечу, что данный пункт характерен исключительно для Wordpress-сайтов. Выглядит replytocom следующим образом:

Wordpress, таким образом, заново создает новый URL-адрес при ответе на каждый последующий комментарий на странице. Все это замедляет сайт, а краулеры также не прочь скушать такие URL. Потом такие дубли могут оказаться в SERP. Что делать? Установите Disqus или любой другой сторонний модуль комментариев на свой сайт. Стандартные комментарии в этом случае придется выключить.

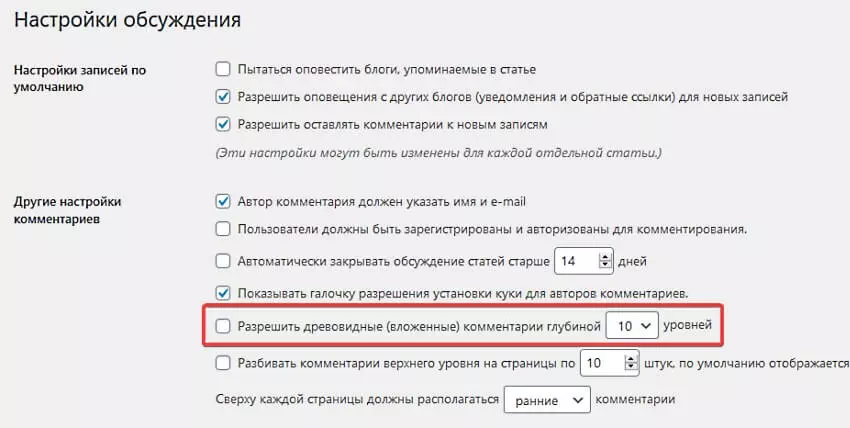

Другой способ решить проблему replytocom: открываем админку WordPress, затем идем в глобальные настройки и в пункте «Обсуждения» снимаем выделение с этого чекбокса:

Если по каким-то соображениям вы не хотите пользоваться сторонними модулями и отключать классические WP-комментарии на своем сайте, то есть варианты и посложнее. Но там уже придется кодить, поэтому описывать их в рамках этого материала не буду.

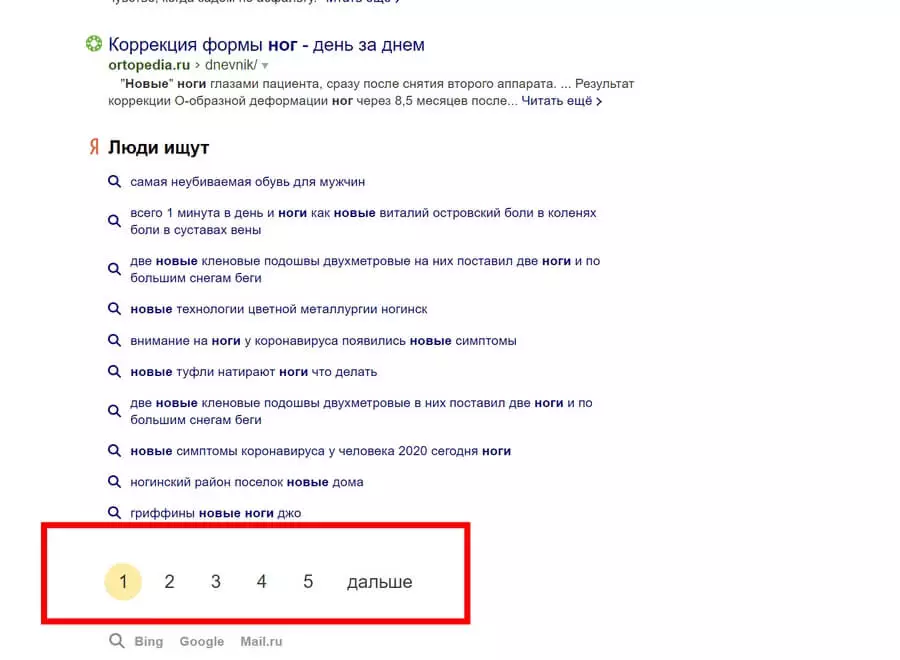

Пагинация

Любой каталог всегда разделяется на несколько страниц. Пагинация или листинг – это и есть страницы, которые мы переключаем, перемещаясь по ним:

Один из самых частых вариантов происхождения неявных дублей – это индексирование таких страниц пагинации. Чтобы краулеры не обходили их, необходимо добавить на все страницы пагинации следующий код код:

Добавление делаем исключительно в секции head-тега. Кстати, «Яндекс» рекомендует устанавливать rel="canonical" со всех URL пагинации исключительно на главную (то есть первую): обратите внимание на второй пункт. Но добавив каноникал, вы не заставите краулеров «Яндекса» четко ему следовать – вы создаете не предписание, а лишь рекомендацию.

А вот Google вообще не рекомендует ставить каноникал со всех URL пагинации, иначе их краулер получит ошибку при очередном сканировании.

Google советует вообще не трогать страницы пагинации и просто сосредоточиться на «улучшении пользовательского опыта». Другими словами, использовать rel="canonical" на страницах пагинации, если ваш сайт получает основной трафик из Google, вовсе не стоит.

Я предлагаю несколько лайфхаков, чтобы не наделать проблем со страницами листингов:

- SEO-оптимизированные описания категорий (или видов / типов) товаров обязательно выводим исключительно на главной странице пагинации, которая в общем порядке идет первой.

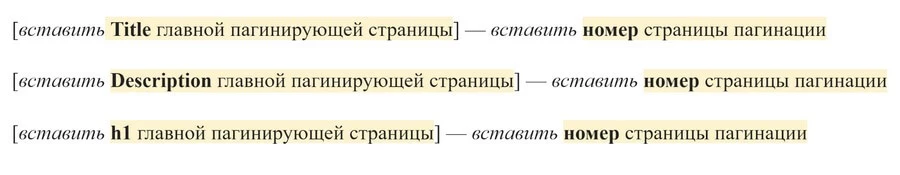

- обязательно используем уникализированные метатеги, в частности description и title. Уникальными должны быть и H1-заголовки. Для решения этой задачи, вы можете использовать готовые паттерны. Например, такой:

404-ая

Один из самых частых сценариев неочевидного дублирования – это некорректно настроенная 404-ая страница. В таких условиях, любая страница будет выводить одинаковый для всех шаблон, отдающий 200-ый код ответа сервера.

Обратите внимание на то, как именно настроена 404-ая на вашем сайте. Помните – чтобы избежать дублей 404-ой, необходимо обратить внимание на все проблемные страницы. Они должны отдавать исключительно 404-ый код.

Еще один вариант решения этой проблемы – просто настроить редирект на страницу с информацией, которую искал посетитель.

Очевидные дубли

Очевидные или явные дубли – это такие же страницы с идентичным содержимым, когда повторяется не только контент, но и порядок его расположения на странице. Здесь существует серия стандартных ошибок, приводящих к появлению дублированного контента. Рассмотрим их подробнее.

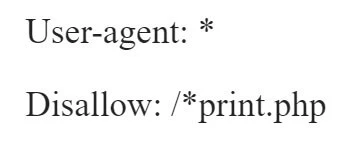

Страница для печати

Дам пример для наглядности:

Как видим из примера выше, дубли появляются в случае, когда печатная версия страницы на вашем сайте, генерируется при помощи функции ?print. Такая версия страницы печати – всегда дубль, так как ее содержимое полностью идентично оригинальной версии страницы.

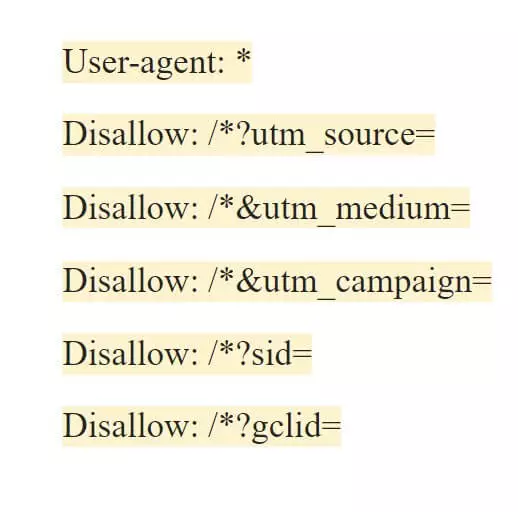

Решить проблему дубля печатной страницы можно при помощи уже знакомых нам директив: Clean-param и Disallow. Первую директиву понимает исключительно отечественный поисковик. Вторая создана специально для краулеров Google. Соответствующие директивы необходимо прописать роботс-файле. Например, так мы сделаем это для всех краулеров:

Вышеуказанное правило будет работать для всех поисковых систем. Если же вам нужно ограничить индексирование print-страниц только краулерам «Яндекса», то воспользуйтесь Clean-param, если только роботам Google – применяйте директиву Disallow.

Слэш после URL

Возможно, вы не обращали внимания, но на разных сайтах используется два типа адресов – с косой чертой в конце адреса и без нее. Выглядит это следующим образом:

Косая черта в конце адреса – одна из самых частых причин дублей. Решить эту проблему не сложнее, чем предыдущие – достаточно сделать 301-ое и перенаправление. О том, как именно это сделать, вы можете узнать в блоге TexTerra.

Что касается более предпочтительного варианта – оставлять все ссылки со слэшем в конце или без него, то здесь нужно смотреть на то, каких URL у вас на сайте было больше изначально. Если со слэшем – значит, оставляем URL со знаком / в конце, если наоборот – оставляет URL без /.

Один товар на разных URL (для интернет-магазинов)

Допустим, у нас интернет-магазин TexTerra, который продает технику Apple. Ссылки на одну модель «Айфона» могут иметь такой вид:

- https://texterra.ru/shop/iphone-12

- https://texterra.ru/iphone-12

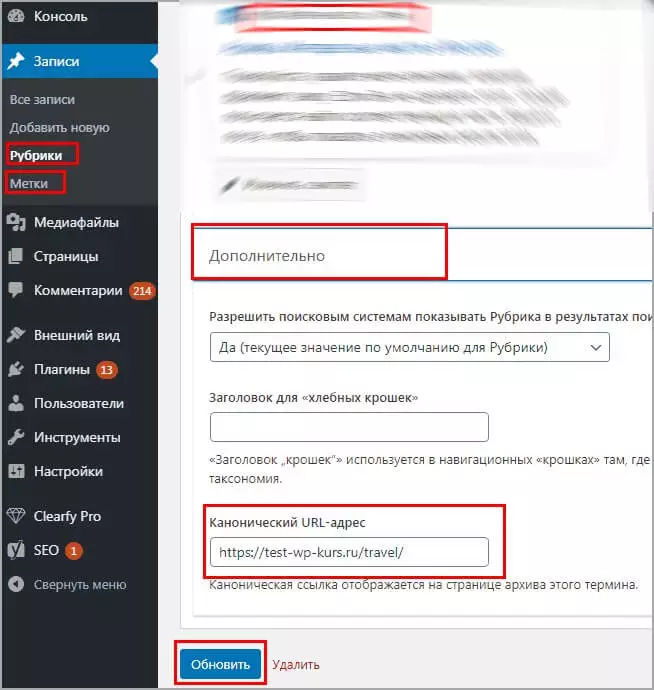

Решить эту проблему можно настроив каноникал на главную страницу. Здесь два способа.

Плагины

Управлять каноническими страницами, проще всего, при помощи плагинов для CMS. Например, у меня один из сайтов работает WP, и для назначения каноникал я использую плагин Yoast SEO. Там канонические страницы настраиваются в два-три клика. Допустим, нужно назначить каноникал в пагинации рубрик:

Специальный тег <link>

Для настройки каноникал можно использовать <link>. Например, нам необходимо указать краулеру, что страница https://texterra.ru/shop/iphone-12 является самой главной. Чтобы решить эту проблему, необходимо добавить в раздел всех дублирующих страниц запись следующего вида:

https://texterra.ru/shop/iphone-12"/>

WWW в ссылках

По аналогии со слэшем, отличаться URL могут и по отсутствию или наличию «www» в начале адреса. На практике такой URL может выглядеть следующим образом:

Избавиться от дублей адресов по признаку наличия или отсутствия «www» можно несколькими способами. Для начала определитесь и укажите главное зеркало. В блоге есть целая статья на эту тему. Статья старая, но в целом актуальная. Единственное замечание – в роботс больше не нужно указывать host-директиву.

Как склеить зеркала в «Яндексе»

Если коротко, то просто откройте «Яндекс.Вебмастер» и убедитесь, что в разделе «Сайты» у вас добавлены обе версии домена – как без «www», так и с «www». На этом шаге нужно определиться какую версию домена мы будем считать главным зеркалом.

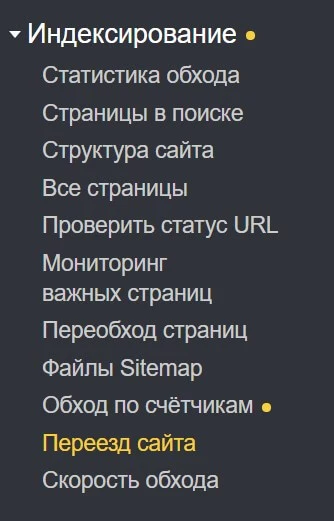

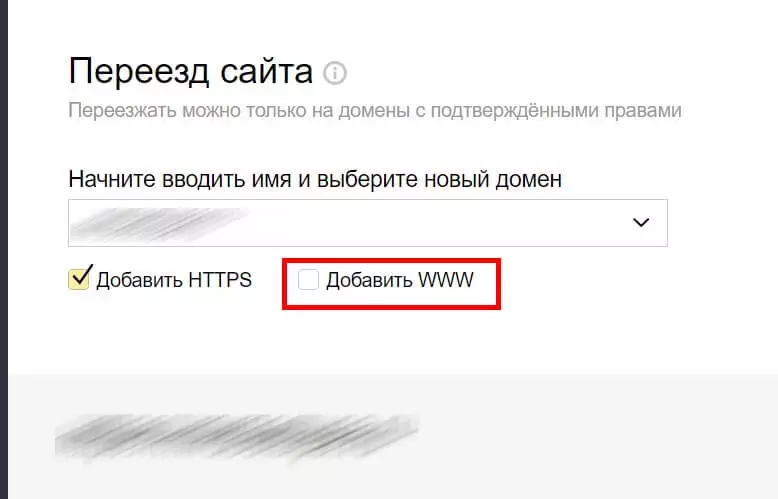

Теперь нужно выбрать тот домен, с которого должна происходить переадресация. Теперь выбираем этот домен в верхней части «Яндекс.Вебмастера» и в разделе «Индексирование» открываем пункт «Переезд сайта»:

Убираем выделение с этого чекбокса:

Как склеить зеркала в Google

Склеить зеркальные домены в Google чуть сложнее – нужно сделать 301-ое перенаправление на главное зеркало. О том, как это сделать, вы можете узнать в нашем блоге. Если способ с редиректом по каким-то причинам не подходит, то можно:

- указать каноническую страницу, добавив соответствующие URL в файл Sitemap;

- указать краулеру каноникал при помощи уже знакомого нам тега <link> – его нужно интегрировать в код всех страниц-дублей;

- прибавить каноникал-заголовок в ответ веб-страницы. Преимущество этого способа в том, что нет никаких ограничений по количеству страниц, кроме этого их размер остается изначальным.

Параметры типа CGI

CGI-параметры в URL – еще одна причина массовых дублей. В данном случае имею в виду динамические параметры, которые изменяют содержимое страницы. Идентифицировать GET-параметры просто – достаточно найти знак «?» во второй части ссылки. Например:

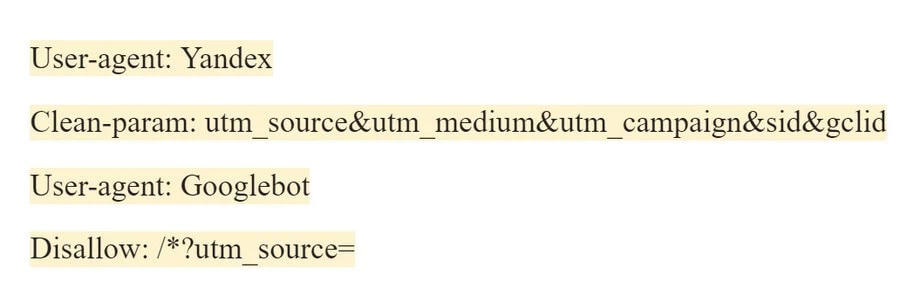

Решить дубли, идущие от GET-параметров, можно одним рабочим способом – создать правила в robots. В него можно включить абсолютно любые типы параметров, например, UTM-разметку или разметку «Google Рекламы»:

Еще один способ – задействовать Clean-param. Но эту директиву, как я уже упомянул выше, поддерживает исключительно «Яндекс», поэтому рассматривать подробнее ее не буду. Хотя вы, конечно, можно использовать обе директивы в одном robots. Выглядеть такое правило будет следующим образом:

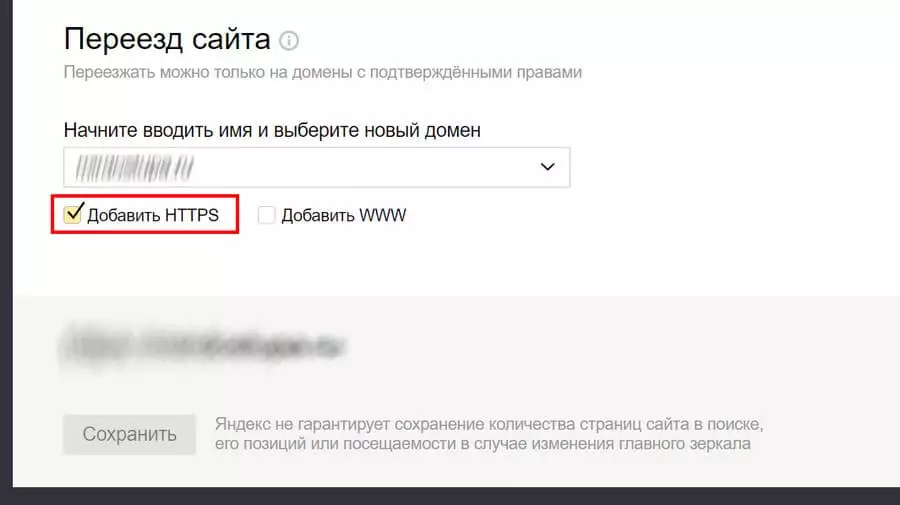

Тип протокола передачи гипертекста в URL

Речь об HTTPS-url и HTTP-url, соответственно.

Если же вы уже купили SSL-сертификат и переехали на HTTPS, наверняка, образовалось огромное количество дублированного контента. Ведь краулеры определяют домены https://www.texterra.ru и http://texterra.ru как совершенно разные. Отсюда и огромное количество дублей. Кстати, у нас есть большой материал по теме «Как переехать на HTTPS правильно» – обязательно прочитайте.

Чтобы решить проблему дублей после переезда на HTTPS-протокол, открываем «Яндекс.Вебмастер» и выбираем главный домен (главное зеркало). Для этого, в разделе «Переезд сайта» (напомню, он находится в разделе «Индексирование») отмечаем соответствующий чекбокс:

Внимание! Обязательно убедитесь в том, что все перенаправления работают корректно. Особенно тщательно проверяйте сами команды редиректов – часто ошибки кроются именно в них.

Послесловие. Работа с дублями Google и «Яндекс» – в чем разница

Мы убедились в том, что устранить дубли можно несколькими инструментами. Как обычно Google и «Яндекс» заметно различаются в своих инструкциях для вебмастеров. «Яндекс» рекомендует работать с дублями через файл robots и директиву Clean-param. Google же советует устранять повторы через 301-ое перенаправление и атрибут Canonical.

Что лучше? Здесь каждый владелец сайта должен сам выбрать наиболее оптимальный сценарий работы с дублями. Если основной трафик на ваш сайт идет из «Яндекс» – используйте директиву clean-param. Если трафик, в основном, из Google – используйте Canonical.

Не рекомендую слишком увлекаться перенаправлениями, так как они создают излишне высокую серверную нагрузку и другие проблемы, а еще затрудняют индексацию новых страниц.

Читайте также:Если вам нужно быстро удалить дубли – обращайтесь в TexTerra. Мы проанализируем ваш ресурс и подскажем, как еще можно улучшить его работу. Если же вы только планируете разработку, то лучше доверьте работу профессионалам на самом первом этапе. Это поможет решить многие проблемы, которые могли бы возникнуть в будущем.

Продвижение бизнеса: какие инструменты в маркетинге реально работают и насколько они эффективны

Как маркировать рекламу в 2024 году — инструкция

73 бесплатные нейросети на все случаи жизни – выбор TexTerra