Что такое индексация, или индексирование сайта

Индексация сайта – процесс обработки его страниц поисковыми роботами. Он нужен, чтобы информация о странице и ее содержимом попала в базы данных поисковых систем.

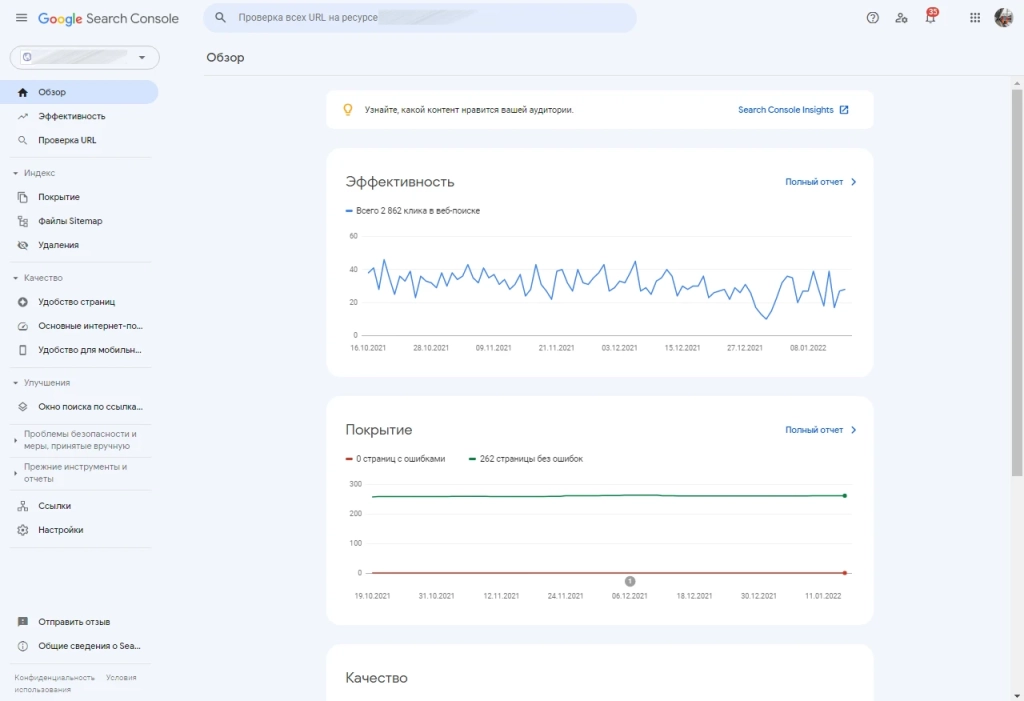

Отчеты по индексации – «Покрытие», «Файлы Sitemap» и «Удаления»

Индексирование состоит из трех этапов: сбор, валидация и запись полученных данных.

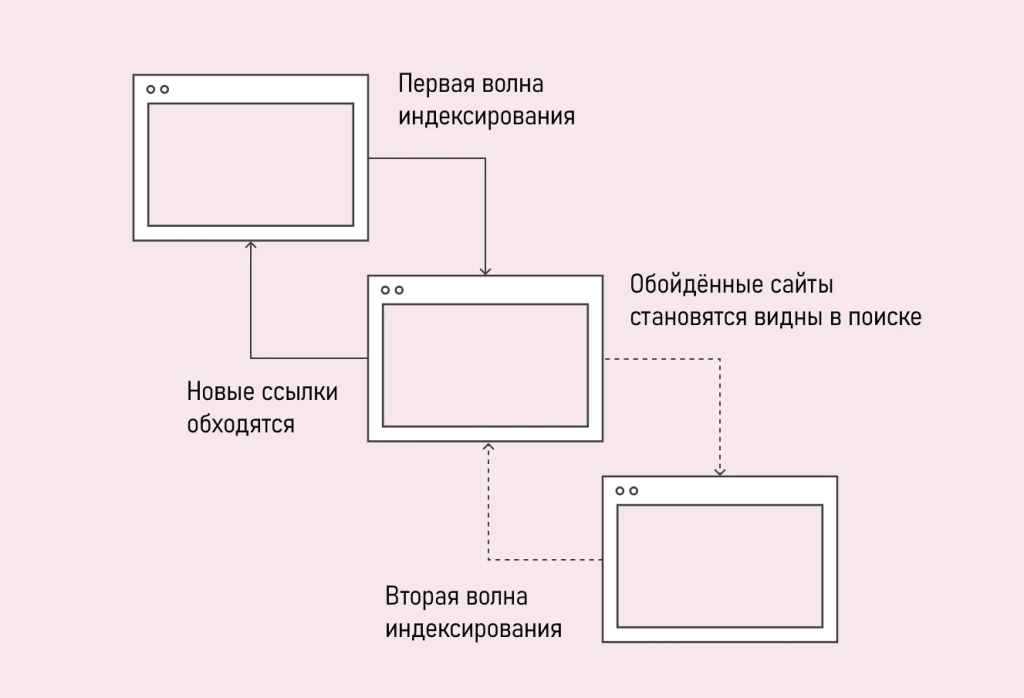

Так Google индексирует новые страницы сайтов

Качественные сайты индексируются быстро и в автоматическом режиме. Иногда это не идет ресурсам на пользу – страницы могут попадать в индекс преждевременно.

Чем плоха преждевременная индексация

Вред преждевременной индексации может проявляться в разных ситуациях.

-

Изменение вида URL. Экспериментируя с разными вариантами внешнего вида ссылок, вы рискуете: краулер может проиндексировать тестовый вариант. Придется долго ждать, пока он покинет индекс, и в результатах поиска появятся ссылки на корректно настроенные URL страниц.

-

Изменение дизайна сайта или другие глобальные «перестановки». Аналогично: в индекс вместо финальной версии страницы может попасть тест.

-

Страница еще не оптимизирована под SEO. Например, не заполнены метатеги, не выделено семантическое ядро или ключевые фразы, по которым страница будет продвигаться в дальнейшем.

-

Тестирование мобильной версии сайта на адаптивном шаблоне или на самостоятельном поддомене. Поисковые системы могут преждевременно проиндексировать несколько версий сайта, что приведет к ошибкам в индексе.

Последствия индексации в этих случаях будут серьезными. Если вы захотите, например, откатиться к предыдущей версии сайта, придется запастись терпением: поисковые системы уже проиндексировали изменения, и в индекс попадет некорректная версия сайта.

Как закрыть страницу от индексации

В случае тестирования глобальных изменений можно закрыть сайт от индексации целиком. Если изменения будут вводиться только на одной странице, нужно закрыть от индексации только ее.

Как закрыть сайт от индексации с помощью robots

Метатег robots позволяет задать отображение страницы в результатах поиска + повлиять на ее индексацию.

Метатег можно добавлять как в код страницы, так и в HTTP-заголовок.

Чтобы запретить показ страницы в результатах поиска, добавьте следующий фрагмент в head-раздел страницы:

<!DOCTYPE html> <html><head> <meta name="robots" content="noindex" /> (***) </head> <body>(***)</body> </html>

Часто требуется запретить сканирование только определенному краулеру. Для этого необходимо указать его user-agent. Например, чтобы запретить сканирование только поисковому роботу Google, добавьте следующую строку:

<meta name="googlebot" content="noindex" />

Если добавить код в HTTP-заголовок не удается, можно добавить этот же метатег в код страницы.

<meta name="robots" content="noindex, nofollow">

Так вы запрещаете индексировать страницу всем краулерам, которые понимают директивы в стандарте исключения для роботов.

Также вы можете запретить индексацию:

-

Всех опубликованных на странице изображений:

-

Страницы целиком – только поисковому роботу Google Новостей:

<meta name="robots" content="noimageindex">

<meta name="Googlebot-News" content="noindex, nofollow">

Теперь страница не будет появляться в ленте Google Новостей.

Как закрыть сайт / папку / файл от индексации с помощью robots.txt

В стандарте исключения для роботов (он же robots.txt) вы можете ограничить индексацию не только отдельных страниц, но и целых разделов сайта.

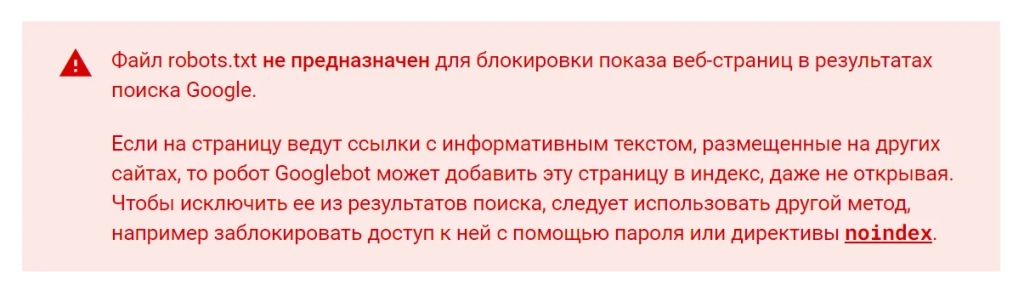

Заблокировать показ страницы, отредактировав файл robots.txt – можно, но страница все равно может быть проиндексирована

Все директивы в стандарте исключения для роботов носят рекомендательный характер. Краулеры могут их не исполнять.

Даже если указана запрещающая директива, страница или раздел все равно могут быть проиндексированы. Кроме этого, краулеры поисковых систем могут по-разному интерпретировать синтаксис директив, а сами поисковые системы иногда вообще не поддерживают запрещающие директивы.

Google и «Яндекс» работают с robots.txt корректно.

Чтобы запретить преждевременную индексацию краулерам всех поисковых систем, добавьте в стандарт исключения для роботов такую строку:

User-agent: * Disallow: /

Формально вы покажете поисковым роботам, что индексировать ваш сайт не нужно.

Чтобы запретить индексацию сайта только поисковому роботу «Яндекс», добавьте в стандарт исключения эту строку:

User-agent: Yandex Disallow: /

Иногда защитить от преждевременной индексации требуется определенную папку сайта. Для решения этой задачи добавьте в стандарт исключения следующую строку:

User-agent: *

Disallow: /vasha_papka/

(не забудьте заменить vasha_papka на закрываемую от индексации папку)

Закрыть от индексации можно и отдельный файл. Для этого пропишите поискового робота и укажите запрещающую директиву (disallow) в robots.txt:

User-agent: Yandex Disallow: /papka/vash_file.php

(не забудьте заменить vash_file.php на закрываемый от индексации файла)

Если вы хотите закрыть от преждевременной индексации какой-либо фрагмент текста, добавьте следующую директиву в код страницы:

<noindex>текст, индексирование которого нужно запретить</noindex>

Тег <noindex> понимают только поисковые роботы «Яндекса».

Не путайте тег noindex с директивой noindex – директиву понимают и краулеры Google. Чтобы запретить появление страницы в результатах поиска Google – добавьте директиву noindex в HTTP-заголовок страницы или метатегом в код страницы.

Повторим

Преждевременная проверка страниц краулерам может навредить сайту, если в индекс попадают дубли страниц или тесты. Чтобы этого избежать, используйте один из трех лайфхаков:

-

укажите краулерам инструкцию в HTTP-заголовке;

-

пропишите директиву в стандарте исключения для роботов (robots.txt);

-

пропишите специальный тег в коде страницы.