Почему об этом надо знать? Потому что deep learning – это революция в машинном обучении, которая происходит на наших глазах. И в ближайшее время deep learning изменит до неузнаваемости и сам поиск, и ранжирование в естественной выдаче, и наш мир в целом (не много, не мало).

Итак, что такое deep learning? В русском языке этот термин пока еще не устоявшийся, и переводят его по-разному. Мне больше нравится перевод «глубинное обучение» (а не «глубокое»), которое предложил в качестве основного один из российских специалистов Дмитрий Ветров.

«Глубинное обучение» – это разновидность машинного обучения, в основе которой лежат нейронные сети. Сегодня на использовании «глубинного обучения» строятся системы распознавания речи, распознавание визуальных объектов (как статических, так и движущихся) и, наконец, взаимодействие компьютерных систем с естественным языком и вычленение смыслов.

Вроде бы все просто, все понятно, и – вроде бы – нас с вами не касается. Но… Но на самом деле, речь идет о настоящей революции в области машинного обучения. Она началась не вчера, общие принципы «глубинного обучения» существуют достаточно давно. Но фактическое воплощение deep learning стало возможно в начале нынешнего десятилетия, когда значительно подешевело создание компьютерных нейросетей. И начиная примерно с 2012-го года в машинном обучении происходит настоящий бум, связанный с технологиями «глубинного обучения». Тем не менее, до сих пор специалистов по «глубинному обучению» в мире очень мало, а потребность в них очень высока. Например, алгоритм распознавания смысла в текстах создал практически один человек – Thomas Mikolov. На тот момент он работал в Google, но практически сразу же после этого его «схантил» Facebook*.

Читайте также: LSI-копирайтинг – тренд ближайшего времени

Выше я уже сказал, что «глубинное обучение» – это разновидность машинного обучения. Но это не совсем так, на самом деле. Классическое машинное обучение – это извлечение новых знаний из большого массива данных, которые загружает в машину человек. Человек формулирует правила обучения машины (за счет т.н. «обучающей выборки»), и правит ошибки машины (устраняет эффект т.н. «переобучения»). Но у классического машинного обучения есть существенные недостатки – данные для обработки и примеры решения даются машине человеком. Другими словами, в классическом машинном обучении компьютер выполняет большое количество задач, но не формирует эти задачи самостоятельно. Концепция «глубинного обучения» предполагает, что машина сама создает себе функционал, насколько это только возможно на текущий момент времени.

Само понятие «глубина» в применении к машинному обучению предполагает моделирование многоуровненных абстракций («слоев») и перевод их в данные. Чем больше этих «слоев» («глубин»), тем более высокоинтеллектуальные задачи может выполнять нейронная сеть. При этом выполняет она их без помощи человека.

По сути, «глубинное обучение» – это первый и достаточно большой шаг в сторону искусственного интеллекта. Нейронные сети – это системы, которые, пусть пока примитивно, но могут думать, т.е. создавать новые открытия из данных, которые они сами для себя и создали. Механизм многоуровневых абстракций («слоев»), используемый в глубинном обучении, очень похож на механизм обучения человеческого детеныша. Как ребенок сначала изучает звуки, потом отдельные слова, и только потом предложения – «глубинная» нейронная сеть движется от простых (поверхностных) абстракций к более сложным.

Революция deep learning

Весь 2012 и 2013 годы Google тихо, но методично скупает действующие фирмы и стартапы в области deep learning. Среди них были как достаточно крупные компании (например, стоимость британской DeepMind по словам экспертов на момент покупки поисковым гигантом колебалась в пределах 400-500 млн. долларов США), так и совсем карликовые – например, DNNresearch, в которой на момент покупки компании Гуглом работало всего лишь три сотрудника – Джеффри Хинтон и два его аспиранта.

Хинтон, профессор Торонтского университета, начал свои изыскания в области построения нейронных сетей еще в 80-ые года прошлого века и, фактически, является сегодня самым авторитетным специалистом в мире по deep learning. Именно на научных работах Хинтона базировались многие системы, использующие «глубинное обучение». В 2011-ом году Google создает свою первую нейронную сеть, получившую название Google Brain (ее разрабатывает уже ставшее культовым подразделение Google X), и поначалу Хинтон участвует в разработке нейросети в качестве наемного консультанта, а двумя годами позднее вместе со своими аспирантами присоединяется к команде Google Brain (не оставляя при этом свою преподавательскую деятельность в Университете Торонто).

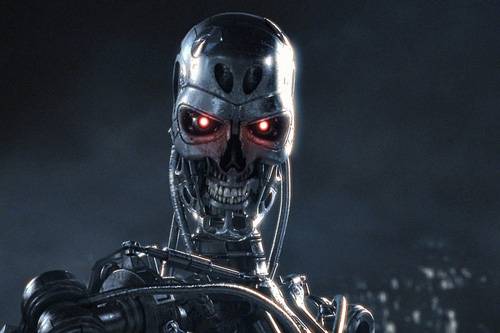

Нейронная сеть Google Brain (в 2012-ом году она состояла из 16 тыс. процессоров) начинает обучаться. Попутно решая прикладные задачи – например, именно благодаря нейронной сети количество ошибок распознавания голосовых команд в поиске уменьшилось на 25%, – она открывает для себя такое существо, как кошка.

Просто изучая миллионы изображений на канале Youtube искусственная нейросеть открыла кошку. На самом деле решение подобной задачи – архисложная вещь, потому что она трудно формализуется. Можно создать алгоритм, который будет распознавать кошек на определенных типах фотографий (со схожим ракурсом, со схожими размерами объектов). Можно создать алгоритм, который будет рисовать этих кошек. Но как создать алгоритм, который будет распознавать кошек в любом ракурсе, если он, алгоритм, не понимает, что такое кошка?

Нейронная сеть должна была начать понимать это. И она этому обучилась. Обучилась сама, человек не ставил ей такой задачи.

Понятно, что пока все еще не так все радужно. Нейронная сеть отличает кошек на изображениях только в 15% случаев. Точность может быть гораздо выше, если сеть будет изучать однотипные материалы. То есть, фактически, точность распознавания кошек нейронной сетью в настоящее время значительно хуже, чем распознавание кошек 4-5 летим ребенком. Но нейронную сеть, в отличие от ребенка, никто не обучал, никто не показывал объекты с кошкой, называя их. Сеть родила концепт кошки самостоятельно.

Что будет дальше

В марте 2015 года в мире SEO взорвалась «ядерная бомба» – Google опубликовал статью «Доверие, основанное на знаниях: оценка надежности веб-ресурсов». Бесспорно, я преувеличиваю, новость, на самом деле, прошла незаметно. Ну, пару дней сеошники повозмущались и поскептицировали – извиняюсь за это дурацкое слово, но я не знаю, как еще обозначить бурления на сеошных форумах и в группах соцсетей. Возмущению («опять Гугл на нас опыты ставит») и скепсису («ничего у него не выйдет, как и у Яши с отменой ссылочного») не было предела. Оно и понятно, в сугубо научной статье представители Гугла проанонсировали новый алгоритм ранжирования, основанный на не ссылочной авторитетности документа, а на фактологической достоверности. Если упрощенно, то суть нового алгоритма можно выразить следующей сентенцией: документ с достоверной фактологией при прочих равных должен ранжироваться выше документа с недостоверной фактологией.

Скепсис сеошников в общем-то понятен – они (как, впрочем, и всегда) увидели только то, что захотели увидеть. И основной вопрос, который задавался на форумах, звучал примерно так: «Это что же, черт вас всех дери, получается – теперь мы должны создавать контент, который будет приводить факты из Википедии или других авторитетных источников, даже если они на странице совсем не уместны?».

Но дело в том, что новый алгоритм не может работать без понимания смысла, сказанного на странице. Понимание смыслов написанного/озвученного текста на странице, а не распознавание семантики – вот что сделает поиск неузнаваемым.

Как «глубинное обучение» будет работать в поиске? Обращусь к опыту людей, которые разбираются в этом гораздо лучше меня. Вот что говорит Рэнд Фишкин в очередном выпуске Whiteboard Friday (кстати, этот выпуск так и называется – «Что значит глубинное обучение и машинное обучение для будущего SEO?»):

«Нейронная сеть состоит из различных слоев. Первый слой будет выявлять всевозможные особенности документа. Другой слой нейросети будет классифицировать типы этих особенностей. Таким образом Google будет учитывать все возможные особенности любого типа сайтов и любого типа страниц для того, чтобы решать: а какие полезные сигналы вообще можно извлечь прямо здесь и сейчас? При этом нейронная сеть будет учитывать накопленные данные о поведении пользователей на всех страницах интернета (куда она сможет дотянуться) для того, чтобы прогнозировать результаты – понравится ли тот или иной документ пользователю в выдаче или нет.

Но основная идея состоит в том, что в будущем входящие данные не будут контролироваться человеком. Машина сама будет стараться понять содержание страницы. Да, это странно звучит. Но в скором времени, если вы спросите инженера Google – например, стоит ли продолжать наращивание входящих ссылок на сайт? – он вам, скорее всего ответит: не знаю. Они, действительно, перестанут знать, какие именно сигналы выделяет поисковый алгоритм для определенного запроса и определенного типа страниц. Только машина будет знать это, но она объяснить никому ничего не сможет, потому что алгоритм ранжирования будет постоянно видоизменяться по мере появления новых документов по этой тематике, и многие метрики, которые будут использоваться нейросетью, будут производными производных большого количества других метрик».

Читайте также: Как создавать и распространять идеи

«Глубинное обучение» наступает

Революция deep learning, по сути, только начинается. Но уже сегодня нейронные сети с использованием «глубинного обучения» функционируют.

Например, на технологиях deep learning работают сервисы мониторинга дорожных пробок. Да, «Яндекс.Пробки» не только отображает реальную картину, но и старается прогнозировать появление пробок, а без deep learning такое прогнозирование невозможно.

Голосовой поиск Google и Apple Siri работает на технологиях «глубинного обучения».

Сервис Google прогнозирования распространения гриппа работает на методиках deep learning.

Алгоритмы распознавания людей на фото и видеоизображениях, которые ежедневно загружаются в Facebook*, работают на технологиях deep learning.

Для поиска. Алгоритмы персонификации поисковой выдачи работают на технологиях deep learning.

Мы входим в новый чудесный мир. И ближайшие пять лет будут поистине революционными – не только для поискового маркетинга, но и для человечества в целом. Очень скоро мы все это увидим собственными глазами.

*Facebook принадлежат Meta, которая признана экстремистской организацией и запрещена на территории РФ