Продвинутые нейросети уже могут писать тексты, которые в общем не особо отличаются от посредственных человеческих. Расскажем, как авторы могут повысить скорость написания своих статей, не теряя при этом в качестве.

Нейронные сети — мощный инструмент, который можно использовать для решения разных задач. Генерация текста и написание статей входят в этот длинный список. Но без опыта составления промтов и знания особенностей каждой модели результат будет неудовлетворительным. Да, и все нейронные сети по состоянию на 2023 год несовершенны. Они могут ошибаться в фактах, давать неточную информацию, а иногда даже привирать. Вот почему важно использовать искусственные нейронные сети (ИНС) аккуратно и всегда вычитывать результат. Лучше, если это будет делать эксперт в той области, по которой написана статья.

Сервисы для нейрогенерации статей

В 2023 году доступно множество нейронок для написания текста. Самые популярные: GPT-4, Claude-2 и Google Bard. Каждая нейросеть строится на определенной языковой модели. Почти каждая из таких моделей представляет собой предварительно обученный алгоритм, который умеет создавать человекоподобный текст, если вы отправите ей запрос из двух-трех слов. Самые распространенные языковые модели:

GPT-3/3.5/4

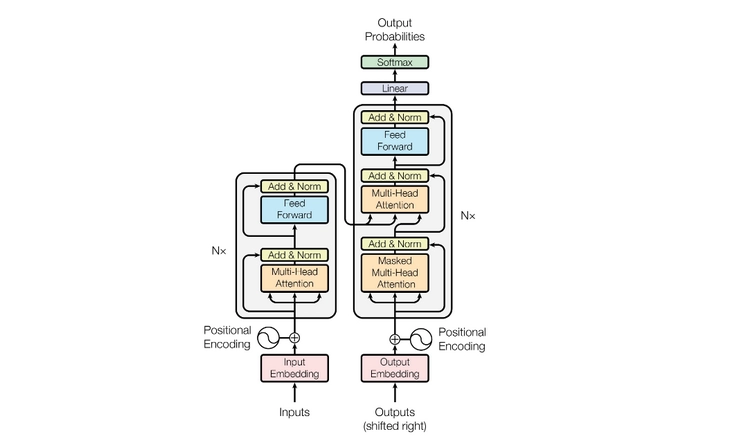

Большая языковая модель, созданная компанией OpenAI. GPT — это аббревиатура от Generative Pre-trained Transformer или «генеративный предварительно обученный трансформер». Нейросеть умеет генерировать текст, переводить, решать задачи. И GPT-2 и GPT-3 — это языковые модели, основанные на так называемых трансформерах от OpenAI. Трансформер — это программный алгоритм, который умеет читать / анализировать большие объемы данных. В нашем случае — это текст.

Подробнее о том, как работают нейросети GPT, мы рассказывали в отдельной статье.

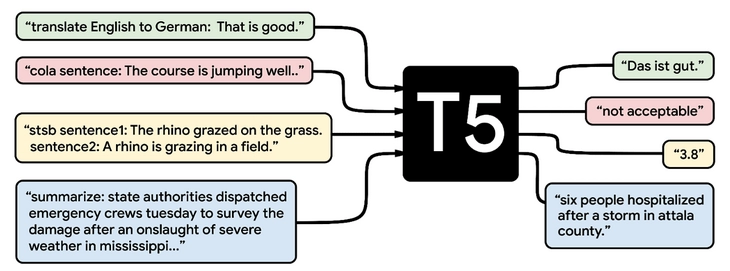

T5

Гугловская языковая модель. Умеет все то же самое, что и GPT, но с более актуальной информацией (данные после 2022 года). T5 был разработан для работы с широким спектром задач, и эта нейросеть лучше GPT справляется с машинным переводом, ответами на вопросы и резюмированием текста.

Перевод (зеленый цвет), лингвистическая приемлемость (красный цвет), сходство предложений (желтый цвет) и обобщение документов (синий цвет).

T5 и GPT-3 были обучены на совершенно разных наборах данных. GPT-3 — на огромном корпусе универсальных данных, а T5 — на общедоступных наборах данных (книги, статьи, научные работы) для решения конкретных задач. Кроме того, T5 требует тонкой настройки на конкретную задачу для каждого приложения.

BART

Обновленная модель от Facebook** AI Research. Умеет создавать текст на разных языках, на русском текст связный и читабельный. Также умеет делать перевод.

Возможности BART:

- Используется для генерации текста.

- Может создавать текстовые результаты любой сложности, например, резюме и описания.

- Хорошо подходит для резюмирования и упрощения текста.

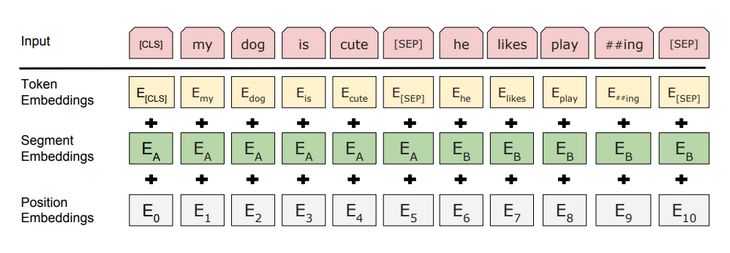

BERT

Написана разработчиками Google. Аббревиатура BERT расшифровывается как Bidirectional Encoder Representations from Transformers. Так что и в ней используется модель обработки на основе трансформеров.

Возможности BERT:

- Используется для понимания языка.

- Выясняет значение слов на основе контекста.

- Хорошо отвечает на любые вопросы и анализирует стиль текста.

Чтобы не запутаться в двух похожих на слух моделях (BERT и BART) — даем их отличия кратко:

- BERT помогает машинам лучше понимать язык.

- BART помогает анализировать и генерировать текст.

LaMDA

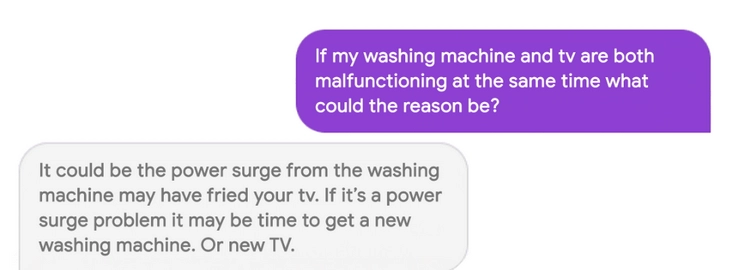

Еще одна гугловская языковая модель. T5 — большая языковая модель общего назначения, в то время как LaMDA больше ориентирована на общение с пользователем.

T5 также меньше LaMDA с точки зрения количества параметров и обучена на гораздо меньшем массиве данных.

Основная проблема LaMDA заключается в том, что она не понимает язык по-настоящему. Она просто генерирует убедительные, но не всегда верные ответы на вопросы.

PaLM 1 (Pathways Language Model)

Снова разработка Google. Pathways потенциально может стать самой мощной языковой моделью с точки зрения базы знаний, количества параметров, разговорных функций. И Pathways — самая большая из моделей Google. Для сравнения, она имеет 175 миллиардов параметров по сравнению с 11 миллиардами у T5.

PaLM 2

Этой моделью сегодня может воспользоваться любой желающий. Интересно, что PaLM 2 обучалась на огромном наборе текстовых данных разного формата (Wiki, новости, книги, научные публикации).

PaLM 2 ориентирован на решение традиционных задач понимания естественного языка (ответы на вопросы, обобщение, перевод). Именно эту модель можно назвать самой универсальной, благодаря огромному количеству данных для обучения.

Какие нейросети лучше всего подойдут для написания статей

Скажем пару слов об архитектурах текстовых нейросетей. Мы собрали только то, что вам точно будет полезно.

- Долгая краткосрочная память или LSTM. Эта разновидность архитектуры отлично выручит, если нужен длинный, последовательный текст. Причина: LSTM-архитектуры умеют улавливать долгосрочные зависимости в данных.

- Трансформер — основной элемент большинства современных ИНС: от GPT-2 и GPT-3 до BERT и множества других.

- CNN (Convolutional Neural Network). По-русски — конволюционная нейронная сеть. Нейросети с такой архитектурой встречаются для написании статей гораздо реже, ведь главный профиль CNN — обработка изображений. Конечно, технически CNN пригоден и для обобщения текста.

- VAE (Variational Autoencoder). Это генеративный алгоритм, использующий глубокое обучение для создания нового текста, а также для обнаружения аномалий и удаления шумов. Используется архитектура кодера-декодера. И она эффективна при изучении скрытых представлений в текстовых данных. Вот почему нейросети с архитектурой VAE хорошо справляются с генерацией новых текстов, похожих на обучающие данные.

- GAN (Generative Adversarial Network). Двухсетевая система: генератор создает новый текст, а дискриминатор пытается отличить генерацию от реальных данных. Нейросети с GAN не только пишут новые статьи, но и качественно структурируют их, умеют разнообразить результаты.

Какую модель выбрать для написания статьи

Вы уже поняли, что разные нейронки обладают собственными достоинствами и недостатками + с каждым месяцем появляются новые нейросети, новые языковые модели. Чтобы не запутаться — приводим отличия самых популярных языковых моделей:

LSTM:

- Хорошо генерирует длинные связные тексты благодаря наличию ячеек памяти, в которых хранится информация.

- Требует относительно меньшего объема обучающих данных по сравнению с «трансформаторными» моделями.

- Генерирует больше повторов, требующих редактирования

Трансформер:

- Обучается на огромных объемах текста, поэтому обладает большим словарным запасом и качественно новым пониманием языка.

- Генерит более разнообразный, емкий и фактологический текст по сравнению с нейросетями на основе модели LSTM.

- Требует огромных объемов обучающих данных и не менее большого пула вычислительных ресурсов.

CNN:

- Для прогнозирования использует только «локальную» информацию (от близлежащих слов).

- Не идеальна для генерации длинных статей, но неплоха для обобщения данных.

VAE:

- Может изучать скрытый стиль обучающего текста.

- Создает новые тексты, которые очень похожи на обучающие данные.

- Склонна генерировать абстрактные, бессмысленные тексты.

GAN:

- Две конкурирующие сети (генератор и дискриминатор) улучшают результат генерации даже по не слишком удачным промтам.

- Создаёт нестандартные, непредсказуемые, во многом — творческие тексты.

- Сложна в обучении.

- Воздействие генератора и дискриминатора приходится балансировать.

GPT-2 И GPT-3:

- Современные языковые модели с большими трансформерами.

- Создает наиболее человекоподобный текст: емкий, детальный, фактологически непротиворечивый.

- На русском языке результат далёк от идеального. Требует тщательного редактирования.

BERT:

- Предварительно обученная модель-трансформер, хорошо понимающая взаимосвязь между словами.

- Может быть тонко настроена — для решения разнообразных задач, связанных с естественным языком (генерация текстов, перевод, обобщение, перефразирование).

- Генерирует грамматически правильный текст.

Правильные промты и нюансы

Только опыт, практика с экспертами дадут возможность набить руку в написании статей через нейросеть.

Опытный писатель сводит к минимуму объем последующего редактирования сгенерированного текста. Но редактирование должно быть всегда. Как и должен быть тщательный фактчекинг, вычитывание, нахождение логических ошибок. Только так можно написать статью, которая будет сильной и полезной.

Примеры промтов

Начните с темы. Тема — основная идеи будущей статьи. Хорошо работает информативный, но краткий тезис из 1-2 предложений. Например:

- «Основные преимущества использования ИИ для помощи в медицинской диагностике».

- «3 причины, по которым электромобили будут доминировать на автомобильном рынке к 2030 году»

Далее — упомяните ключевые факты, цифры, реальные данные. И чем конкретнее и структурированнее будет ваш запрос, тем лучше. Например, вот так:

«Компания Tesla продала 500 тысяч электромобилей в 2023 году. Аналитики прогнозируют, что к 2029 году продажи превысят 2 миллиона в год — благодаря снижению стоимости аккумуляторов и улучшению зарядной инфраструктуры».

Добавьте переходную фразу, чтобы дать старт основным абзацам. Например:

«Эти факторы способствуют массовому распространению электромобилей».

Далее следуют 2-5 коротких абзацев с изложением основных разделов или аргументов в статье:

«Более доступные цены на автомобили благодаря…»

«Снижение затрат на обслуживание за счет меньшего количества движущихся частей в трансмиссиях электромобиля».

«Государственная политика, стимулирующая покупку электромобилей с помощью субсидий и налоговых льгот».

В конце — дайте нейросети возможность подвести итог и сделать вывод:

«В итоге, резкое падение цен на аккумуляторы, рыночный спрос и поддерживающая политика указывают на…».

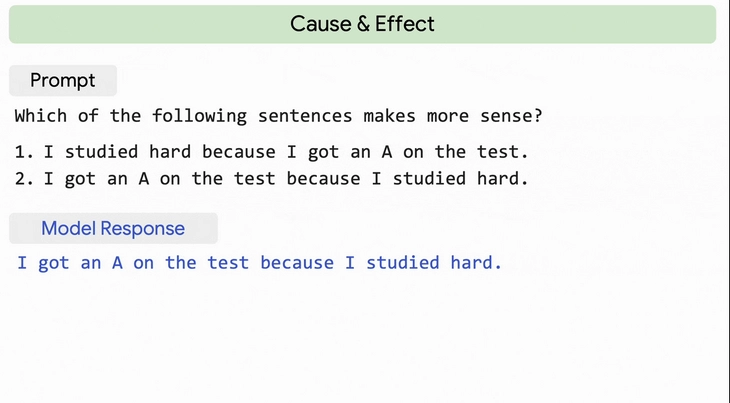

Так как нейросети-трансформеры лучше всего обучены завершать написанные человеком тексты, такая постановка задачи может обеспечить наилучший результат генерации.

Больше примеров

Плохо — «Напиши интересную статью о развитии технологий».

Здесь мы видим расплывчатый, открытый вопрос, из которого вряд ли получится связная или фактологическая статья.

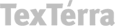

Хорошо — «К 2030 году роботы с искусственным интеллектом, вероятно, будут выполнять большинство рутинных производственных работ. Какие основные причины этого?»

И посмотрите какой четкий ответ дала нейросеть:

(приводим в оригинальном виде)

«Достижения в области компьютерного зрения, датчиков и машинного обучения позволили роботам сравняться и превзойти человеческую точность, скорость и надежность при выполнении повторяющихся задач.

Общая стоимость владения промышленными роботами за последние годы значительно снизилась, что делает их экономически целесообразными для более широкого круга задач.

Автоматизация позволит производственным компаниям снизить трудозатраты, увеличить время работы и оптимизировать использование ресурсов.

Хотя переход к роботизированному труду сопряжен с риском для некоторых рабочих мест, он также способен обеспечить повышение эффективности, сокращение затрат и инновации, которые могут принести пользу экономике в целом».

Вот плюсы сгенерированной статьи:

- Структурирована (есть цифры, факты).

- Излагает 3 логических аргумента с примерами.

- В заключении — возможность резюмировать ключевые моменты

Запомните:

Чем более структурированным и подробным будет ваш запрос нейросети, тем проще ей будет следовать инструкциям, генерируя тематическую, фактологическую статью с последовательной структурой.

Чтобы статья с помощью нейросети получилось качественной, нужно:

- Предоставить актуальную фактическую информацию. Никакой воды или пространных формулировок.

- Наметить четкую последовательность разделов и аргументов.

- Дать конкретные переходы и логические связки, чтобы направить текст.

Только пробуя десятки вариантов промтов ежедневно вы можете научиться делать по-настоящему крутые статьи.

Как составлять промт

Сохраняйте краткость, но не забывайте о деталях. Длинные подсказки не всегда дают лучшие результаты, к тому же они могут увеличить количество повторов в генерируемом тексте.

Обязательно используйте существительные, даты и числа — для получения полезной, уникальной статьи с данными

Нейронные сети хорошо реагируют на конкретные детали и конкретные примеры. Ограничьте использование местоимений и двусмысленных слов. Вместо этого обращайтесь к объектам по имени, чтобы уменьшить двусмысленность и путаницу. Добавьте tone-of-voice или, например, оценочные обороты (к счастью, к сожалению).

Структура

Набросайте основную структуру и включите в нее слова для логического перехода. Например: во-первых, во-вторых, более того, наконец. Это даст нейросети понимание требуемой структуры.

Ограничьте длину подсказки — примерно 50-100 словами. Более длинные подсказки, как правило, дают повторность. Протестируйте несколько вариантов одного и того же промта, так вы получите наиболее подходящий текст. Сохраните и сравните результаты генерации для разных промтов, так вы найдете наиболее релевантный и связный текст.

Какие вопросы задавать

Избегайте открытых или расплывчатых вопросов. Лучше максимально конкретизируйте тему, чтобы пространства для разночтений промта у нейросети не оставалось.

Объем

Установите ограничения по объему генерируемого текста. Для этого можно указать в промте примерное количество слов или, например, разделов, либо абзацев. Длинные промты могут приводить к бессвязному тексту, который никому не нужен.

Завершающие штрихи

Добавьте стилистические подсказки в промте — для регулировки tone-of-voice и стиля текста. Вы можете сделать текст в позитивном ключе, например, либо в негативном. Стремитесь свести к минимуму грамматические ошибки, фактические неточности, отсутствие логики изложения.

Начните с более широкой, общей подсказки и далее совершенствуйте ее, устраняя недочеты. В итоге вы получите наиболее точный промт, в ответ на который нейросеть будет генерировать качественный ответ.

При необходимости предоставляйте нейросети дополнительный контекст. Для этого можно объяснять в промте аббревиатуры, жаргонные слова и другие понятия, которые могут быть незнакомы модели. Например, термин CAC нейросеть может трактовать по-разному и важно раскрыть в скобках аббревиатуру прямо в промте.

Бонус

И еще три важных момента, которые нужно держать в голове для получения качественного текстового контента:

- Контроль со стороны человека-писателя по-прежнему крайне важен. Нейронным сетям даже в 2023 году не хватает здравого смысла, контекста и нюансов, которыми обладает человек. Внимательно смотрите результат и не бойтесь добавлять детали, исправлять ошибки и, конечно, улучшать общую согласованность текста.

- Пробуйте использовать несколько нейросетей для генерации разных частей статьи. Например, GPT-3 — для вступления, PaLM 2 — для основной части и так далее.

- Содержимое, создаваемое нейросетью, со временем улучшается, поскольку модель переобучается на основе большего количества данных и обратной связи. Продолжайте совершенствовать промты! Даже если на первых порах результат генерации совсем не приемлем.

Выводы: как написать статью через нейросеть

Инструкция

- Выберите главную тему. На первых порах работайте только с одной темой. Наличие четкой темы поможет ИНС дать более человекоподобный текст.

- Соберите данные по теме и определите ключевые моменты, которые вы хотите донести до аудитории.

- Когда вы отправляете промты — вы обучаете ИНС. Можете использовать в промтах данные из новостей, википедии, научных работ.

- Составьте план статьи, включающий введение, основные абзацы и заключение.

- Выберите подходящую архитектуру нейронной сети для решения поставленной задачи. LSTM (для генерации длинного текста), конволюционные нейронные сети (для обобщения текста). Подробнее см. в разделе «Какую модель выбрать для написания статьи».

- Сгенерируйте текст.

- Завершите работу над статьей, вычитав орфографические и грамматические ошибки. Перепроверьте все факты и цифры в статье, чтобы убедиться в их точности.

И еще три рекомендации для тех, кто хочет получить качественный текст с помощью нейросети:

- Используйте ИНС для генерации общих моментов, определений. Но не полагайтесь на то, что она напишет статью за вас.

- Используйте нейросеть для упорядочивания своих мыслей и структурирования текста. Но не позволяйте ей диктовать содержание статьи.

- Требуйте от нейросети переписать фрагмент текста, который вас не устраивает.

Читайте также:

71 бесплатная нейросеть на все случаи жизни – выбор TexTerra

28 лучших нейросетей для видео: проверенный список

Как составлять запросы к нейросетям: примеры, настройки, параметры

*Facebook принадлежат Meta, которая признана экстремистской организацией и запрещена на территории РФ