Зачем удалять страницу из индекса

Удаление страниц из результатов поиска целесообразно проводить в следующих случаях:

- страница содержит устаревший контент;

- страница содержит персональные данные;

- страница с дублированным контентом;

- страница с неуникальным контентом;

- удаление технических / служебных страниц;

- страницы с ограниченным доступом.

Крайне редко владельцам бизнеса удается самостоятельно выявить эти ошибки и принять меры по их устранению. Если вы не уверены, что ваш сайт работает идеально, – обратитесь аудитом и внутренней оптимизацией ресурса к «Текстерре». Выявим и устраним ошибки, сделаем сайт удобным для поиска, увеличим поисковый трафик и подготовим план дальнейшего продвижения.

Проверяем индексацию страницы

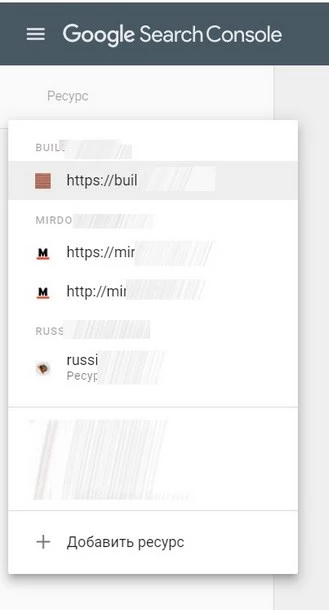

Прежде чем удалять страницу, необходимо проверить, находится ли она в индексе вообще. Отдельно проверяем индексацию в Google и отдельно – в «Яндекс». Начнем с первого.

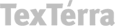

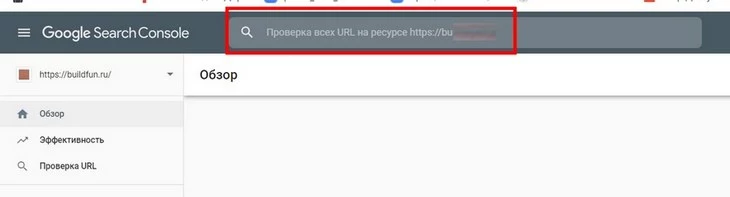

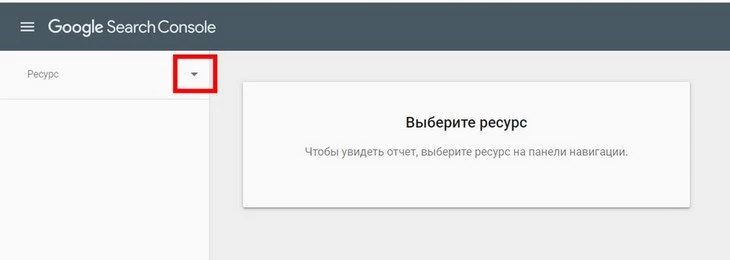

Запускаем инструмент Index Coverage Report.

Откроется Google Search Console. Мы должны выбрать домен, на котором размещается проверяемая страница:

Вводим полный адрес интересующей веб-страницы и нажимаем Enter:

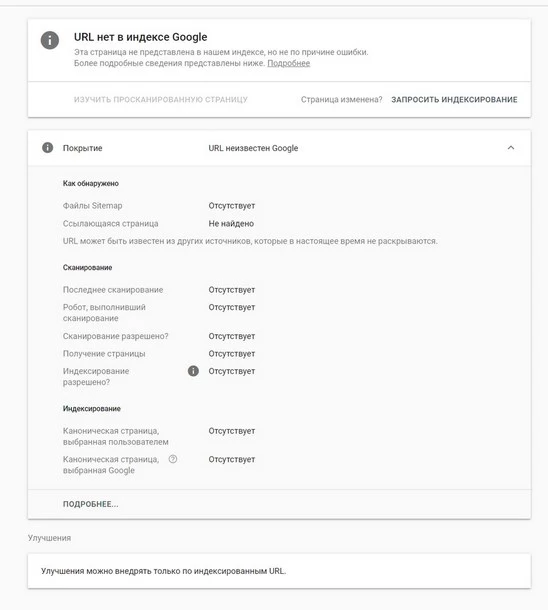

Если проблемная веб-страница уже «выпала» из индекса Google, вы получите такое сообщение:

Это значит, что проблемная веб-страница в настоящий момент не может присутствовать в поиске.

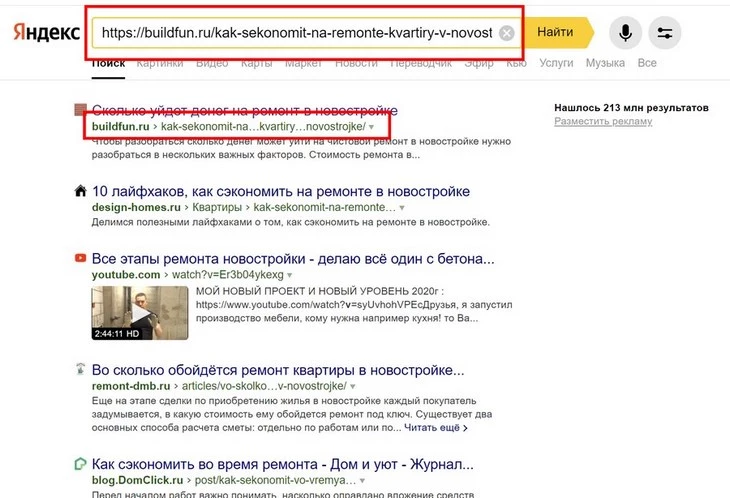

Еще один способ проверить индексацию любой веб-страницы в Google (и, кстати, в «Яндексе» тоже) – ввести ее полный URL в поисковую строку:

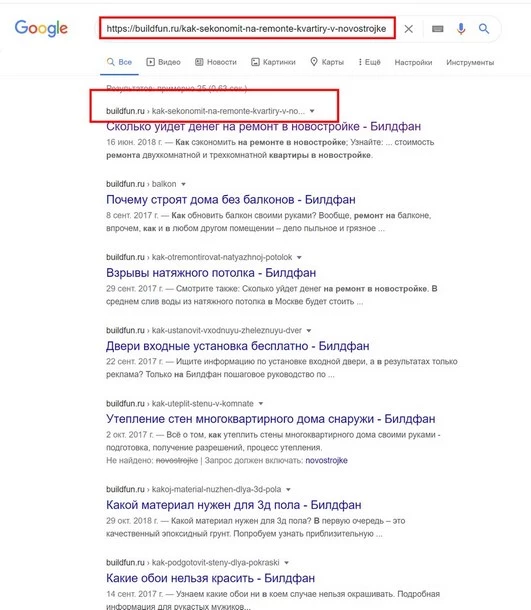

Да, так просто. Если искомая веб-страница уже проиндексирована, вы увидите соответствующий результат:

Пример проиндексированной веб-странице в SERP Google

Пример проиндексированной страницы в «Яндексе»

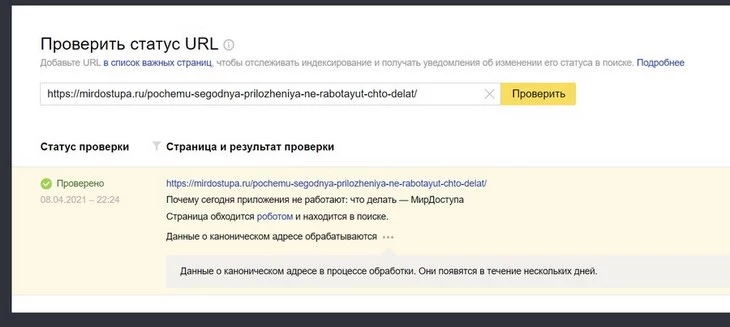

Проверить индексацию любой веб-страницы в «Яндексе» можно при помощи инструментов «Яндекс.Вебмастер». Просто открываем его и в разделе «Индексация» выбираем пункт «Проверить статус URL». Можно проверять индексацию только у тех веб-страниц, которые относятся к подтвержденным доменам (у вас должны быть права на сайт, чтобы вы могли «стереть» URL). Если веб-страница находится в индексе отечественного поисковика, вы увидите у нее соответствующий статус:

Почему не стоит проверять индексацию оператором site:

Проблема оператора site: заключается в том, что показывает не только страницы в индексе, но и URL с перенаправлением или с настроенным каноникал. Если в прошлом сайт был перенесен на другой домен, то через site: вы можете увидеть страницу с абсолютно другим заголовком / описанием.

Как удалить страницу сайта из поиска Google

Не срочное удаление страницы

Мне нужно удалить контент веб-страницы или всю страницу целиком, но не срочно. Например, контент перестал быть актуальным. Я согласен, если еще какое-то время (пару недель) она продолжит «болтаться» в кэше Google (значит, иногда появляться в SERP).

В вышеуказанном случае можно порекомендовать просто удалить содержимое страницы целиком.

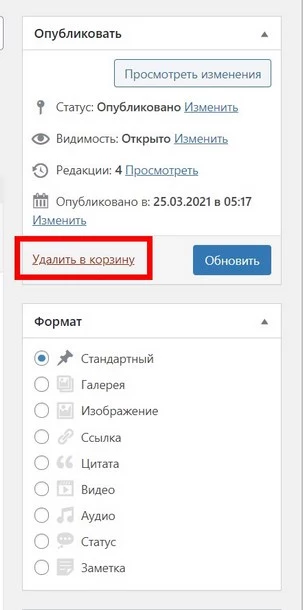

Удаление веб-страницы немного отличается в каждой CMS. Например, в WordPress необходимо открыть страницу в редакторе и выбрать пункт «Удалить в корзину»:

Удаленная страница со временем начнет отдавать ошибку 404. Через несколько дней краулеры Google автоматически исключат такую страницу из индекса.

Объединение нескольких страниц и указание главной

У меня есть несколько версий одной страницы. Я хочу объединить все эти страницы и перенести их на единый URL. Контент на этих страницах является практически не отличается.

В таком случае нужно использовать единый каноникал-тег. О том, как указать каноническую страницу – в справке Google.

Учите, что rel canonical указывает на веб-страницу, которая является главной, а не второстепенной.

Здесь следует иметь в виду, что каноникал-тег не является прямой директивой. Соответственно, краулеры могут его игнорировать.

Кстати, кроме тега можно использовать перенаправление (лучше 301-ое) и параметры после URL (параметры следуют сразу после знака "?"). О том, как блокировать обход дублированного контента, содержащего параметры, —в справке Google Search Console.

Каноникализацию можно сделать несколькими способами. Выбирайте тот инструмент, которым владеете лучше.

Срочное удаление страницы из результатов поиска

Мне нужно как можно быстрее удалить страницу из индекса. У меня нет времени возиться с канониклами / ограничением доступа / метатегами. Речь идет о конфиденциальных данных или об исполнении решения суда.

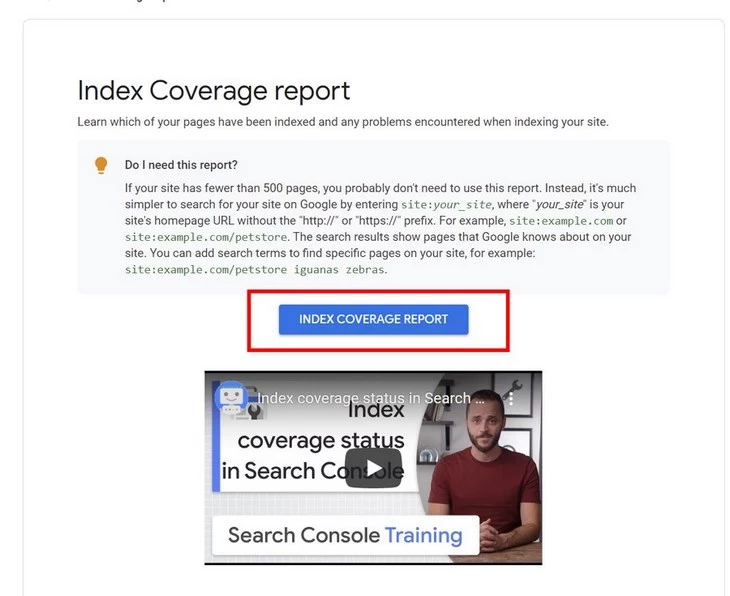

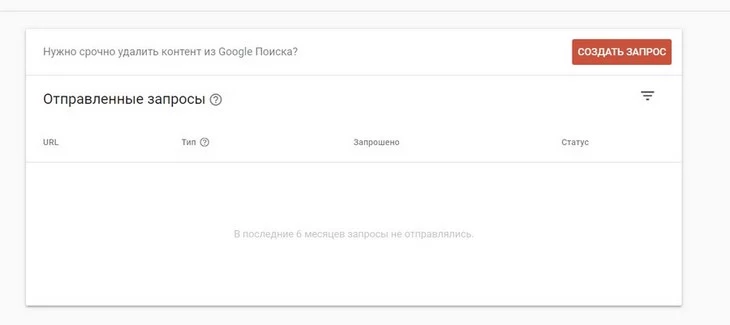

В этом случае нужно использовать «Инструмент удаления URL». Открываем инструмент и выбираем сайт:

Создаем запрос:

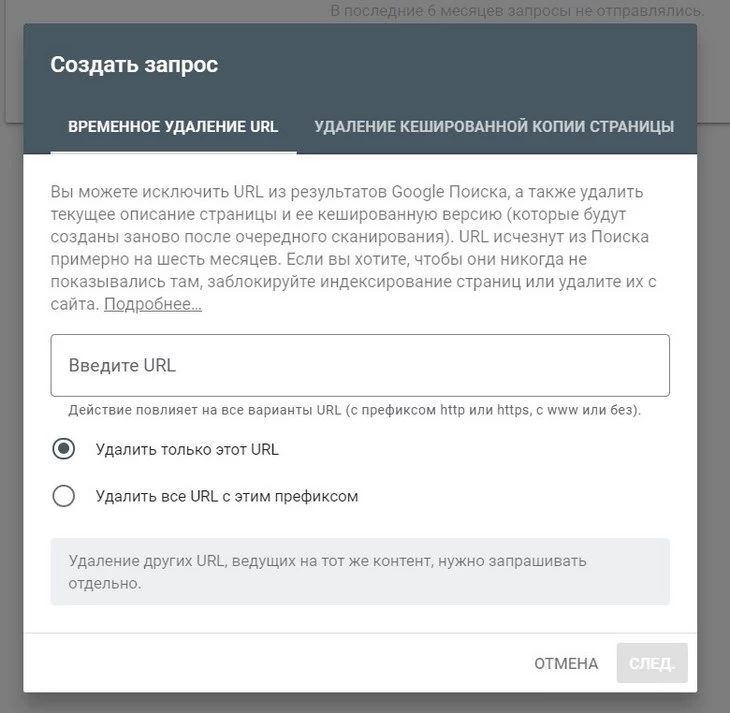

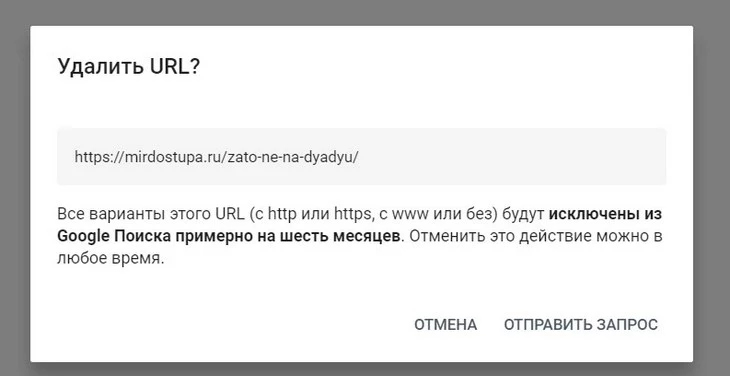

Указываем полный URL страницы, которую нужно скрыть:

Кстати, здесь же можно удалить все URL с текущим префиксом и скрыть кэшированную копию страницы. Подтверждаем запрос:

Инструмент не удаляет страницу из индекса в буквальном смысле, а лишь убирает ее оттуда на 6 месяцев, после чего вы должны принять финальное решение: удалить все содержимое страницы целиком либо ограничить доступ к странице.

Инструмент действует не мгновенно: скрывает проблемную страницу в течение 24-х часов.

Это самый быстрый способ показать Google, что страница должна быть удалена из результатов поиска.

Страницу нужно удалить из поиска, но она должна быть доступной

Мне нужно удалить всю страницу из индекса, но после этого она должна быть доступна определенным посетителям сайта.

В этом случае нужно использовать ограничение доступа к странице. Сервисов и инструментов для этого много, но чаще всего используется ограничение по IP или организация доступа к странице по паролю. Здесь, опять же, сложно советовать что-то конкретное, так как ваши конечные цели сложно предугадать. По сложности внедрения оба способа примерно одинаковые.

Ограничение доступа по IP или вход по паролю – отличный сценарий для тестовых этапов разработки сайта (например, при внедрении нового функционала) или для внутренних сетей. Страницы с ограниченным доступом никогда не попадут в индекс «Яндекс» и Google.

Ограничить доступ к определенной странице можно при помощи учетных записей на сайте, но это трудоемкий способ.

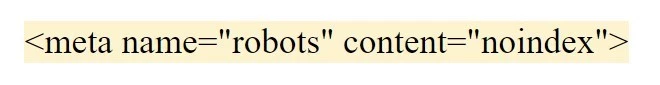

Ограничить доступ к странице всем пользователям и сохранить его для некоторых посетителей можно при помощи мета-тега robots. Для этого необходимо добавить в него директиву noindex. На практике выглядит такой тег следующим образом:

При помощи директивы noindex в robots вы даете понять краулеру: выбранная страница не должна находиться в SERP.

Удаление изображения из результатов поиска

Мне нужно удалить картинку из результатов поиска / «Google Картинок»

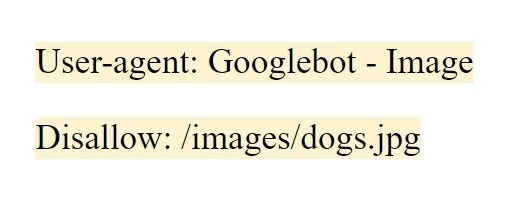

Здесь я рекомендую использовать атрибут disallow, который нужно указать в robots.txt. Никаких сложностей с этим точно не возникнет.

Вы можете ограничить обход как одной, так и сразу всех картинок. Все, что нужно для этого, – знать имя краулера. Это Googlebot – Image.

Например, мы хотим удалить картинку, значит, прописываем такой атрибут:

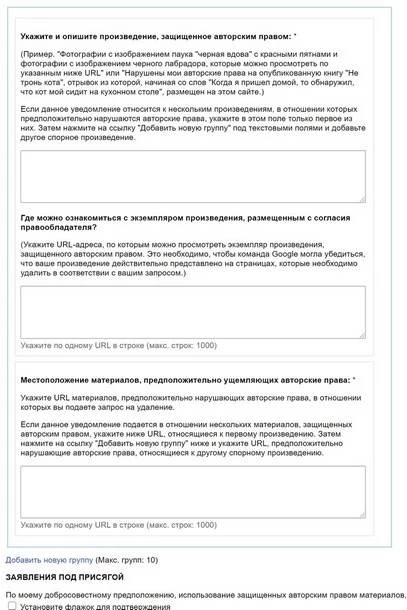

Удаление ссылки на страницу с контентом, защищенным копирайтом

Я хочу удалить материалы, нарушающие мои или чужие авторские права

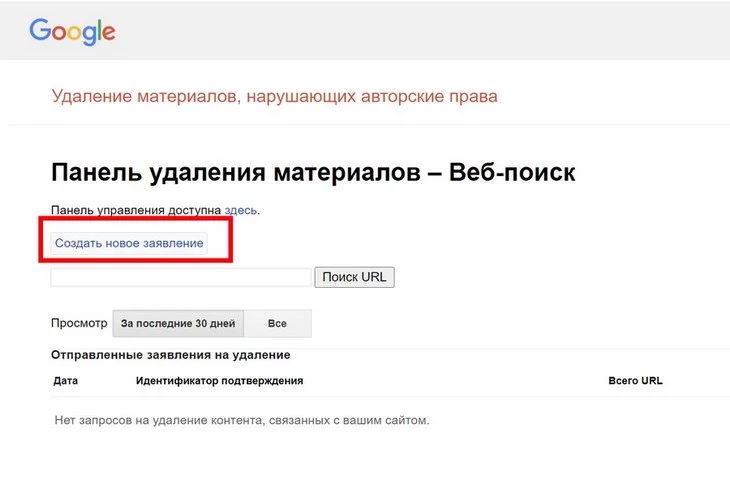

Вам необходимо создать заявление в специальном инструменте для вебмастеров Google (называется DMCA).

Выбираем пункт «Создать новое заявление» и заполняем всю контактную информацию:

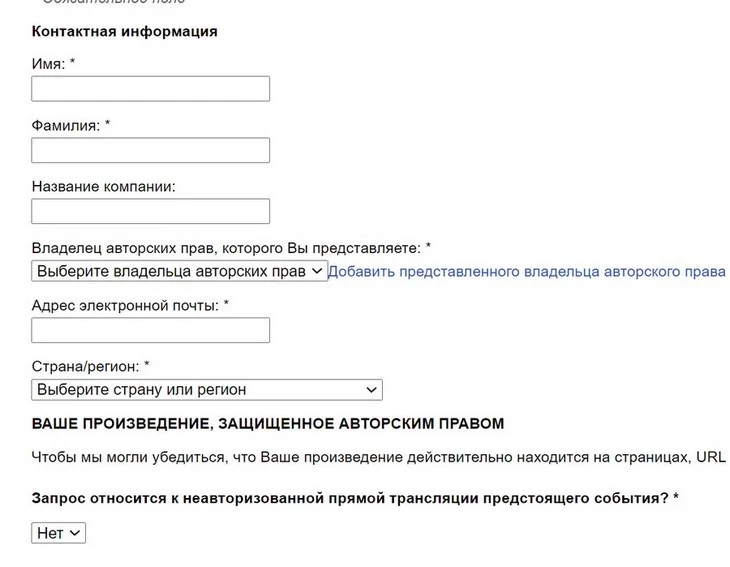

Указываем персональные данные, электронную почту, название компании и страну проживания:

аполняем контактную информацию

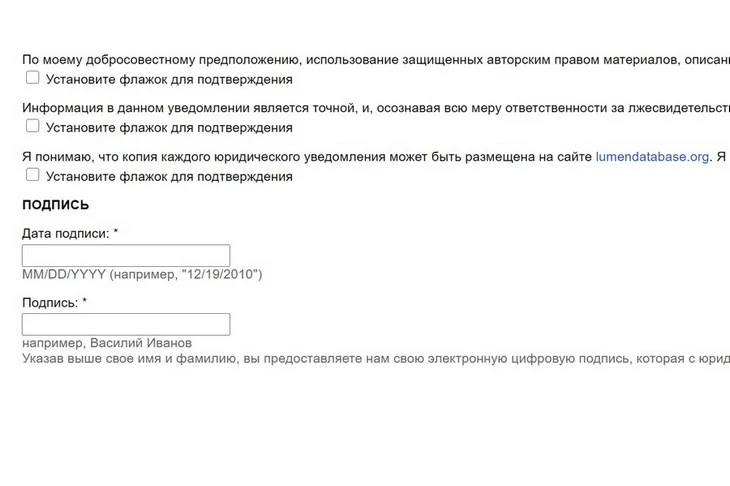

«Подписываем» заявление

Как видим, потребуется описать произведение, защищенное копирайтом, и указать ссылку, где оно размещается легально. Потребуется указать и точное расположение материалов (в виде ссылки), ущемляющих ваши авторские права:

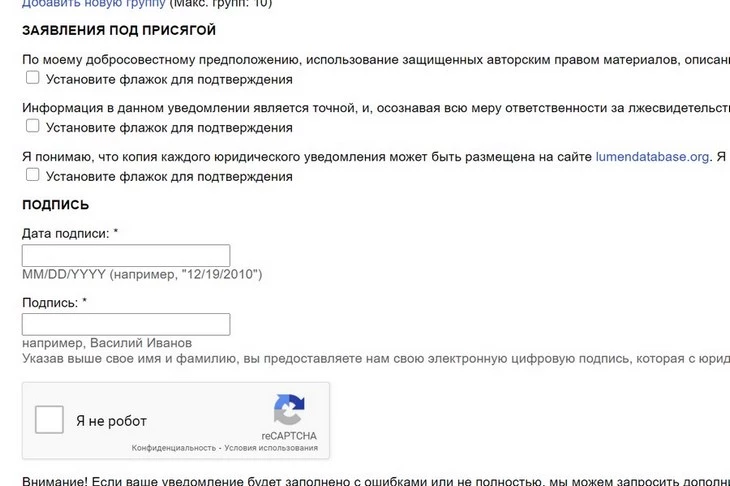

Не забываем отметить чекбоксы и дать согласие на то, что эта форма заполняется «под присягой»:

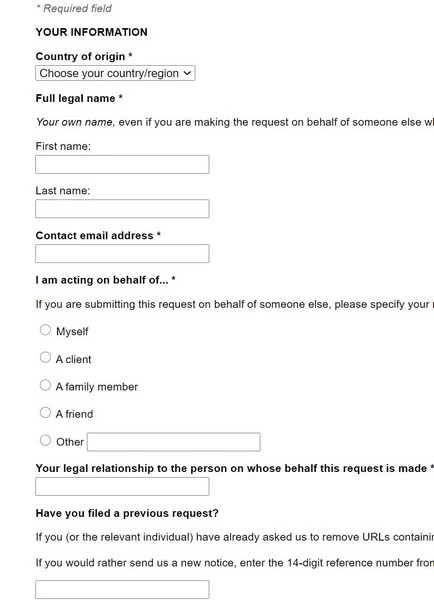

Удаление ссылки на страницу, содержащую персональные данные

Я хочу удалить персональные данные, которые появились на определенном сайте в интернете.

Для этого используйте инструмент «Удаления конфиденциальности». Он создан специально для ЕС, но мне известны как минимум 2 случая, когда он помогал удалить персональные данные и граждан РФ.

Понадобится заполнить страну проживания, фамилию и имя, электронную почту. Можно отправить запрос от имени родственника / члена семьи / друга / клиента. В этом случае понадобится указать степень родства (если речь идет о родственнике):

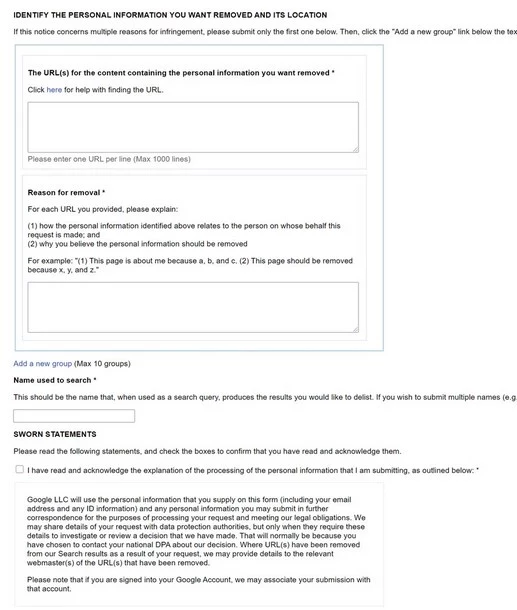

Далее указываем ссылки на действующие веб-страницы, содержащие ваши персональные данные:

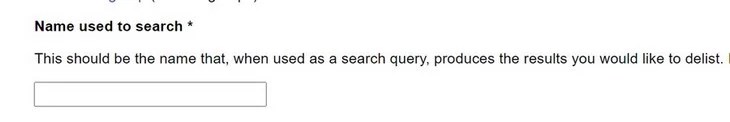

Указываем поисковую фразу (в этом случае – имя и фамилия), по которой в результатах поиска выводятся ссылки на веб-страницы, содержащие персональные данные (ваши или доверенного лица):

Читаем соглашение Google о ПДн, отмечаем чекбоксы и подписываем документ:

Как удалить / стереть страницу из результатов поиска «Яндекс»

Теперь о том, что предлагает «Яндекс» для удаления URL из поиска.

Для эффективного удаления URL навсегда отечественный поисковик советует использовать уже знакомую директиву disallow. Ее следует указывать прямо robots-файле.

Второй способ. На удаляемой странице нужно прописать метатег robots (не забываем про директиву noindex).

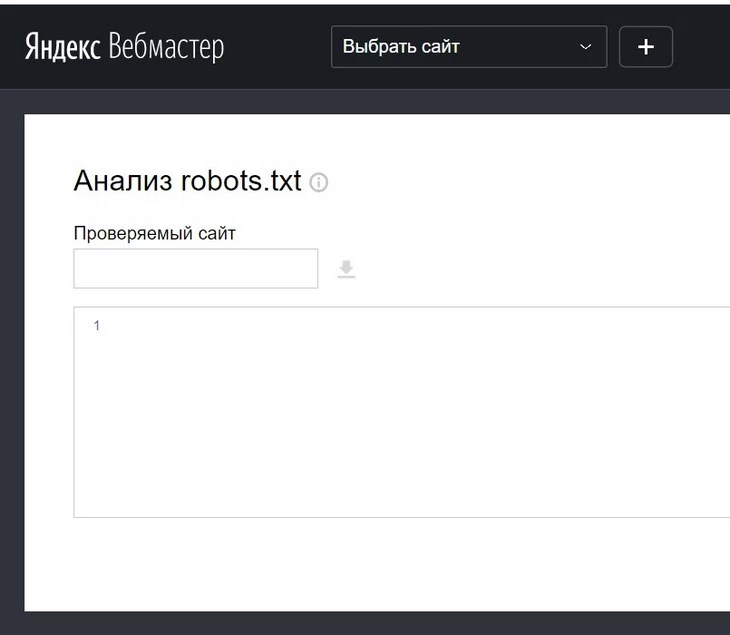

Здесь стоит отметить, что бот-краулер отечественного поисковика первым делом анализирует именно robots-файл и только потом начинает сканировать саму веб-страницу. Убедитесь, что robots.txt содержит корректные указания. Для этого вы можете использовать специальный инструмент:

Еще один вариант – настроить HTTР-статус (он должен быть настроен у самой удаляемой веб-страницы). В последнем случае вы должны настроить точное перенаправление (404-ый или же 403-ий редирект).

Если вы сделали прямое запрещение на сканирование веб-страницы в системной файле robots, краулеры перестанут сканировать проблемную веб-страницу примерно спустя 24 часа (или быстрее).

Другой сценарий. Вы «сотрете» веб-страницу при помощи robots-тега (или же сразу настроите редирект http-статусом), а краулер продолжит сканирование проблемной веб-страницы (точно сказать нельзя, но в течение нескольких дней). Страница и спустя пару дней остается недоступной и не обновляется? Значит, она будет автоматически удалена из SERP «Яндекса » в ближайшее время.

Как ускорить удаление URL в «Яндексе»

Вы можете повлиять на скорость удаления URL. Первым делом уничтожьте веб-страницу через админку используемой CMS (URL должна отдавать 404-ой код). Вы можете удалить и целую группу URL, если в этом возникает необходимость.

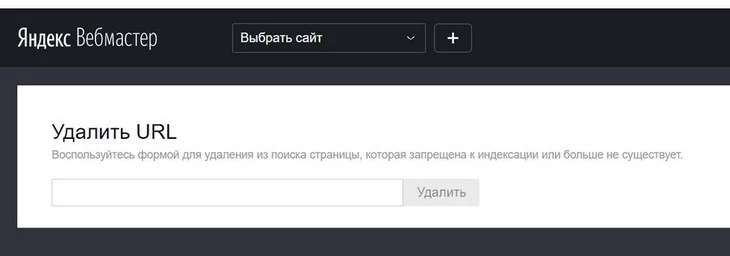

Кстати, «Яндекс» позволяет удалить страницу из поиска даже в том случае, если вы не являетесь владельцем сайта и у вас отсутствуют права на домен (где размещается страница, которую вы хотите удалить) в «Яндекс.Вебмастере». Откройте инструмент и укажите проблемный URL:

Этот инструмент может помочь вам, только если для удаления URL есть какие-либо основания. К ним можно отнести 403-ий / 404-ый / 410-ый коды, прямое ограничение индексирования в robots.txt или запрещение метатегом noindex.

Если права на сайт в «Я.В» у вас подтверждены, вы сразу сможете стереть до пятисот URL в сутки.

Это все способы, при помощи которых Вы можете удалить страницу из индекса «Яндекс» и Google. Теперь предлагаю рассмотреть самые распространенные ошибки, которые могут возникнуть при удалении страниц.

Как не надо удалять страницу из поиска

Nofollow – только рекомендация

Использование Nofollow, когда требуется исключить страницу из индекса.

Этот способ вообще не работает, так как nofollow – всего лишь рекомендация для краулера и он, скорее всего, не будет ее соблюдать.

Тег noindex уже не работает

Использование тега noindex для запрещения индексации через robots.txt.

Раньше этот способ частично работал, но еще в 2019 году Google объявил, что отныне noindex в robots.txt не поддерживается.

Каноникал на другой URL

Страница с каноикл-тегом, которая ведет на иной URL.

Каноникал используется для указания главной страницы, требующей индексации. Noindex же говорит краулерам, что страница не должна находиться в индексе. Тут возникает конфликт. Поэтому не используйте страницы с каноникл-тегом, указывающие на другие URL.

Блокировка поисковых роботов в robots.txt

Блокировка краулеров через файл robots.txt.

Так вы лишь рекомендуете краулеру не обходить страницу, но он все равно может ее просканировать по своему усмотрению и даже включить ее в SERP.

Канониклы настраиваем в тех случаях, когда проблемная страница нужна в рамках сайта. Когда не нужна, настраиваем 301-ое / 404-ое перенаправление.