Перед тем, как страница попадет в поисковую выдачу, она должна пройти долгий и увлекательный путь. Сперва ее обходят краулеры, которые есть у каждой поисковой системы. Затем, если контент достаточно качественный и представляет ценность, страница попадает в SERP. Вроде бы все просто, быстро и удобно, правда?

В тени остается сам процесс индексации, его алгоритмы и механизмы. Есть ли там что-то интересное и полезное для нас? Да, есть, и немало! Сегодня остановимся на процессе индексирования. Узнаем, что это такое, как происходит, а также поймем, можно ли повлиять на скорость добавления новых страниц в Google и «Яндекс».

В чем разница между индексированием и ранжированием

Начинающие вебмастера и оптимизаторы часто путают индексирование с ранжированием. Эти понятия взаимосвязаны, но обозначают разные явления и процессы.

Ранжирование – конечная сортировка сайтов, которые находятся в выдаче, и присвоение им определенных позиций или рангов. Конкретный ранг может быть дан определенной странице, когда она окажется в индексе, и только в тот момент, когда пользователь осуществит поиск по какой-то фразе. Такой порядок внедрен, чтобы обеспечить наличие максимально релевантных страниц в результатах поиска.

Индексирование – процесс добавления (обновления) данных о странице.

Как работает индексирование

Индексирование происходит благодаря краулеру: он обходит страницы всех сайтов в интернете и отправляет получаемую информацию в базу данных поисковой системы. Она и называется индексом. В дальнейшем собранные данные задействуются по-разному. Частично – для выстраивания ранжирования и формирования максимально релевантных поисковой фразе результатов поиска. Частично – для иных, например, служебных целей.

Поисковик может использовать данные только с тех страниц, которые уже были проиндексированы им. Пока первичная индексация не состоялась, его не будет существовать для Google. Зато после Google быстро найдет любую информацию в своих базах данных, и поиск по нескольким миллионам страниц займет считанные миллисекунды.

Стоит отметить, что, даже если краулер уже «обошел» страницу, это не гарантия того, что она мгновенно или вообще когда-либо попадет в поисковую выдачу. Да, краулер обходит абсолютно все страницы, но в SERP попадают только страницы с полезным и уникальным контентом.

Тяжело создавать контент, который удовлетворит не только запросы поисковиков, но и пользователей? Обращайтесь за помощью в «Текстерру».

Обмануть поисковую систему точно не удастся, а если и удастся, то ненадолго: для распознавания некачественного контента у Google есть собственные наработки, защищенные патентами.

Индекс E-A-T, рейтинг Page Quality и алгоритм BERT – все эти разработки позволяют точно определять полезность контента на странице и автоматически распознать его качество. В их основе лежит взаимодействие машинного обучения и других разработок Google, связанных с оценкой пользовательского опыта.

Что представляет из себя индекс Google

Как мы уже выяснили выше, индекс – это большая база данных, которая состоит из нескольких ключевых разделов. Углубляться в них не буду – это не так важно. Скажу лишь, что в этой базе данных имеются сведения о нескольких миллионах страниц. При сканировании краулеры «ощупывают» не только видимую посетителю текстовую информацию страницы, но и другие данные: атрибуты документа, информацию из тегов (alt, title, description), другие технические данные.

Как выглядит индекс Google

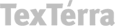

Google использует так называемый инвертированный (преобразованный в противоположную сторону) индекс. Условно, краулеры сперва проверяют код ответа сервера, затем – данные из хед и данные по индексации. Только после всех этих технических проверок следует проверка текста. Схематично инвертированный индекс выглядит следующим образом:

Как создается индекс Google: все этапы

Если представить формирование индекса поэтапно, он будет включать в себя четыре стадии.

- Первая – извлечение текста. На этой стадии происходит конвертирование страницы и «удаление» с нее всех вспомогательных элементов: текст отделяется от остальных составляющих, включая изображения, разметочные и структурные элементы.

- Вторая – формирование списка слов-лексем. Краулер формирует специальную выборочную совокупность. Делается это, чтобы в дальнейшем выделить так называемую лексему. Если вы имеете какое-то отношение к изучению русского языка, то знаете, что в лингвистике термин «лексема» передает некое слово или выражение, которые принято считать за одну единицу. Собственно, аналогичные лексемы выделяются и на втором этапе индексирования страницы. Лексемы собираются со всех текстов (точнее, выделяются со всех слов), которые есть на странице.

- Третья – упорядочивание и обработка. На этой стадии все сформированные лексемы выстраиваются в алфавитном порядке, нумеруются. Так каждая лексема получает собственный номер страницы (обозначает первоначальный источник происхождения лексемы) и номер вхождения.

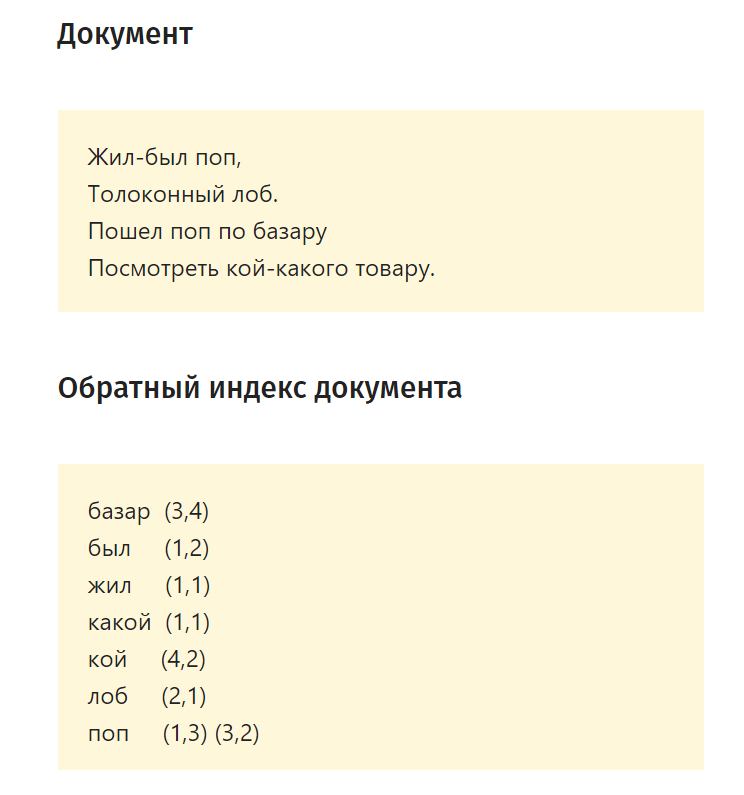

- Четвертая – формирование индексной записи. Выглядит она следующим образом:

Краулеры могут сформировать и более сложную запись, но ее скелет все равно будет иметь в основе нарисованную выше схему.

Можно ли ускорить индексирование новых страниц

Можно, но не прямым образом. Если страница долго не появляется в результатах поиска, нужно убедиться, что она не закрыта для краулеров.

Для этого открываем системный файл robots.txt (он находится в корневой директории). Допустим, для сайта mirdostupa.ru файл robots.txt будет находиться по адресу mirdostupa.ru/robots.txt. Проверяем наличие запрещающего тега для интересующего URL. Выглядеть он может так:

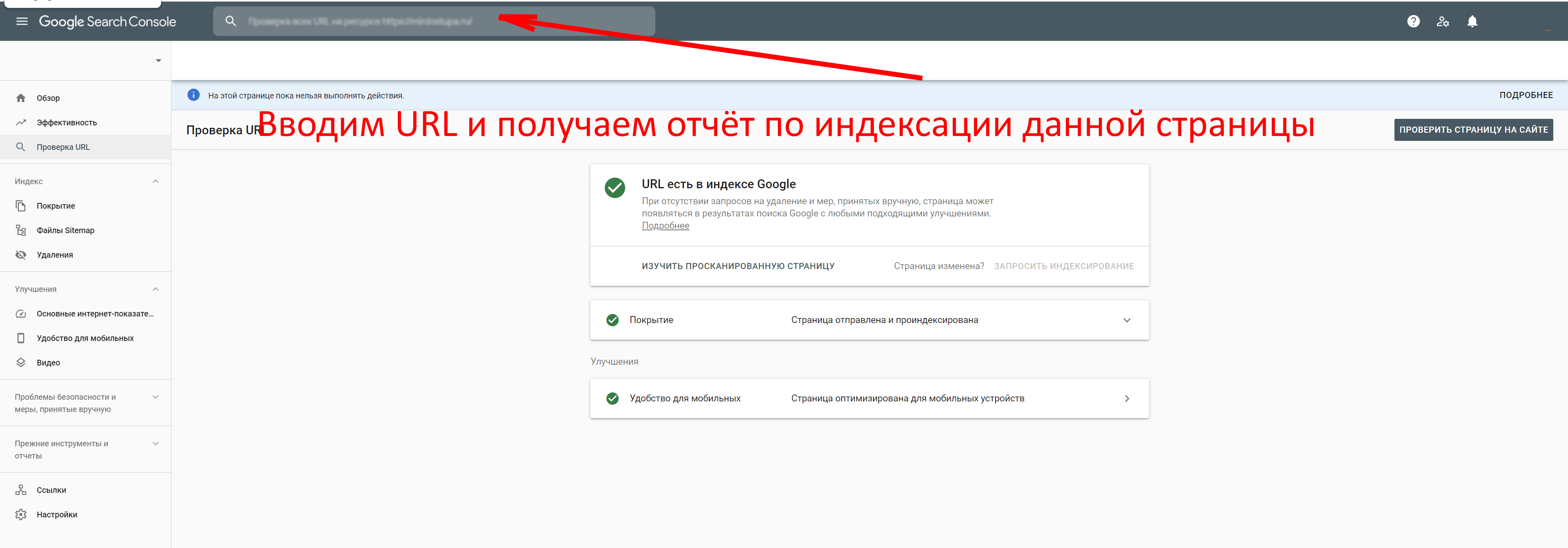

Чтобы проверить состояние страницы в Google, открываем инструменты вебмастера:

При необходимости здесь же запрашиваем повторное индексирование (если страница так и не попала в индекс).

Чтобы добавить новую страницу в «Яндекс», можно воспользоваться служебным инструментом «Переобход страниц», который присутствует в «Яндекс.Вебмастере», но такое добавление не гарантирует попадание в индекс:

Чтобы новые страницы индексировались быстро и без проблем, необходимо следить за качеством контента. Естественно, в Google и «Яндекс» не будут попадать мусорные страницы, содержащие только поисковый спам и SEO-оптимизацию. Все элементы страницы должны находиться на своих местах, включая теги, картинки, названия и описания.

Как закрыть страницу сайта от индексации / удалить ее из Google

Хотите скрыть определенную страницу от краулеров (например, технические страницы или страницы с данными пользователей, включая конфиденциальную информацию)? Для этого есть три способа: использование тега robots, добавление запрещающей директивы в системный файл robots.txt, использование инструментов Google и «Яндекса». Рассмотрим все три способа подробнее.

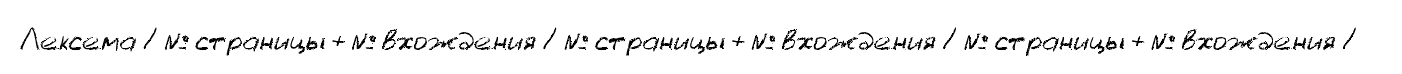

Чтобы закрыть страницу от индексации при помощи мета-тега Robots, достаточно добавить в заголовок страницы (<head>) следующий код:

<meta name="robots" content="noindex, follow"/>

Теперь о запрещающей директиве в robots.txt.

В этом файле прописываются наши «пожелания» для поисковых ботов, но исполнять их будут на свое усмотрение. Чтобы «попросить» краулера не обходить страницу, достаточно добавить в robots следующую запись:

- User-agent: * # вставить название поисковой системы

- Disallow: /catalog/ #вставить ссылку на страницу

Теперь об инструментах вебмастера. Открываем «Инструмент удаления URL», выбираем домен и пункт «Создать запрос». указываем ссылку и выбираем пункт «Удаление страниц». Далее следуем подсказкам инструмента, чтобы удалить URL из результатов поиска. После завершения отправки данных страницы будут удалены из индекса Google через некоторое время.

Как удалить страницу из результатов поиска «Яндекса»

Для удаления конкретной страницы из результатов поиска проще всего воспользоваться инструментом «Удалить URL». Запретить индексацию можно директивой Disallow, которую нужно добавить в уже знакомый нам системный файл robots.txt:

User-agent: Yandex

Disallow: /вставить_URL #

Как узнать, проиндексирована ли страница

Проверить состояние страницы в индексе поисковых систем можно несколькими способами. Самый простой заключается в ручном вводе URL страницы в строку поиска Google / «Яндекса». Если страница уже попала в индекс, она будет отображаться в результатах поиска. Если нет, совпадений, соответственно, не будет.

Как увидеть все страницы сайта, которые находятся в индексе

Для этого в поисковой строке вводим оператор вида site:вставитьвашсайт.ru, например: site:texterra.ru. В результатах поиска мы увидим все страницы, которые сейчас находятся в индексе Google:

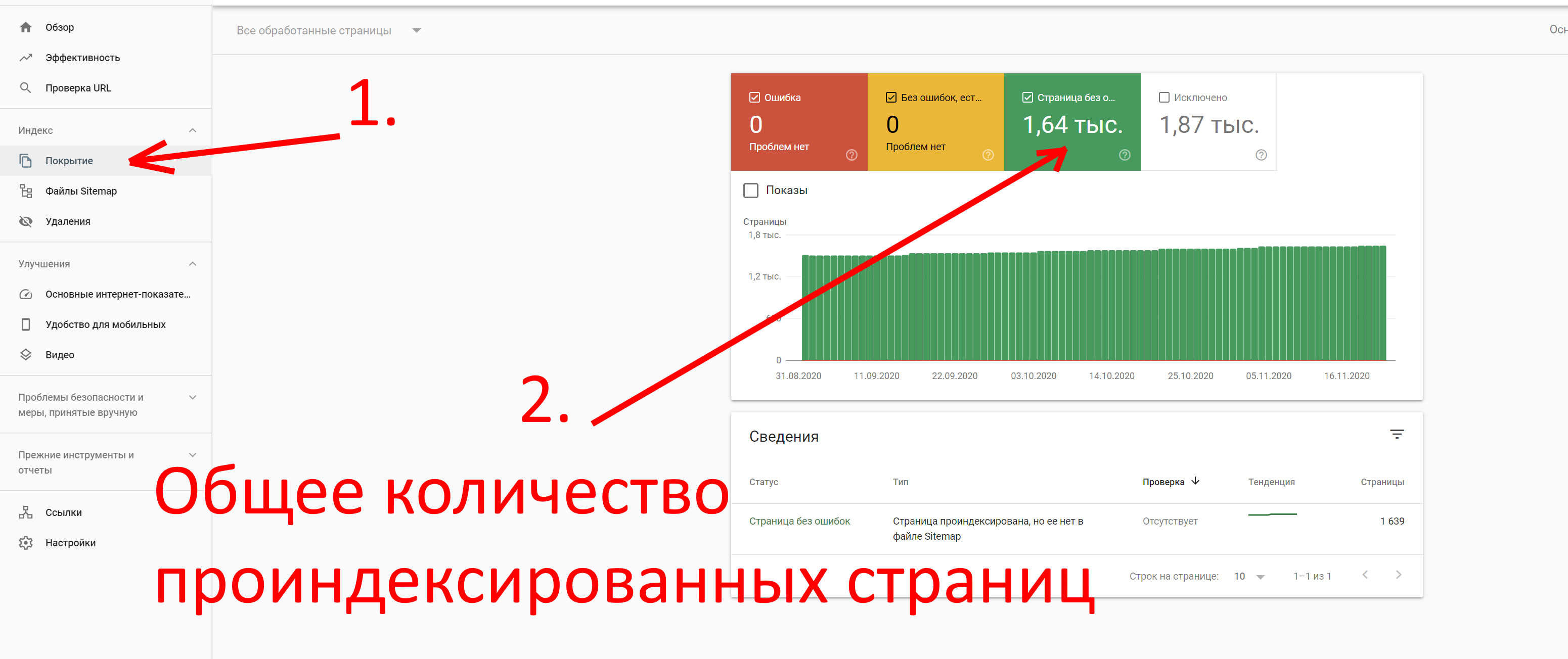

Увидеть количество проиндексированных страниц можно также в Google Search Console. Открываем раздел «Индекс» и выбираем пункт «Покрытие». Здесь отобразится общее количество проиндексированных страниц:

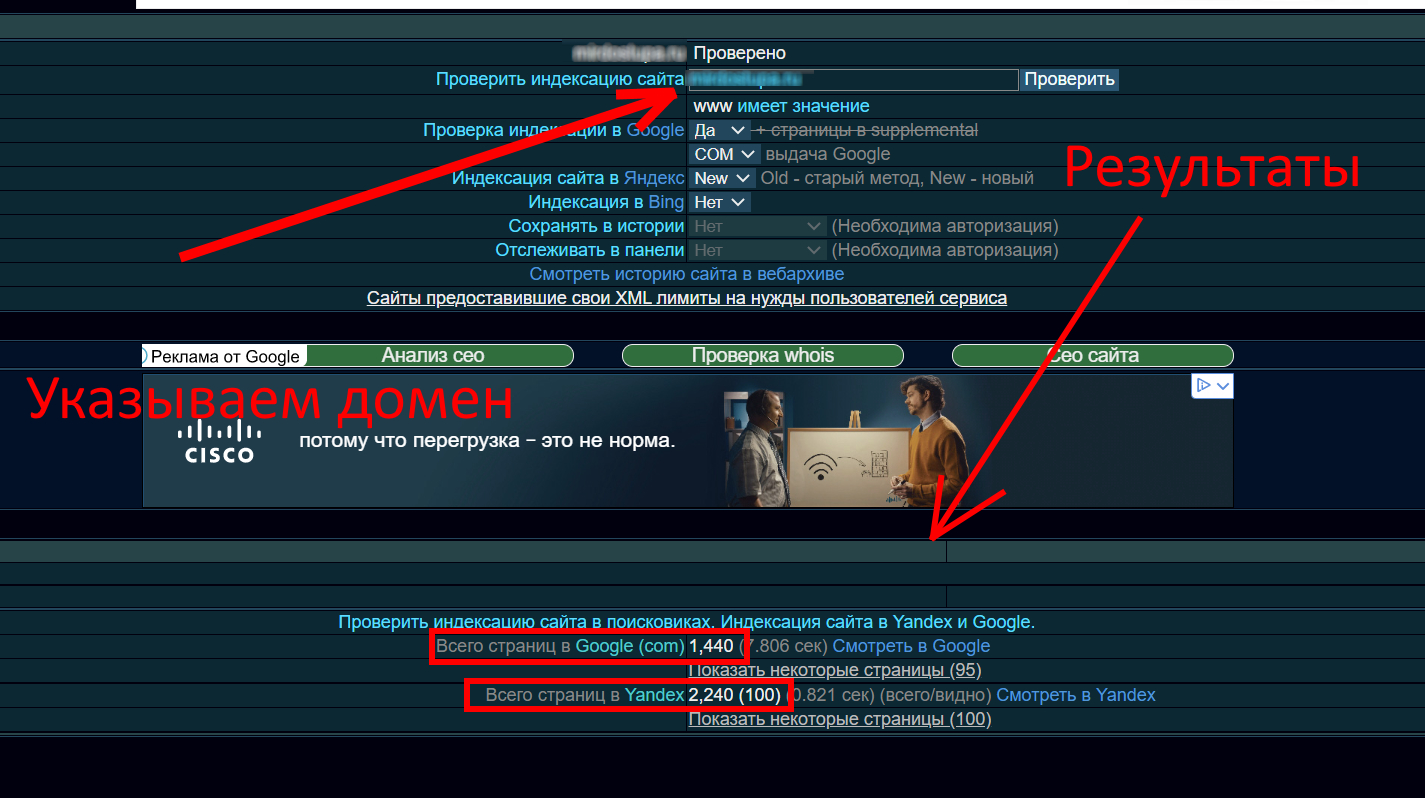

Кроме этого, узнать, сколько страниц находится в индексе «Яндекса» и Google, можно при помощи сервиса xseo. Пользоваться им просто: достаточно указать домен и выбрать пункт «Проверить»:

Почему проиндексированная страница может покинуть SERP

Причин выпадения из индекса довольно много. Я перечислю самые распространенные, с которыми сам регулярно сталкиваюсь:

- страница отдает 301-ый код – если настроено перенаправление, то в результатах поиска такая страница надолго не задержится;

- запрет индексирования настроен в системном файле robots.txt;

- дублирование контента;

- настроен каноникал-атрибут, который ведет на другую веб-страницу;

- на сайт были наложены меры пессимизации со стороны Google или «Яндекса»;

- страница отдает четырехсотые или пятисотые коды – краулер не будет учитывать такие веб-страницы вообще.

Послесловие

Индексирование – важнейший этап сбора данных о сайтах в интернете. Без индексации новые веб-страницы никогда бы не попали в поисковые системы. Повлиять на индексирование можно лишь непрямым образом: если мы указываем какие-либо команды в robots.txt, то мы даем краулерам лишь рекомендации.

Стоит отметить, что большие поисковые системы эти рекомендации соблюдают беспрекословно. Если ваши страницы преимущественно проиндексированы, но на поиске сайт почти невидим, значит, следует работать над качеством контента.

Проиндексируются все страницы, но бесполезный контент и поисковый спам никогда не будут ранжироваться наравне с качественными сайтами в результатах поиска.