Чтобы проанализировать весь контент, имеющийся на вашем сайте, вам потребуется пройти через два этапа: сбор данных и их анализ. Сегодня мы остановимся лишь на первом (так как объем информации большой, было решено подавать его порционно). Расскажем и наглядно покажем, как в автоматизированном режиме (с помощью простой таблицы Excel и одного потрясающего плагина) собрать все необходимые метрики, чтобы потом обработать их и понять, что именно хочет ваша целевая аудитория и как создавать контент, который будет неизменно пользоваться у нее популярностью.

Читайте также: Как выполнить анализ сайта конкурента

1. Сбор ссылок

Первое, что нам необходимо сделать, – это собрать все ссылки на контент вашего блога и поместить их в таблицу Excel. Для этого воспользуемся программой Screaming Frog. Программа платная, а в бесплатной версии есть ограничения по нужным нам функциям. Поэтому придется купить лицензию. После того как установите приложение, делаем так, как показано на следующей гифке: вводим раздел, в котором находятся все ваши материалы, убираем галочки, ставим фильтр по HTML и нажимаем Start.

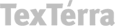

После того как программа просканирует ваш сайт, жмем Export и сохраняем отчет в формате Excel Workbook (.xlsx). Должно получиться следующее:

2. Создание таблицы

Анализировать контент мы будем по 4 параметрам:

- Категория поста vs расшаривания в соцсетях / бэклинки / комментарии

- День публикации vs расшаривания в соцсетях / бэклинки / комментарии

- Длина заголовка vs расшаривания в соцсетях / бэклинки / комментарии

- Длина статьи vs расшаривания в соцсетях / бэклинки / комментарии

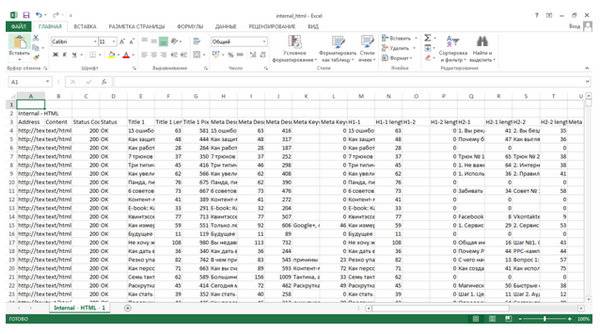

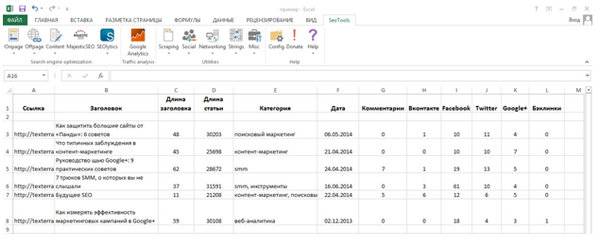

Поэтому большинство метрик в отчете нам не нужны. Удаляем все, кроме: Address (ссылка на статью), Title 1 (заголовок), Title 1 Length (количество знаков в заголовке) и Size (количество знаков в статье). И добавляем новые: Категория, Дата, Комментарии, Facebook*, Twitter, Google+, Вконтакте, Бэклинки. В итоге должно получиться следующее:

3. Установка плагина Seo Tools

Чтобы заполнить пустые разделы, воспользуемся плагином Seo Tools. Для его нормального функционирования потребуется последняя версия Microsoft .NET Framework. Чтобы скачать ее, необходимо перейти по ссылке.

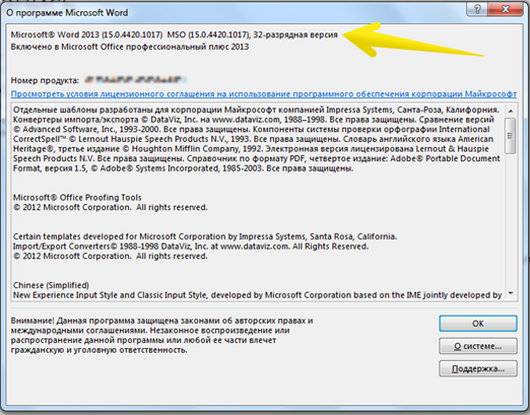

Далее необходимо определить, какая версия MS Office у вас стоит: 32- или 64-битная. Для этого заходим в MS Word, Файл – Учетная запись – О программе Word.

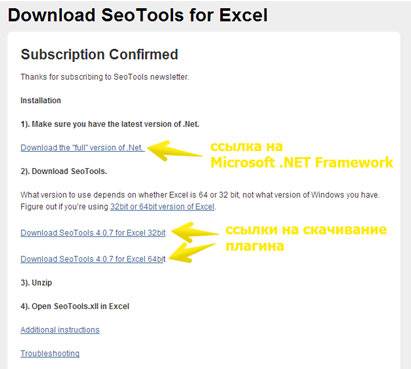

После того как вы узнали, какая версия у вашего MS Office, переходим по ссылке и нажимаем Download the latest version. Для получения ссылки на скачивание плагина Seo Tools, необходимо ввести email. Вводим и нажимаем Subscribe to list. Подтверждаем подписку и тут же попадаем на такую страницу:

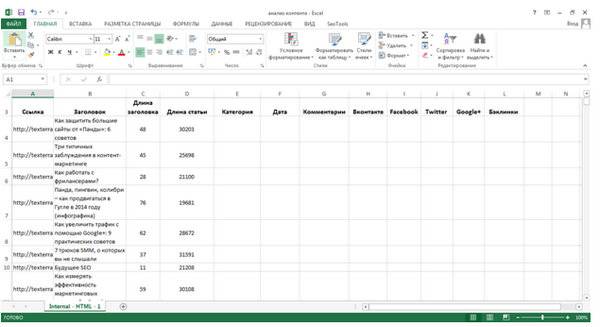

Скачиваем плагин нужной версии. Распаковываем его. Запускаем нашу таблицу и закидываем в пустое место файл под названием Seo Tools:

Все, плагин установлен. Если вы все сделали правильно, в меню, с самого правого края, должен появиться раздел Seo Tools. Осталось только собрать нужные метрики.

4. Дата

Начнем с самого простого, с даты. Переходим в раздел Seo Tools – Scraping – XPathOnURL и вводим в первую строку URL статьи.

Чтобы заполнить вторую строку, необходимо перейти в саму статью. Навести курсор на дату публикации. Сделать правый щелчок – Просмотр кода элемента. Еще раз правый щелчок – Copy Xpath.

После этого возвращаемся в Excel и вставляем скопированный код во вторую строку и все двойные кавычки заменяем на одинарные (апострофы). Запомните: это нужно делать всегда, иначе функция не сработает. В итоге должно получиться следующее:

5. Категория

То же самое проделываем и с категорией. Поскольку на нашем сайте немного необычно реализована функция категорий, разберем на примере другого сайта. Делаем абсолютно все то же самое.

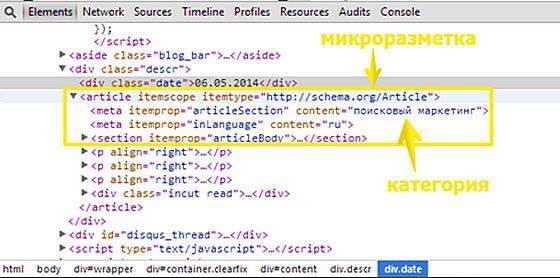

Как я уже сказала, на нашем сайте этот трюк проделать не удалось, потому что выбранная категория не прописывается в исходном коде. Но выход мы все-таки нашли. В наших статьях мы используем микроразметку Schema.org типа Article. И в ней мы каждый раз вручную прописываем категорию статьи. Поэтому эти данные нам все-таки удалось вытащить.

Заходим в код. Находим там микроразметку. Строку с категорией. Обратите внимание, у рубрики есть атрибут content (он нам понадобится позже).

Копируем Xpath и вставляем во вторую строку окошка. В третьей строке прописываем атрибут content.

Почему в случае с датой мы не прописывали атрибут, а здесь прописали? Честно, не могу объяснить это грамотно, т.к. я не программист, в всего лишь маркетолог. Поэтому скажу просто: если функция не срабатывает, значит нужно попробовать прописать атрибут. Метод научного тыка всегда актуален :)

6. Комментарии

Количество комментариев добывается по такому же принципу и, по идее, не должно вызвать у вас трудностей. Однако здесь есть одно «но». Если вы используете Disqus или какой-либо другой сервис, который динамически меняет данные, эта функция не сработает. Как определить, входите вы в эту категорию или нет? Для этого зайдите в исходный код страницы (ctrl + u) и попробуйте поискать там фразу, которую вы видите в блоке с комментариями. Например, если Disqus пишет:

Заходим в исходный код и ищем там эту фразу. Как видите, там ее нет:

Как собрать эти данные, кроме как вручную мне, к сожалению, пока неизвестно. Как разберемся, обязательно поделюсь с вами этой информацией.

7. Facebook*, Twitter, Google+

Расшаривания в Фейсбуке*, Твиттере и Гугл+ собираются очень легко, буквально в два клика. Вы просто выбираете раздел Social, нужную соцсеть и вставляется в появившуюся строку URL страницы. Элементарно. Очень жаль, что создатели этого плагина не включили в свой список Вконтакте. Тогда цены бы ему не было.

8. Вконтакте

А вот здесь у большинства пользователей, не имеющих навыков программирования, может возникнуть проблема. Сколько мы ни бились над плагином Seo Tools, сколько ни пытались, но собрать расшаривания Вконтакте этим способом нам не удалось. Поэтому единственным решением этой проблемы стало создание специального скрипта, который отсылает запрос на сервер Вконтакте и получает ответ в виде количества расшариваний. Если кто знает, как это можно сделать по-другому, будем очень благодарны, если вы поделитесь с нами в комментариях. А тем, у кого нет возможности создания подобного скрипта, придется собирать вручную. Инструкцию по его созданию дать мы вам не можем, т.к. скрипт пишется индивидуально под каждый сайт.

9. бэклинки/h2>

Плагин Seo Tools связан с сервисом Majestic Seo, с помощью которого можно собрать бэклинки. Но сервис платный и чтобы получить доступ к его возможностям, необходимо заплатить 2400 рублей.

Тем, у кого денег нет, кто продвигает свой сайт самостоятельно, придется собирать эти данные вручную. В этом вам поможет сервис ahrefs. Вводим ссылку и смотрим количество бэклинков. Очень удобно, но у данного сервиса (в бесплатной версии) есть один жирный минус – в день можно проверять не более 10 линков. Так что, если у вас большой сайт, все-таки придется раскошелиться.

Что получилось?

В итоге у нас получилась вот такая табличка.

Пока это просто данные. И с первого взгляда непонятно, какая статья оказалась более эффективной, а какая – менее. Чтобы обработать эту информацию, прочитайте следующую часть этой статьи – «Анализ контента. Часть 2. Обработка данных», либо закажите продвижения вашего сайта у нас.

P.S. Понравился материал? Поделитесь им со своими друзьями. Будем благодарны!

*Facebook принадлежат Meta, которая признана экстремистской организацией и запрещена на территории РФ